支持三种方式进行序列到序列任务的生成,包括

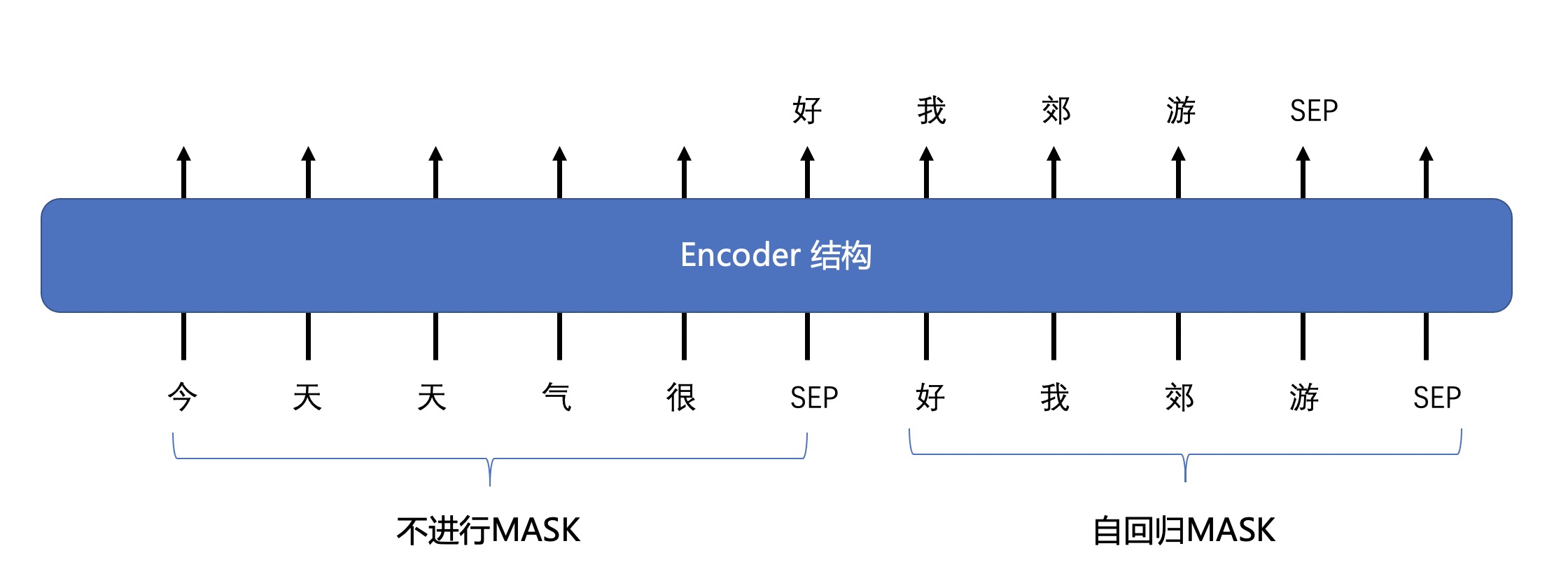

- 只用Encoder模型进行序列到序列的生成任务

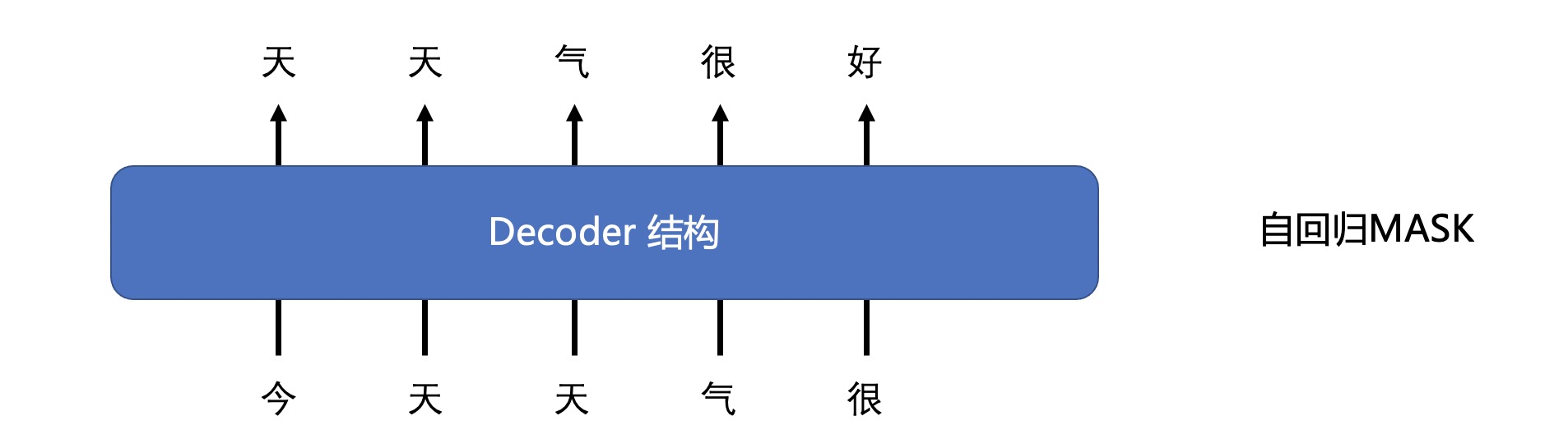

- 只用Decoder模型进行序列到序列的生成任务

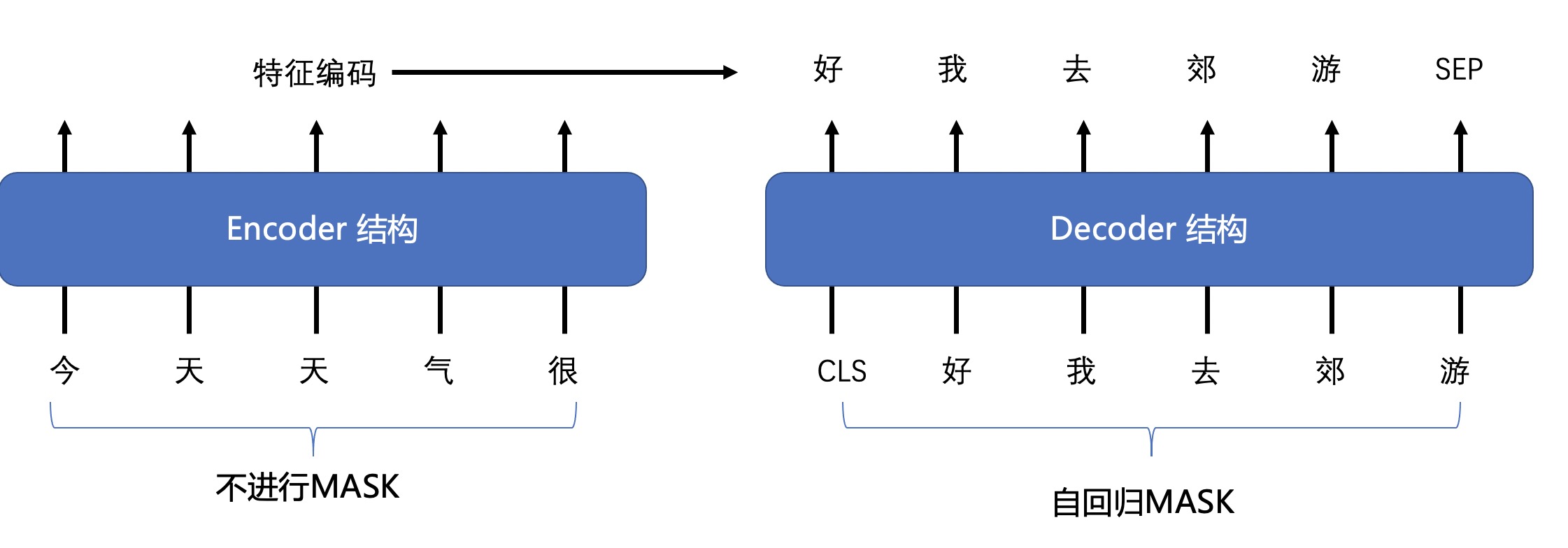

- 用Encoder+Decoder模型进行序列到序列的生成任务。

我们提供了encoder模型来执行seq2seq任务,例如,Bert、Roberta、GLM等等。

在训练过程中,我们在编码器模型中添加了一个特殊的 attention mask。(https://github.com/microsoft/unilm)

该模型的输入是两个句子:[cls]句子1[sep]句子2[sep]。

其中,句子_1不使用mask,而句子_2使用自回归mask。

该模型的输入是两个句子:[cls]句子1[sep]句子2[sep]。

其中,句子_1不使用mask,而句子_2使用自回归mask。

我们还为seq2seq任务提供了decoder模型,例如gpt-2模型。

我们还为seq2seq任务提供encoder-decoder模型,例如T5模型。