在阿里巴巴集团内,数据入员面临的现实情况是:集团数据存储已经达到 EB 级别,部分单张表每天的数据记录数高达儿千亿条;在20 1 6 年“双11 购物狂欢节”的24 小时中,支付金额达到了1 2 0 7 亿元入民币,支付峰值高达1 2 万笔/秒,下单峰值达17.5 万笔/秒,媒体直播大屏处理的总数据量高达百亿级别且所有数据都需要做到实时、准确地对外披露……巨大的信息量给数据采集、存储和计算都带来了极大的挑战。

《大数据之路一一阿里巴巴大数据实践》就是在此背景下完成的。本书中讲到的阿里巴巴大数据系统架构,就是为了满足不断变化的业务市求,同时实现系统的高度扩展性、灵活性以及数据展现的高性能而设计的。本书由阿里巴巴数据技术及产品部组织并完成写作,是阿里巴巴分享对大数据的认知,与生态伙伴共创数据智能的重要基石。相信本书中的实践和思考对同行会有很欠的启发和借鉴意义。

本书著作权归淘宝(中国〉软件有限公司所有,未经许可,不得以任何方式复制成抄袭本书之部分或全部内容。版权所有,侵权必究。

大数据是什么?在过去的5 年里,恐怕没有另外一个词比大数据更高频:也没有另外一个概念如大数据一样,被纷繁解读,著书立说。有趣的是,作为距离大数据最近的公司之一一一尽管我们的初心或许和大数据没有直接关系一一在关于大数据的理论和概念的争论中,阿里巴巴却鲜有高谈阔论。因为自知而敬畏,因为敬畏而谦逊。甚至在大数据这个概念出现很久之前,阿里巴巴就不得不直面、认知、探索,并架构和大数据有关的一切。数据作为一个生态级的平台企业最直接的沉淀,亦是最基本的再生产资料。如果没有基于大数据的入工智能的应用,淘宝根本不可能面对每天亿级的用户访问数量。因此,仅仅因为本能,阿里巴巴一开始就自然生长在这样一个数据的黑洞中,并且被越来越多、越来越密集的数据风暴裹挟。阿里巴巴在大数据方面所做的各种艰苦努力,其实就是力图对抗这种无序和复杂的情增,从中梳理结构,提炼价值。这是一个历经磨炼、也卓有成效的长期过程。如书中所提到的,阿里巴巴不仅数据量超宇宙级,而且更是因为业务场景的复杂和多元化,其面对着甚至超过 Google 和 Face book 的更复杂的难题。大部分时候,阿里巴巴都是在无入区艰难跋涉。每一组功能和逻辑,每-套架构与系统,都与业务和场景息息相关。这个黑洞膨胀之快,以至于大部分时候都是在出现痛点从而剌激了架构升级。换言之,大数据系统一一如果我们非要用一个系统去描述的话一一其复杂度之高,是几乎不可能在一开始就完整和完美地进行自上而下定义和设计的。从需求→设计→迭代→一寸大数据之路一一阿里巴巴大数据实践升华为理论,在无数次的迭代进化中,我们对大数据的理解才逐渐成形,慢慢能够在将数据黑洞为我所用的抗争中扳回一局。

这个系统生长和进化的过程实际上已经暗暗揭示了阿里巴巴对大数据真髓的理解。大、快、多样性只是表象,大数据的真正价值在于生命性和生态性。阿里巴巴称之为“活数据”。活数据是全本记录、实时驱动决策和迭代,其价值是随着使用场景和方式动态变化的。简单地把数据定义为正/负资产都太简单。数据也不是会枯竭的能源。数据可以被重复使用,并在使用中升值;数据与数据链接可能会像核反应一样产生价值的聚变。数据使用和数据聚变又产生新的数据。活数据的基础设施就需要来承载、管理和促进这个生态体的最大价值实现(以及相应的成本最小化)。丰富的数据形式、多样化的参与角色和动机,以及迥异的计算场景都使得这个系统的复杂度无限升级。阿里巴巴的大数据之路就是在深刻理解这种复杂性的基础上,摸索到了一些重要的秩序和原理,并通过技术架构来验证和劳实。

如果说互联网实现了入入互联和通信,并没有深度地协同计算,那么这样的一个大数据平台和架构就是一张升级的、智能的互联网。这是入类自己设计出来的复杂的信息处理系统,同时也将是真正意义上入类智力大联合的基础设施。这是一个伟大的蓝图,我们敬畏其复杂度和潜能。《大数据之路一一阿里巴巴大数据实践》便是阿里巴巴分享对大数据的认知、与世界共创数据智能的重要基石。数据技术及产品部作为阿里巴巴集团的数据中台,一直致力为阿里巴巴集团内、外提供大数据方面的系统服务,承载了阿里巴巴集团大数据梦想至关重要的数据平台建设。相信他们的实践和思考对同行会有很大的启发和借鉴意义。 曾鸣教授 阿里巴巴集团学术委员会主席 湖畔大学教务长 2017 年5 月

2014 年,马云提出,“入类正从 IT 时代走向 DT 时代。如果说在IT时代是以自我控制、自我管理为主,那么到了 DT(Data Technology)时代,则是以服务大众、激发生产力为主。以互联网(或者物联网)、云计算、大数据和入工智能为代表的新技术革命正在渗透至各行各业,悄悄地改变着我们的生活。

在 DT 时代,入们比以往任何时候更能收集到更丰富的数据。 IDC的报告显示:预计到2020 年,全球数据总量将超过40ZB (相当于40万亿 GB ),这一数据量是2011 年的22 倍!正在呈“爆炸式”增长的数据,其潜在的巨大价值有待发掘。数据作为一种新的能源,正在发生聚变,变革着我们的生产和生活,催生了当下大数据行业发展热火朝天的盛景。

但是如果不能对这些数据进行有序、有结构地分类组织和存储,如果不能有效利用并发掘它,继而产生价值,那么它同时也成为一场“灾难”。无序、无结构的数据犹如堆积如山的垃圾,给企业带来的是令入咋舌的高额成本。

在阿里巴巴集团内,我们面临的现实情况是:集团数据存储达到EB 级别,部分单张表每天的数据记录数高达几千亿条:在2016 年“双11 购物狂欢节”的24 小时中,支付金额达到了1207 亿元入民币,支付峰值高达12 万笔/秒,下单峰值达17.5 万笔/秒,媒体直播大屏处理的总数据量高达百亿且所有数据都需要做到实时、准确地对外披露……

这些给数据采集、存储和计算都带来了极大的挑战。

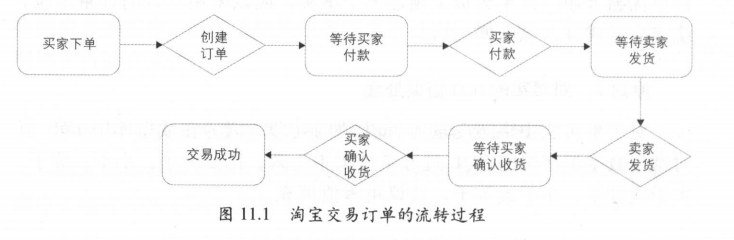

在阿里内部,数据工程师每天要面对百万级规模的离线数据处理工作。阿里大数据井喷式的爆发,加大了数据模型、数据研发、数据质量和运维保障工作的难度。同时,日益丰富的业态,也带来了各种各样、纷繁复杂的数据需求。

如何有效地满足来自员工、商家、合作伙伴等多样化的需求,提高他们对数据使用的满意度,是数据服务和数据产品需要面对的挑战。如何建设高效的数据模型和体系,使数据易用,避免重复建设和数据不一致性,保证数据的规范性;如何提供高效易用的数据开发工具;如何做好数据质量保障;如何有效管理和控制日益增长的存储和计算消耗;如何保证数据服务的稳定,保证其性能;如何设计有效的数据产品高效赋能于外部客户和内部员工……这些都给大数据系统的建设提出了更多复杂的要求。

本书介绍的阿里巴巴大数据系统架构,就是为了满足不断变化的业务需求,同时实现系统的高度扩展性、灵活性以及数据展现的高性能而设计的。

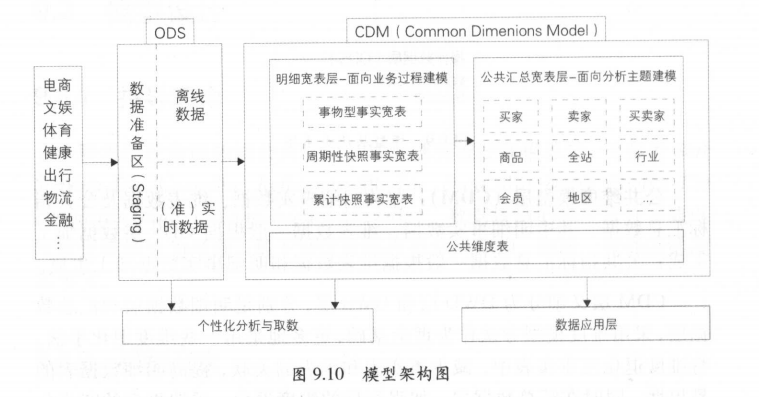

如图1.1 所示是间里巴巴大数据系统体系架构图,从图中可以清晰地看到数据体系主要分为数据采集、数据计算、数据服务和数据应用四大层次。

1 .数据采集层

阿里巴巴是一家多业态的互联网公司,几亿规模的用户(如商家、消费者、商业组织等)在平台上从事商业、消费、娱乐等活动,每时每刻都在产生海量的数据,数据采集作为阿里大数据系统体系的第一环尤为重要。因此阿里巴巴建立了一套标准的数据采集体系方案,致力全面、高性能、规范地完成海量数据的采集,并将其传输到大数据平台。

阿里巴巴的日志采集体系方案包括两大体系: Aplus.JS 是 Web 端日志采集技术方案; UserTrack 是 APP 端日志采集技术方案。在采集技术基础之上,阿里巴巴用面向各个场景的埋点规范,来满足通用浏览、点击、特殊交互、 APP 事件、 H5 及 APP 里的 H5 和 Native 日志数据打通等多种业务场景。同时,还建立了一套高性能、高可靠性的数据传输体系,完成数据从生产业务端到大数据系统的传输。在传输方面,采用TimeTunnel (TT ),它既包括数据库的增量数据传输,也包括日志数据的传输; TT 作为数据传输服务的基础架构,既支持实时流式计算,也支持各种时间窗口的批量计算。另外,也通过数据同步工具( DataX 和同步中心,其中同步中心是基于 DataX 易用性封装的)直连异构数据库(备库)来抽取各种时间窗口的数据。(注:其中的相关细节将在后续的“日志采集”和“数据同步”章节中详细说明。)

2 .数据计算层

数据只有被整合和计算,才能被用于洞察商业规律,挖掘潜在信息,从而实现大数据价值,达到赋能于商业和创造价值的目的。从采集系统中收集到的大量原始数据,将进入数据计算层中被进一步整合与计算。面对海量的数据和复杂的计算,网里巴巴的数据计算层包括两大体系:数据存储及计算云平台(离线计算平台 Max Compute 和实时计算平台 Stream Compute )和数据整合及管理体系(内部称之为“ OneData ”)。其中, Max Compute 是阿里巴巴自主研发的离线大数据平台,其丰富的功能和强大的存储及计算能力使得阿里巴巴的大数据有了强大的存储和计算引擎; StreamCompute 是阿里巴巴自主研发的流式大数据平台,在内部较好地支持了阿里巴巴流式计算需求; OneData 是数据整合及管理的方法体系和工具(注:为方便内部工作及沟通,在阿里内部将这统一的方法体系和工具简称为“ OneData ”),阿里巴巴的大数据工程师在这一体系下,构建统一、规范、可共享的全域数据体系,避免数据的冗余和重复建设,规避数据烟囱和不一致性,充分发挥间里巴巴在大数据海量、多样性方面的独特优势。借助这一统一化数据整合及管理的方法体系,我们构建了阿里巴巴的数据公共层,并可以帮助相似大数据项目快速落地实现。

从数据计算频率角度来看,阿里数据仓库可以分为离线数据仓库和实时数据仓库。离线数据仓库主要是指传统的数据仓库概念,数据计算频率主要以天(包含小时、周和月)为单位;如 T-1 ,则每天凌晨处理上一天的数据。但是随着业务的发展特别是交易过程的缩短,用户对数据产出的实时性要求逐渐提高,所以阿里的实时数据仓库应运而生。“双11 ”实时数据直播大屏,就是实时数据仓库的一种典型应用。

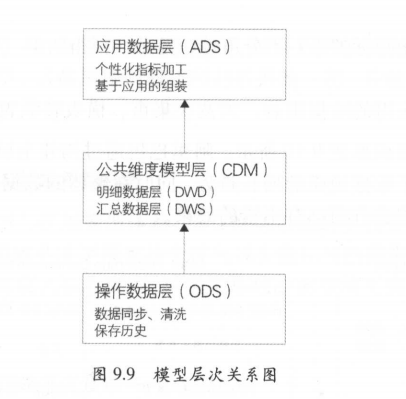

阿里数据仓库的数据加工链路也是遵循业界的分层理念,包括操作数据层( Operational Data Store, ODS )、明细数据层( Data Warehouse Detail , DWD )、汇总数据层( Data Warehouse Summary, DWS )和应用数据层( Application Data Store, ADS )。通过数据仓库不同层次之间的加工过程实现从数据资产向信息资产的转化,并且对整个过程进行有效的元数据管理及数据质量处理。

在阿里大数据系统中,元数据模型整合及应用是一个重要的组成部分,主要包含数据源元数据、数据仓库元数据、数据链路元数据、工具类元数据、数据质量类元数据等。元数据应用主要面向数据发现、数据管理等,如用于存储、计算和成本管理等。

3 .数据服务层

当数据已被整合和计算好之后,需要提供给产品和应用进行数据消费。为了有更好的性能和体验,阿里巴巴构建了自己的数据服务层,通过接口服务化方式对外提供数据服务。针对不同的需求,数据服务层的数据源架构在多种数据库之上,如 MySQL 和 HBase 等。后续将逐渐迁移至阿里云云数据库 ApsaraDB for RDS (简称“ RDS ”)和表格存储( Table Store )等。数据服务可以使应用对底层数据存储透明,将海量数据方便高效地开放给集团内部各应用使用。现在,数据服务每天拥有几十亿的数据调 用量,如何在性能、稳定性、扩展性等方面更好地服务于用户;如何满足应用各种复杂的数据服务需求:如何保证“双11 ”媒体大屏数据服务接口的高可用……随着业务的发展,需求越来越复杂,因此数据服务也在不断地前进。

数据服务层对外提供数据服务主要是通过统一的数据服务平台(为方便阅读,简称为“ OneService ”)。 One Service 以数据仓库整合计算好的数据作为数据源,对外通过接口的方式提供数据服务,主要提供简单数据查询服务、复杂数据查询服务(承接集团用户识别、用户画像等复杂数据查询服务)和实时数据推送服务三大特色数据服务。

4 .数据应用层

数据已经准备好,需要通过合适的应用提供给用户,让数据最大化地发挥价值。阿里对数据的应用表现在各个方面,如搜索、推荐、广告、金融、信用、保险、文娱、物流等。商家,阿里内部的搜索、推荐、广告、金融等平台,阿里内部的运营和管理入员等,都是数据应用方; ISV 、研究机构和社会组织等也可以利用阿里开放的数据能力和技术。

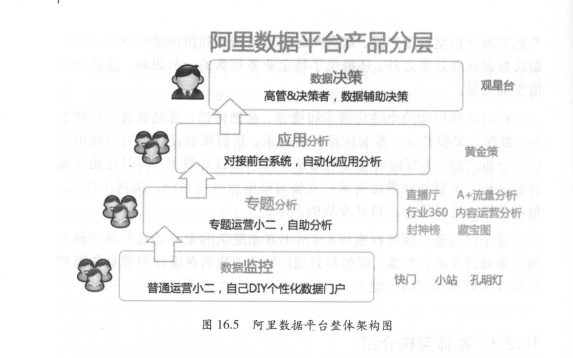

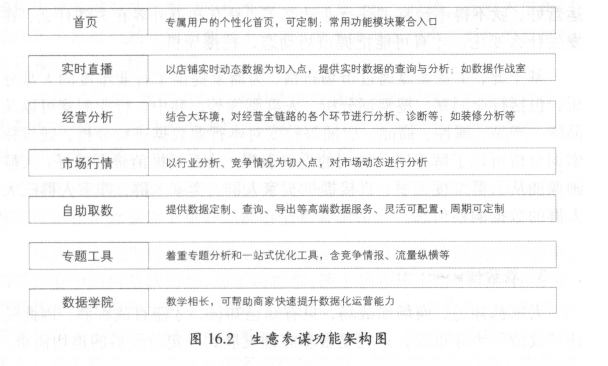

阿里巴巴基于数据的应用产品有很多,本书选择了服务于阿里内部员工的阿里数据平台和服务于商家的对外数据产品一一生意参谋进行基础性介绍。其他数据应用不再赘述。对内,阿里数据平台产品主要有实时数据监控、自助式的数据网站或产品构建的数据小站、宏观决策分析支撑平台、对象分析工具、行业数据分析门户、流量分析平台等。

我们相信,数据作为新能源,为产业注入的变革是显而易见的。我们对数据新能源的探索也不仅仅停留在狭义的技术、服务和应用上。我们正在挖掘大数据更深层次的价值,为社会经济和民生基础建设等提供创新方法。

注:本书中出现的专有名词、专业术语、产品名称、软件项目名称、工具名称等,是沟宝(中国)软件有限公司内部项目的惯用词语,如与第三方名称雷同,实属巧合。

·第2 章日志来集

·第3 章数据同步

·第4 章离线数据开发

·第5 章实时技术

·第6 章数据服务

·第7 章数据挖掘

数据采集作为阿里大数据系统体系的第一环尤为重要。因此阿里巴巴建立了一套标准的数据采集体系方案,致力全面、高性能、规范地完成海量数据的采集,并将其传输到大数据平台。本章主要介绍数据采集中的日志采集部分。

阿里巴巴的日志采集体系方案包括两大体系: Aplus.JS 是 Web 端(基于浏览器)日志采集技术方案; UserTrack 是 APP 端(无线客户端)日志采集技术方案。

本章从浏览器的页面日志采集、无线客户端的日志采集以及我们遇到的日志采集挑战三块内容来阐述阿里巴巴的日志采集经验。

浏览器的页面型产品/服务的日志采集可分为如下两大类。

(1 )页面浏览(展现)日志采集。顾名思义,页面浏览日志是指当一个页面被浏览器加载呈现时采集的日志。此类日志是最基础的互联网日志,也是目前所有互联网产品的两大基本指标:页面浏览量( Page View, PV )和访客数( Unique Visitors, UV )的统计基础。页面浏览日志是目前成熟度和完备度最高,同时也是最具挑战性的日志来集任务,我们将重点讲述此类日志的采集。

(2 )页面交互日志采集。当页面加载和渲染完成之后,用户可以在页面上执行各类操作。随着互联网前端技术的不断发展,用户可在浏览器内与网页进行的互动已经丰富到只有想不到没有做不到的程度,互动设计都要求采集用户的互动行为数据,以便通过量化获知用户的兴趣点或者体验优化点。交互日志采集就是为此类业务场景而生的。除此之外,还有一些专门针对某些特定统计场合的日志采集需求,如专门采集特定媒体在页面被曝光状态的曝光日志、用户在线状态的实时监测等,但在基本原理上都脱胎于上述两大类。限于篇幅,此内容在本书中就不予展开介绍了。

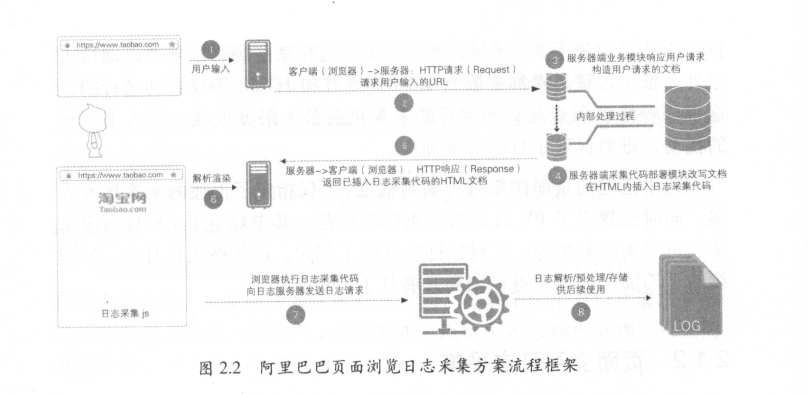

网站页面是互联网服务的基本载体,即使在如今传统互联网形态逐渐让位于移动互联网的背景下, HTML 页面依旧是最普遍的业务形态,对于以网页为基本展现形式的互联网产品和服务,衡量其业务水平的基本指标是网页浏览量( PV )和访客数( UV )。为此,我们需要采集页面被浏览器加载展现的记录,这是最原始的互联网日志采集需求,也是一切互联网数据分析得以展开的基础和前提。目前典型的网页访问过程是以浏览器请求、服务器响应并返回所请求的内容(大多以 HTML 文档的形式)这种模式进行的,浏览器和服务器之间的通信普遍遵守 HTTP 协议(超文本传输协议,目前以 HTTP1.1 为主,逐渐向最新的 HTTP 2.0 过渡)。浏览器发起的请求被称为HTTP 请求( HTTP Request ),服务器的返回则被称为 HTTP 响应( HTTP Response )。

我们以用户访问向宝首页( www.taobao.com )为例,一次典型的页面访问过程描述如图2.1 所示。

(1)用户在浏览器内点击淘宝首页链接(或在地址栏中输入www.taobao.com 并回车)。

(2)浏览器向淘宝服务器发起 HTTP 请求。在本例子中,用户可以看见的内容只是显示于浏览器地址栏内的 http://www.taobao.com ,而浏览器在执行时,会解析用户请求并按照 HTTP 协议中约定的格式将其转化为一个 HTTP 请求发送出去。 按照 HTTP 协议,一个标准的 HTTP 请求由如下三部分构成。

·请求行( HTTP Request Line )。请求行内有三个要素,分别是请求方法、所请求资源的 URL 以及 HTTP 协议版本号。在本例子中,这三个要素分别是 GET 、 http://www.taobao.com以及 HTTP1.1 ,对于我们所讨论的话题,记住请求行内最重要的信息是这个 URL 就可以了。

·请求报头( HTTP Message Header )。请求报头是浏览器在请求时向服务器提交的附加信息,请求报头一般会附加很多内容项(每项内容被称为一个头域( Header Field ),在不引起混淆的情况下,往往将 Header Field 简称为 Header )。需要注意的是,如果用户在本次页面访问之前已经到访过网站或者已经登录,则一般都会在请求头中附加一个或多个被称为 Cookie 的数据项,其中记录了用户上一次访问时的状态或者身份信息,我们只需理解浏览器在发起请求时会带上一个标明用户身份的 Cookie 即可。

·请求正文( HTTP Message Body )。这一部分是可选的,一般而言,HTTP 请求的正文都是空的,可以忽略。

(3)服务器接收并解析请求。服务器端的业务处理模块按业务逻辑处理本次请求并按照 HTTP 协议规定的格式,将处理结果以 HTTP 响应形式发回浏览器。与 HTTP 请求相对应,一个标准的 HTTP 响应也由三部分构成。

·状态行。状态行标识了服务器对于此次 HTTP 请求的处理结果。状态行内的主要内容是一个由三位数字构成的状态码,我们最熟知的两个状态码分别是代表成功响应的200 (OK )和代表所请求的资源在服务器端没有被找到的404 (Not Found )。

·响应报头。服务器在执行响应时,同样可以附加一些数据项,这些数据项将在浏览器端被读取和使用。事实上,在大多数页面和应用中,响应报头内的内容在确保页面正确显示和业务正常进行方面都发挥着至关重要的作用。其中最重要的一类 Header 即上面所提到的 Cookie ,浏览器所记录的 Cookie ,其实是由服务器在响应报头内指令浏览器记录的。举个例子,如果用户在页面登录,则服务器会在登录请求的响应报头内指示浏览器新增一个名为 use rid 的 Cookie 项,其中记录了登录用户的 id 。如此一来,当用户随后再次访问该网站时,浏览器将自动在请求报头内附加这个 Cookie ,服务器由此即可得知本次请求对应的用户到底是谁;如果服务器发现浏览器在请求时传递过来的 Cookie 有缺失、错误或者需要更新,则会在响应报头内指令浏览器增加或更新对应的 Cookie 。

·响应正文。和请求正文一样,这一部分在协议中也被定义为可选部分,但对于大多数 HTTP 响应而言,这一部分都是非空的,浏览器请求的文档、图片、脚本等,其实就是被包装在正文内返回浏览器的。在本例子中,服务器会将淘宝首页对应的 HTML 文档封装在正文内。

(4)浏览器接收到服务器的响应内容,并将其按照文档规范展现给用户,从而完成一次请求。在本例子中,浏览器请求淘宝首页,服务器返回对应的 HTML 文档,浏览器即按照 HTML 文档规范解析文档并将整个页面渲染在屏幕上。

上面描述了一次典型的网页浏览过程,如果需要记录这次浏览行为,则采集日志的动作必然是附加在上述四个步骤中的某一环节内完成的。在第一步和第二步,用户的请求尚未抵达服务器 ;而直到第三步完成,我们也只能认为服务器处理了请求,不能保证浏览器能够正确地解析和渲染页面,尚不能确保用户已确实打开页面,因此在前三步是无法采集用户的浏览日志的。那么采集日志的动作,需要在第四步,也就是浏览器开始解析文档时才能进行。根据前文所述,可以很自然地得出在这一模式下最直接的日志采集思路;在 HTML 文档内的适当位置增加一个日志采集节点,当浏览器解析到这个节点时,将自动触发一个特定的 HTTP 请求到日志采集服务器。如此一来,当日志采集服务器接收到这个请求时,就可以确定浏览器已经成功地接收和打开了页面。这就是目前几乎所有互联网网站页面浏览日志采集的基本原理,而业界的各类网页日志采集的解决方案只是在实施的细节、自动采集内容的广度以及部署的便利性上有所不同。

目前阿里巴巴采用的页面浏览日志采集方案的流程框架如图2.2 所示。在图2.2 所示的页面浏览日志采集过程中,所涉及的日志相关的几个主要过程简单介绍如下:

(1)客户端日志采集。日志采集工作一般由-小段被植入页面HTML 文档内的 JavaScript 脚本来执行。采集脚本被浏览器加载解析后执行,在执行时采集当前页面参数、浏览行为的上下文信息(如读取用户访问当前页面时的上一步页面)以及一些运行环境信息(如当前的浏览器和分辨率等)。在 HTML 文档内植入日志采集脚本的动作可以由业务服务器在响应业务请求时动态执行,也可以在开发页面时由开发入员手动植入。在阿里巴巴,这两种方式均有采用,其中前一种方式的占比较高,这一点与业界的普遍状况有所不同。图2.2 中的第三、四步描述了阿里业务服务器端植入日志采集脚本的过程。

(2 )客户端日志发送。采集脚本执行时,会向日志服务器发起一个日志请求,以将采集到的数据发送到日志服务器。在大多数情况下,采集完成之后会立即执行发送;但在个别场景下,日志采集之后可能会经过一段时间的延迟才被发出。日志采集和发送模块一般会集成在同一个JavaScript 脚本文件内,且通过互联网浏览器必然支持的 HTTP 协议与日志服务器通信,采集到的日志信息一般以 URL 参数形式放在 HTTP日志请求的请求行内。

(3)服务器端日志收集。日志服务器接收到客户端发来的日志请求后,一般会立即向浏览器发回一个请求成功的响应,以免对页面的正常加载造成影响;同时,日志服务器的日志收集模块会将日志请求内容写入一个日志缓冲区内,完成此条浏览日志的收集。

(4)服务器端日志解析存档。服务器接收到的浏览日志进入缓冲区后,会被一段专门的日志处理程序顺序读出并按照约定的日志处理逻辑解析。由日志采集脚本记录在日志请求行内的参数,将在这个环节被解析(有时候伴随着转义和解码)出来,转存入标准的日志文件中并注入实时消息通道内供其他后端程序读取和进一步加工处理。

经过采集一发送一收集一解析存档四个步骤,我们将一次页面浏览日志成功地记录下来。可见,除了采集代码在某些场合下需要手动植入之外,整个过程基本都是依照 HTML 规范和 HTTP 协议自动进行的,这种依赖协议和规范自动运行的采集机制最大限度地减少了入工干预的扰动,进而保证了日志的准确性。

阿里巴巴的页面浏览日志采集框架,不仅指定了上述的采集技术方案,同时也规定了 P V日志的采集标准规范,其中规定了 PV 日志应采集和可采集的数据项,并对数据格式做了规定。这些格式化日志,为后续的日志加工和计算得以顺利开展打下了基础。

PV 日志的采集解决了页面流量和流量来源统计的问题,但随着互联网业务的发展,仅了解用户到访过的页面和访问路径,已经远远不能满足用户细分研究的需求。在很多场合下,需要了解用户在访问某个页面时具体的互动行为特征,比如鼠标或输入焦点的移动变化(代表用户关注内容的变化)、对某些页面交互的反应(可借此判断用户是否对某些页面元素发生认知困难)等。因为这些行为往往并不触发浏览器加载新页面,所以无法通过常规的 P V 日志采集方法来收集。在阿里巴巴,通过一套名为“黄金令箭”的采集方案来解决交互日志的采集问题。

因为终端类型、页面内容、交互方式和用户实际行为的千变万化不可预估,交互日志的采集和 PV 日志的采集不同,无法规定统一的采集内容(例如,活动页面的游戏交互和淘宝购物车页面的功能交互两者相 比,所需记录的行为类型、行为数据以及数据的结构化程度都截然不同),呈现出高度自定义的业务特征。与之相适应,在阿里巴巴的日志采集实践中,交互日志的采集(即“黄金令箭”)是以技术服务的形式呈现的。

具体而言,“黄金令箭”是一个开放的基于 HTTP 协议的日志服务,需要采集交互日志的业务(下文简称“业务方”),经过如下步骤即可将自助采集的交互日志发送到日志服务器。

( 1 )业务方在“黄金令箭”的元数据管理界面依次注册需要采集交互日志的业务、具体的业务场景以及场景下的具体交互采集点,在注册完成之后,系统将生成与之对应的交互日志来集代码模板。

( 2 )业务方将交互日志采集代码植入目标页面,并将采集代码与需要监测的交互行为做绑定。

( 3 )当用户在页面上产生指定行为时,采集代码和正常的业务互动响应代码一起被触发和执行。

( 4 )采集代码在采集动作完成后将对应的日志通过 HTTP 协议发送到日志服务器,日志服务器接收到日志后,对于保存在 HTTP 请求参数部分的自定义数据,即用户上传的数据,原则上不做解析处理,只做简单的转储。

经过上述步骤采集到日志服务器的业务随后可被业务方按需自行解析处理,并可与正常的 PV 日志做关联运算。

上面介绍了阿里巴巴的两类浏览器页面日志的采集方案,并粗略介绍了日志到达日志服务器之后的解析处理。但在大部分场合下,经过上述解析处理之后的日志并不直接提供给下游使用。基于如下几个原因,在对时效要求较宽松的应用场合下,一般还需要进行相应的离线预处理。

(1 )识别流量攻击、网络爬虫和流量作弊(虚假流量)。页面日志是互联网分析和大数据应用的基础源数据,在实际应用中,往往存在占一定比例的虚假或者恶意流量日志,导致日志相关指标的统计发生偏差或明显谬误。为此,需要对所采集的日志进行合法性校验,依托算法识别非正常的流量并归纳出对应的过滤规则集加以滤除。这是一个长期而艰苦的对抗过程。

(2 )数据缺项补正。为了便利后续的日志应用和保证基本的数据统计口径一致,在大多数情况下,需要对日志中的一些公用且重要的数据项做取值归一、标准化处理或反向补正。反向补正,即根据新日志对稍早收集的日志中的个别数据项做回补或修订(例如,在用户登录后,对登录前页面日志做身份信息的回补)。

(3 )无效数据剔除。在某些情况下,因业务变更或配置不当,在采集到的日志中会存在一些无意义、已经失效或者冗余的数据项。这些数据项不仅消耗存储空间和运算能力,而且在偶然的情况下还可能干扰正常计算的进行。为了避免此类异常的发生,需要定时检查配置并依照配置将此类数据项剔除。

(4 )日志隔离分发。基于数据安全或者业务特性的考虑,某些日志在进入公共数据环境之前需要做隔离。

原始日志经过上述的清洗、修正,并结构化变形处理之后, Web页面日志的采集流程就算完成了。此时的日志已经具备了结构化或者半结构化的特征,可以方便地被关系型数据库装载和使用。

众所周知,日志来集多是为了进行后续的数据分析。移动端的数据采集,一是为了服务于开发者,协助开发者分析各类设备信息;二是为了帮助各 APP 更好地了解自己的用户,了解用户在 APP 上的各类行为,帮助各应用不断进行优化,提升用户体验。

无线客户端的日志采集采用采集 SDK 来完成,在阿里巴巴内部,多使用名为 UserTrack 的 SDK 来进行无线客户端的日志采集。无线客户端的日志采集和浏览器的日志采集方式有所不同,移动端的日志采集根据不同的用户行为分成不同的事件,“事件”为无线客户端日志行为的最小单位。基于常规的分析, UserTrack (UT )把事件分成了几类,常用的包括页面事件(同前述的页面浏览)和控件点击事件(同前述的页面交互)等。

对事件进行分类的原因,除了不同事件的日志触发时机、日志内容和实现方式有差异之外,另一方面是为了更好地完成数据分析。在常见的业务分析中,往往较多地涉及某类事件,而非全部事件;故为了降低后续处理的复杂性,对事件进行分类尤为重要。要更好地进行日志数据分析,涉及很多方面的内容,如需要处理 Hybrid 应用,实现 H5 和 Native日志的统一;又如识别设备,保证同一设备上各应用获取到的设备信息是唯一的。除此之外,对于采集到的数据如何上传,以及后续又如何合理处理等,每个过程都值得我们进行深入的研究和探索。

从实现方法上说,日志采集 SDK 对于不同事件的实现,大致是类似的;只是对于通用的用户行为,抽象出来一些通用的接口方法。我们把常用的行为类别单独列出来,作为单独的事件来处理,如本节要讲的页面事件(页面浏览行为)。每条页面事件日志记录三类信息:①设备及用户的基本信息;②被访问页面的信息,这里主要是一些业务参数(如商品详情页的商品 ID 、所属的店铺等); ③访问基本路径(如页面来源、来源的来源等),用于还原用户完整的访问行为。

对于页面事件,不同的 S D K 有不同的实现,有些采集 SD K 选择在页面创建时即发送日志。结合业务分析, U T 提供了页面事件的无痕埋点,即无须开发者进行任何编码即可实现。限于篇幅,本处主要讲一下手动模式的埋点。 UT 提供了两个接口,分别在页面展现和页面退出时调用。以进入手机淘宝的某店铺详情页来举例,当进入该店铺详情页时,调用页面展现的接口,该接口会记录页面进入时的一些状态信息,但此时不发送日志;当从该店铺详情页离开时(可能是在店铺详情页上点击某个商品到了对应的商品详情页,也可能是退出了手机淘宝,抑或是点击返回,返回到了之前的一个页面),调用页面退出的接口,该接口会发送日志。除了基础的两个接口外,还提供了添加页面扩展信息的接口;在页面离开前,使用该接口提供的方法给页面添加相关参数,比如给店铺详情页添加店铺 ID 、店铺类别(天猫店铺或淘宝店铺)等。

显然,上述三个接口方法必须配合使用,即页面展现和页面退出方法必须成对使用,而页面扩展信息的接口必须在使用页面展现和页面退出方法的前提下使用。

再来说说,为什么不在页面进入时就发送日志,而是在页面离开时才发送日志呢?可以思考一下:基于浏览器的日志采集,在每次页面进入时就实现采集日志的发送,每个页面停留时长的计算一直困扰着分析师;而无线客户端的日志采集,在页面离开时发送日志,此时页面停留时长就是天然自带的准确值了。还可以进一步思考,还有什么其他的优势呢?

上述三个方法是采集 SDK 提供的页面事件采集的基础方法;除此之外,为了平衡采集、计算和分析的成本,在部分场景下我们选择采集更多的信息来减少计算及分析的成本。于是, UT 提供了透传参数功能。所谓透传参数,即把当前页面的某些信息,传递到下一个页面甚至下下一个页面的日志中。举个例子,在手机淘宝首页搜索“连衣裙”,进入搜索 list 页面,然后点击某个商品进入商品 A 详情页。如果需要分析“连衣裙”这个关键词,或者商品 A 的来源搜索词,此时就需要把“连衣裙”这个关键词带入到搜索 list 页面日志、商品 A 详情页日志中,这样一来,分析搜索词的效果就显而易见了。在阿里系内,使用 SPM (Super Position Model ,超级位置模型)进行来源去向的追踪,在无线客户端也同样使用 SPM, SPM 信息就可以通过透传机制带入到下一步甚至下下一步的浏览页面,这样整个用户行为路径还原就轻松实现了。

为了和基于浏览器客户端的日志采集做比较,我们暂且把除了页面事件外的各类事件放到一起来讲。和浏览器客户端的日志采集一样,交互日志的采集无法规定统一的采集内容,交互类的行为呈现出高度自定义的业务特征。与之相适应,在网里巴巴的无线客户端日志采集实践中,将交互日志采集从页面事件采集中剥离出来,这就是控件点击事件和其他事件。

先来说说控件点击事件。控件点击事件比页面事件要简单得多,首先,它和页面事件一样,记录了基本的设备信息、用户信息;其次,它记录了控件所在页面名称、控件名称、控件的业务参数等。由于控件点击事件的逻辑简单得多,就是操作页面上的某个控件,因此只需把相关基础信息告诉采集 S D K 即可。

再来说说其他事件。所谓其他事件,就是用户可以根据业务场景需求,使用自定义事件来采集相关信息。从某种程度上说,它几乎能满足用户的所有需求,包括页面事件和控件点击事件,只是若采用通用的页面事件埋点方法, UT 会帮助实现一些额外的功能(如上个页面的信息)。UT 提供了一个自定义埋点类,其包括:①事件名称;②事件时长 ;③事件所携带的属性;④事件对应的页面。当然,具体实现什么功能,需要带哪些内容,各个采集 SDK 可以自行决定。

除了上述这些需要应用开发者触发的日志采集接口方法外, U T 还提供了一些默认的日志采集方法,比如可以自动捕获应用崩溃,并且产生一条日志记录崩溃相关信息。类似的日志采集方法还有很多,比如应用的退出、页面的前后台切换等。诸如一些和业务信息不是非常相关,但又对分析起很大作用的日志采集,就完全没有必要让应用开发者去触发埋点了。

上述场景均为一个行为产生一条日志,如一次浏览、一次点击等。如此用来处理普通的业务是足够的,但对于阿里巴巴巨大的业务体量来说,为了平衡日志大小,减小流量消耗、采集服务器压力、网络传输压力等,采集 SDK 提供了聚合功能,对某些场景如曝光或一些性能技术类日志,我们提倡在客户端对这类日志进行适当聚合,以减少对日志采集服务器端的请求,适当减小日志大小。总体思路就是每个曝光的元素一般都属于一个页面,利用页面的生命周期来实现适当的聚合及确定发送时机。拿曝光日志来举例,若一个商品的一次曝光就对应一条日志的话,那么在搜索结果页的一次滚屏浏览过程中将产生几十条甚至上百条日志,从下游使用及分析的角度来说,其实只是想知道哪些内容被曝光,此时为了平衡业务需求及减少全链路资源消耗,采集 SDK 提供了本地聚合功能,在客户端对这类日志进行聚合,上传聚合后的日志到采集服务器即可。同时对于一些只需要计数,而不需要知道具体内容的场景,如需要分析某些接口的调用次数,此功能就更加凸显出其作用了。

区别于浏览器的页面访问,在无线客户端用户的访问行为路径存在明显的回退行为(如点击回退按钮、各种滑屏等),在进行业务分析时,回退同样作为特殊场景而存在。例如,“双11 ”主会场页→女装分会场→女装店铺 A →回退到女装分会场→女装店铺 B ,在这个访问路径中,若只是按照普通的路径来处理,则会认为第二次浏览的女装分会场来源为店铺 A ,就会把女装分会场的一次浏览效果记为女装店铺 A 带来的。倘若这样处理,就会发现类似的活动承接页其来源有一大部分均为各类详情页(店铺详情页/商品详情页),这必然干扰到分析。所以针对这种场景,我们做了特殊的设计,利用页面的生命周期,识别页面的复用,配合栈的深度来识别是否是回退行为。

如上列举了两个比较典型的特殊场景,随着业务的不断发展,业务的复杂性不断提高,采集需要处理的特殊场景也层出不穷,限于篇幅,此处不再一一展开介绍。

简单来说, APP 分为两种:一种是纯 Native APP; -种是既有 Native ,又有 H5 页面嵌入的 APP ,即 Hybrid APP 。当前,纯 Native APP 已经非常少了,一般都是 Hybrid APP 。 Native 页面采用采集 SDK 进行日志采集, H5 页面一般采用基于浏览器的页面日志采集方式进行采集。在当前的实践中,由于采集方式的不同,采集到的内容及采集服务器均分离开。若需要进行完整的数据分析,就需要将两类日志在数据处理时进行关联,而就算不考虑处理成本,在很多情况下, Native 和 H5 互跳,即使关联也无法还原用户路径,数据丢失严重。对于产品经理以及运营、管理、数据分析入员而言,在不同的终端采用不同的方案采集日志,以不同的算法来做日志统计,忍受多端之间的数据隔离,并对由此导致的多样数据口径进行整理分析和解释,已经是越来越不能容忍的切身之痛。考虑到后续日志数据处理的便捷性、计算成本、数据的合理性及准确性,我们需要对 Native 和 H5 日志进行统一处理(见图2.3 )。

要想实现 Native 和 H5 日志的统一处理,就需要对 Hybrid 日志有统一的方案。简单的思路就是首先将两类日志进行归一。用什么方式把两类日志归一呢?是把 Native 日志向 H5 日志归,还是把 H5日志归到Native 日志呢?其实两条路均可以实现,没有绝对的答案。选择时可以自行斟酌,在阿里巴巴集团,分别考虑两条路的优缺点,考虑到两种日志来集方式的特点以及关注点,我们选择 Native 部署采集 SDK 的方式。

原因有二:一是采用采集 SDK 可以采集到更多的设备相关数据,这在移动端的数据分析中尤为重要;二是采集 SDK 处理日志,会先在本地缓存,而后借机上传,在网络状况不佳时延迟上报,保证数据不丢失。基于这两点,我们选择将 H5 日志归到 Native 日志。

具体的流程如下:

(1) H5 页面浏览和页面交互的数据,在执行时通过加载日志采集的 JavaScript 脚本,采集当前页面参数,包括浏览行为的上下文信息以及一些运行环境信息。在 APP 中打开 HS 页面和在浏览器中的处理完全一样,在前端页面的开发中无须做任何特殊的处理,只需在页面开发时手动植入日志来集的 JavaScript 脚本即可。

(2 )在浏览器日志采集的 JavaScript 脚本中实现将所采集的数据打包到一个对象中,然后调用 WebView 框架的 JSBridge 接口,调用移动客户端对应的接口方法,将埋点数据对象当作参数传入。

(3 )移动客户端日志采集 SDK ,封装提供接口,实现将传入的内容转换成移动客户端日志格式。采集 SDK 会根据日志类别来识别是页面浏览事件,还是控件点击事件,然后调用内部相应的接口进行处理,将埋点数据转换成移动客户端日志的统一格式。而后就同移动客户端的日志处理一样,先记录到本地日志缓存中,择机上传。通过日志类别的识别来做不同的日志格式转换,这样,未来如果要实现新的事件类别,比如自定义事件,就不需要改动 Web View 层的接口,只需改动 JavaScript的部分内容及移动客户端日志采集 SDK 中对应的实现即可。

基于这种统一的方案,为后续构建完整的用户行为路径还原树打下了基础。当然,此方案也有其局限性,必须要浏览器采集 JavaScript 、Web View 、客户端采集 SDK 的配合。而往往很多时候业务并不希望做任何调整,更多的是希望减少依赖,所以在这方面我们也在寻求新的突破。

正如本章开头所说的,所有互联网产品的两大基本指标是页面浏览量( Page View, PV )和访客数( Unique Visitors, UV )。关于 UV ,对于登录用户,可以使用用户 ID 来进行唯一标识,但是很多日志行为并不要求用户登录,这就导致在很多情况下采集上来的日志都没有用户ID 。 PC 端一般使用 Cookie 信息来作为设备的唯一信息,对于 APP 来说,我们就要想办法获取到能够唯一标识设备的信息。

历史上, MEI 、 IMSI 、 MAC 、苹果禁用之前的 UDID ,曾经都可以用,如果它们之中有一个是靠谱的话,那么设备唯一标识就简单了。但事实上,随着用户的自我保护意识加强以及各系统升级,很多基本的设备信息获取都不再那么容易。苹果 UDID 禁用, IDFA 、 IMEI 、 IMSI 做了权限控制, Android 新系统也对设备信息的获取做了权限控制。

对于只有单 APP 的公司来说,设备唯一标识不是需要攻克的难题,但对于像阿里巴巴这样拥有众多 APP 的公司来说,设备唯一标识就显得尤为重要。阿里巴巴集团无线设备唯一标识使用 UTDID ,它当然有很清晰的责任和目标,就是每台设备一个 ID 作为唯一标识。 UTDID 随着 iOS 和 Android 系统对权限控制的不断升级,对方案做了多次调整,包括存储方式、存储位置、共享方式等,以及和服务器端的配合,其生成方式也使用一套较完备的算法。但就目前的进展来说, UTDID 还未完全实现其使命。在这方面,欢迎有思路、有想法的读者和我们联系。

在上面的章节中大概讲述了如何从无线客户端来集日志,本节将简单介绍一下无线客户端日志的上传、压缩及传输的特殊性。

无线客户端日志的上传,不是产生一条日志上传一条,而是无线客户端产生日志后,先存储在客户端本地,然后再伺机上传。所谓伺机,就需要有数据分析的支持,如在启动后、使用过程中、切换到后台时这些场景下分别多久触发一次上传动作。当然单纯地靠间隔时间来决定上传动作是不够的,还需要考虑日志的大小及合理性(如单条日志超大,很可能就是错误日志)。另外,还需要考虑上传时网络的耗时,来决定是否要调整上传机制。

客户端数据上传时是向服务器发送 POST 请求,服务器端处理上传请求,对请求进行相关校验,将数据追加到本地文件中进行存储,存储方式使用 Nginx 的 access_log, access_log 的切分维度为天,即当天接收的日志存储到当天的日志文件中。考虑到后续的数据处理,以及特殊时期不同日志的保障级别,还对日志进行了分流。比如阿里巴巴集团的Adash (无线日志服务器端处理程序),根据应用及事件类型对每日高达数千亿的日志进行了分流。分流的好处显而易见,如“双1 1 ”时,日常数千亿的日志可能冲高到万亿,此时服务器及后续的数据计算压力就非常大了;而对于重要的数据计算来说,很可能只需要页面事件及控件 点击事件即可,此时就可以适当地释放其他类型日志的资源来处理更重要的页面事件及控件点击事件。

从客户端用户行为,到日志采集服务器的日志,整个日志采集的过程就算结束了。那么日志采集服务器的日志怎么给到下游呢?方法有很多,阿里巴巴集团主要使用消息队列( TimeTunel, TT )来实现从日志采集服务器到数据计算的 Max Compute 。

简单来讲,就是 TT 将消息收集功能部署到日志采集服务器上进行消息的收集,而后续的应用可以是实时的应用实时来订阅 TT 收集到的消息,进行实时计算,也可以是离线的应用定时来获取消息,完成离线的计算。有关消息队列,以及日志数据的统计计算等细节内容,将在后续章节中进行详细讲述。

对于目前的互联网行业而言,互联网日志早已跨越初级的饥饿阶段(大型互联网企业的日均日志收集量均以亿为单位计量),反而面临海量日志的淹没风险。各类采集方案提供者所面临的主要挑战已不是日志采集技术本身,而是如何实现日志数据的结构化和规范化组织,实现更为高效的下游统计计算,提供符合业务特性的数据展现,以及为算法提供更便捷、灵活的支持等方面。

这里介绍两个最典型的场景和阿里巴巴所采用的解决方案。

1 . 日志分流与定制处理

大型互联网网站的日志类型和日志规模都呈现出高速增长的态势,而且往往会出现短时间的流量热点爆发。这一特点,使得在日志服务器端采用集中统一的解析处理方案变得不可能,其要求在日志解析和处理过程中必须考虑业务分流(相互之间不应存在明显的影响,爆发热点不应干扰定常业务日志的处理)、日志优先级控制,以及根据业务特点实现定制处理。例如,对于电商网站而言,数据分析入员对位于点击流前端的促销页面和位于后端的商品页面的关注点是不一样的,而这两类页面的流量又往往同等重要且庞大,如果采用统一的解析处理方案,则往往需要在资源浪费(尽可能多地进行预处理)和需求覆盖不全(仅对最 重要的内容进行预处理)两个选择之间进行取舍。这种取舍的结果一般不是最优的。

考虑到阿里日志体量的规模和复杂度,分治策略从一开始便是阿里互联网日志采集体系的基本原则。这里以 PV 日志采集领域一个最浅显的例子来说明,与业界通用的第三方日志采集方案的日志请求路径几乎归一不同,阿里 PV 日志的请求位置( URL )是随着页面所在业务类型的不同而变化的。通过尽可能靠前地布置路由差异,就可以尽可能早地进行分流,降低日志处理过程中的分支判断消耗,并作为后续的计算资源调配的前提,提高资源利用效率。与业界方案的普遍情况相比,阿里的客户端日志采集代码的一个突出特点是实现了非常高的更新频次(业界大多以季度乃至年为单位更新代码,阿里则是以周/月为单位),并实现了更新的配置化。我们不仅考虑诸如日志分流处理之类的日志服务器端分布计算方案,而且将分类任务前置到客户端(从某种程度上讲,这才是真正的“分布式”!)以实现整个系统的效能最大化。最后可以在计算后端几乎无感知的情况下,承载更大的业务量并保证处理质量和效率。

2 .采集与计算一体化设计

以 PYV日志为例,页面 PV 日志采集之后一个基础性操作是日志的归类与汇总。在早期的互联网日志分析实践中,是以 URL 路径,继而以 URL (正则)规则集为依托来进行日志分类的。在网站规模较小时,这一策略还可以基本顺利地运转下去,但随着网站的大型化和开发入员的增加, URL 规则集的维护和使用成本会很快增长到不现实的程度,同时失控的大规模正则适配甚至会将日志计算硬件集群彻底榨干。

这一状况要求日志采集方案必须将来集与计算作为一个系统来考量,进行一体化设计。阿里日志采集针对这一问题给出的答案是两套日志规范和与之对应的元数据中心。其中,对应于 PV 日志的解决方案是目前用户可直观感知的 SPM 规范(例如,在页面的 URL 内可以看见 SPM参数)和 SPM 元数据中心。通过 SPM 的注册和简单部署(仅需要在页面文件内声明一个或多个标签),用户即可将任意的页面流量进行聚类,不需要进行任何多余的配置就可以在相应的内部数据产品内查询聚合统计得到的流量、转化漏斗、引导交易等数据,以及页面各元素点击数据的可视化视图。对应于自定义日志的解决方案则是黄金令箭( Goldlog)/APP 端的点击或其他日志规范及其配置中心。通过注册一个与所在页面完全独立的令箭实体/控件实体,用户可以一键获得对应的埋点代码,并自动获得实时统计数据和与之对应的可视化视图。通过简单的扩展配置,用户还可以自动获得自定义统计维度下的分量数据。

在当前的互联网环境下,互联网日志的规模化采集方案必须具备一个与终端设备的技术特点无关,具有高度扩展弹性和适应性,同时深入契合应用需求的业务逻辑模型,并基于此制定对应的采集规范交由产品开发入员执行。若非如此,则不足以保障采集一解析一处理一应用整个流程的通畅。目前阿里已成功实现规范制定一元数据注册一日志采集一自动化计算一可视化展现全流程的贯通。通过一体化设计,用户甚至可以在不理解规范的前提下,通过操作向导式界面,实现日志来集规范的自动落地和统计应用。日志本身不是日志采集的目的,服务于基于日志的后续应用,才是日志采集正确的着眼点。

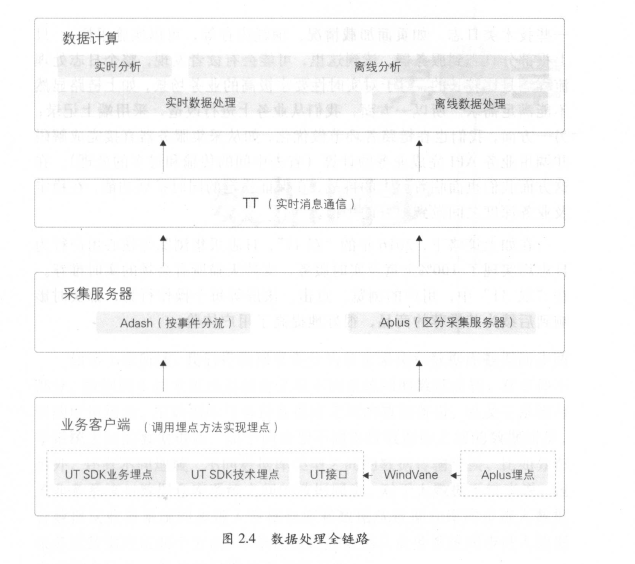

日志数据在阿里系乃至整个电商系应该都是体量最大的一类数据,在“双 11 ”期间,日志必然会暴涨,近万亿的数据量对日志全链路来说,无疑是不小的挑战(见图2.4 )。

从端上埋点采集,到日志服务器收集,经过数据传输,再到日志实时解析、实时分析,任何一个环节出现问题,全链路保障就是失败的。考虑到服务器的收集能力(如峰值 QPS 等)、数据传输能力( TT 的搬运速度)、实时解析的吞吐量、实时业务分析的处理能力,我们在各环节都做了不少的工作。

首先,端上实现了服务器端推送配置到客户端,且做到高到达率;其次,对日志做了分流,结合日志的重要程度及各类日志的大小,实现了日志服务器端的拆分;最后,在实时处理方面,也做了不少的优化以提高应用的吞吐量。在上面几项的基础上,结合实时处理能力,评估峰值数据量,在高峰期通过服务器端推送配置的方式对非重要日志进行适当限流,错峰后逐步恢复。此处说的服务器端推送配置包含较多的内容,首先是作用范围,可以针对应用、平台、事件、事件中的某个场景;其次是具体实施,包括延迟上报、部分采样等。所谓延迟上报,即配置生效后,满足条件的日志将被暂时存在客户端,待配置恢复后再上传到服务器;所谓采样,即配置生效后,满足条件的日志将被实施采样(对于一些技术类日志,如页面加载情况、消耗内存等,可以实施采样),只上报部分日志到服务器。读到这里,可能会有读者发现,整个日志处理流程还是比较长的,对于对实时性要求极高的业务场景,如上链路显然不能满足需求。所以一方面,我们从业务上进行改造,采用端上记录;另一方面,我们也在链路各环节做优化,如从采集服务器直接完成解码并调用业务 API 完成业务的计算(省去中间的传输和过多的处理)。在这方面我们也面临着巨大的挑战,在保证稳定的同时扩展功能,在稳定及业务深度之间做到很好的平衡。

在如上策略下,2016 年的“双11 ”,日志采集浏览等核心用户行为日志均实现了100%全量及实时服务,支持天猫所有会场的实时推荐。在“双11 ”中,用户的浏览、点击、滚屏等每个操作行为,都实时影响到后续为其推荐的商品,很好地提高了用户体验。

如第 1 章所述,我们将数据采集分为日志采集和数据库数据同步两部分。数据同步技术更通用的含义是不同系统间的数据流转,有多种不同的应用场景。主数据库与备份数据库之间的数据备份,以及主系统与子系统之间的数据更新,属于同类型不同集群数据库之间的数据同步。另外,还有不同地域、不同数据库类型之间的数据传输交换,比如分布式业务系统与数据仓库系统之间的数据同步。对于大数据系统来说,包含数据从业务系统同步进入数据仓库和数据从数据仓库同步进入数据服务或数据应用两个方面。本章侧重讲解数据从业务系统同步进入数据仓库这个环节,但其适用性并不仅限于此。

源业务系统的数据类型多种多样,有来源于关系型数据库的结构化数据,如 MySQL 、 Oracle 、 DB2、 SQL Server 等;也有来源于非关系型数据库的非结构化数据,如 Ocean Base 、 HBase 、 MongoDB 等,这类数据通常存储在数据库表中;还有来源于文件系统的结构化或非结构化数据,如阿里云对象存储 oss 、文件存储 NAS 等,这类数据通常以文件形式进行存储。数据同步需要针对不同的数据类型及业务场景选择不同的同步方式。总的来说,同步方式可以分为三种:直连同步、数据文件同步和数据库日志解析同步。

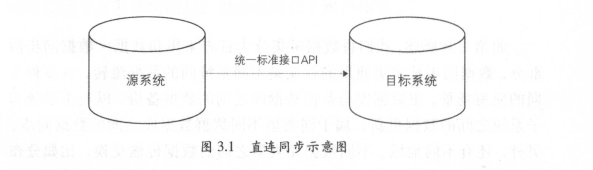

直连同步是指通过定义好的规范接口 API 和基于动态链接库的方式直接连接业务库,如 ODBC/JDBC 等规定了统一规范的标准接口,不同的数据库基于这套标准接口提供规范的驱动,支持完全相同的函数调用和 SQL 实现(见图3 .1 )。

这种方式配置简单,实现容易,比较适合操作型业务系统的数据同步。但是业务库直连的方式对源系统的性能影响较大,当执行大批量数据同步时会降低甚至拖垮业务系统的性能。如果业务库采取主备策略,则可以从备库抽取数据,避免对业务系统产生性能影响。但是当数据量较大时,采取此种抽取方式性能较差,不太适合从业务系统到数据仓库系统的同步。

数据文件同步通过约定好的文件编码、大小、格式等,直接从源系统生成数据的文本文件,由专门的文件服务器,如 FTP 服务器传输到目标系统后,加载到目标数据库系统中。当数据源包含多个异构的数据库系统(如 MySQL 、 Oracle 、 S QL Server 、 DB2 等)时,用这种方式比较简单、实用。另外,互联网的日志类数据,通常是以文本文件形式存在的,也适合使用数据文件同步方式(见图3.2 )。

由于通过文件服务器上传、下载可能会造成丢包或错误,为了确保数据文件同步的完整性,通常除了上传数据文件本身以外,还会上传一个校验文件,该校验文件记录了数据文件的数据量以及文件大小等校验信息,以供下游目标系统验证数据同步的准确性。另外,在从源系统生成数据文件的过程中,可以增加压缩和加密功能,传输到目标系统以后,再对数据进行解压缩和解密,这样可以大大提高文件的传输效率和安全性。

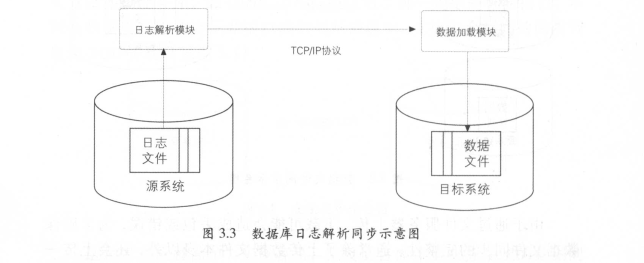

目前,大多数主流数据库都已经实现了使用日志文件进行系统恢复,因为日志文件信息足够丰富,而且数据格式也很稳定,完全可以通过解析日志文件获取发生变更的数据,从而满足增量数据同步的需求。

以 Oracle 为例,可以通过源系统的进程,读取归档日志文件用以收集变化的数据信息,并判断日志中的变更是否属于被收集对象,将其解析到目标数据文件中。这种读操作是在操作系统层面完成的,不需要通过数据库,因此不会给源系统带来性能影响。然后可通过网络协议,实现源系统和目标系统之间的数据文件传输。相关进程可以确保数据文件的正确接收和网络数据包的正确顺序,并提供网络传输冗余,以确保数据文件的完整性。

数据文件被传输到目标系统后,可通过数据加载模块完成数据的导入,从而实现数据从源系统到目标系统的同步(见图3.3 )。

数据库日志解析同步方式实现了实时与准实时同步的能力,延迟可以控制在毫秒级别,并且对业务系统的性能影响也比较小,目前广泛应用于从业务系统到数据仓库系统的增量数据同步应用之中。

由于数据库日志抽取一般是获取所有的数据记录的变更(增、删、改),落地到目标表时我们需要根据主键去重按照日志时间倒排序获取最后状态的变化情况。对于删除数据这种变更情况,针对不同的业务场景可以采用一些不同的落地手法。

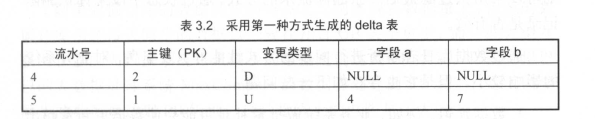

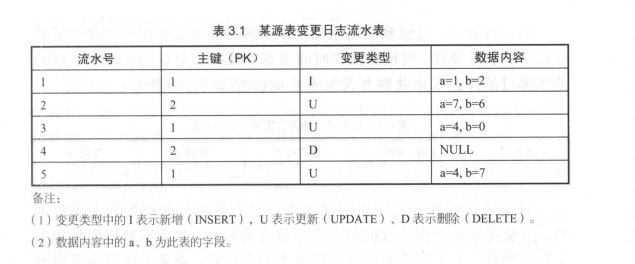

我们以具体的实例进行说明。如表3.1 所示为源业务系统中某表变更日志流水表。其含义是:存在5 条变更日志,其中主键为1 的记录有3 条变更日志,主键为2 的记录有2 条变更日志。

针对删除数据这种变更,主要有三种方式,下面以实例进行说明。假设根据主键去重,按照流水倒序获取记录最后状态生成的表为 delta表。

第一种方式,不过滤删除流水。不管是否是删除操作,都获取同一主键最后变更的那条流水。采用此种方式生成的 delta 表如表3 .2 所示。

第二种方式,过滤最后一条删除流水。如果同一主键最后变更的那条流水是删除操作,就获取倒数第二条流水。采用此种方式生成的 delta 表如表3 .3 所示。

第三种方式,过滤删除流水和之前的流水。如果在同一主键变更的过程中有删除操作,则根据操作时间将该删除操作对应的流水和之前的流水都过滤掉。采用此种方式生成的 delta 表如表3.4 所示。

对于采用哪种方式处理删除数据,要看前端是如何删除无效数据的。前端业务系统删除数据的方式一般有两种:正常业务数据删除和手工批量删除。手工批量删除通常针对类似的场景,业务系统只做逻辑删除,不做物理删除, DBA 定期将部分历史数据直接删除或者备份到备份库。

一般情况下,可以采用不过滤的方式来处理,下游通过是否删除记录的标识来判断记录是否有效。如果明确业务数据不存在业务上的删除,但是存在批量手工删除或备份数据删除,例如淘宝商品、会员等,则可以采用只过滤最后一条删除流水的方式,通过状态字段来标识删除记录是否有效。

通过数据库日志解析进行同步的方式性能好、效率高,对业务系统的影响较小。但是它也存在如下一些问题:

·数据延迟。例如,业务系统做批量补录可能会使数据更新量超出系统处理峰值,导致数据延迟。

·投入较大。采用数据库日志抽取的方式投入较大,需要在源数据库与目标数据库之间部署一个系统实时抽取数据。

·数据漂移和遗漏。数据漂移,一般是对增量表而言的,通常是指该表的同一个业务日期数据中包含前一天或后一天凌晨附近的数据或者丢失当天的变更数据。这个问题我们将在“数据漂移的处理”一节中详细论述。

数据仓库的特性之一是集成,将不同的数据来源、不同形式的数据整合在一起,所以从不同业务系统将各类数据源同步到数据仓库是一切的开始。那么阿里数据仓库的数据同步有什么特别之处呢?

阿里数据仓库的数据同步的特点之一是数据来源的多样性。在传统的数据仓库系统中,一般数据来源于各种类型的关系型数据库系统,比如 MySQL 、 SQL Server 、 Oracle 、 DB2 等,这类数据的共同特点便是高度结构化,易于被计算机系统处理。而在大数据时代,除了结构化数据,还有大量非结构化数据,比如 Web 服务器产生的日志、各类图片、视频等。特别是日志数据,记录了用户对网站的访问情况,这类数据通常直接以文本文件形式记录在文件系统中,对于数据的分析、统计、挖掘等各类数据应用有极大的价值。以淘宝网为例,我们可以从用户浏览、点击页面的日志数据分析出用户的偏好和习惯,进而推荐适合的产品以提高成交率。

阿里数据仓库的数据同步的特点之二则体现在数据量上。传统的数据仓库系统每天同步的数据量一般在几百 GB 甚至更少,而一些大型互联网企业的大数据系统每天同步的数据量则达到 PB 级别。目前阿里巴巴的大数据处理系统 Max Compute 的数据存储达到 EB 级别,每天需要同步的数据量达到 PB 级别,这种量级上的差距是巨大的。

数据源的类型是多样的,需要同步的数据是海量的,那该如何准确、高效地完成数据同步呢?这里就需要针对不同的数据源类型和数据应用的时效性要求而采取不同的策略。

对于离线类型的数据仓库应用,需要将不同的数据源批量同步到数据仓库,以及将经过数据仓库处理的结果数据定时同步到业务系统。

当前市场上的数据库系统种类很多,有行存储的和列存储的,有开源的和非开源的,每一种数据库的数据类型都略有不同,而数据仓库系统则是集成各类数据源的地方,所以数据类型是统一的。要实现各类数据库系统与数据仓库系统之间的批量双向数据同步,就需要先将数据转换为中间状态,统一数据格式。由于这类数据都是结构化的,且均支持标准的 SQL 语言查询,所以所有的数据类型都可以转换为字符串类型。因此,我们可以通过将各类源数据库系统的数据类型统一转换为字符串类型的方式,实现数据格式的统一。

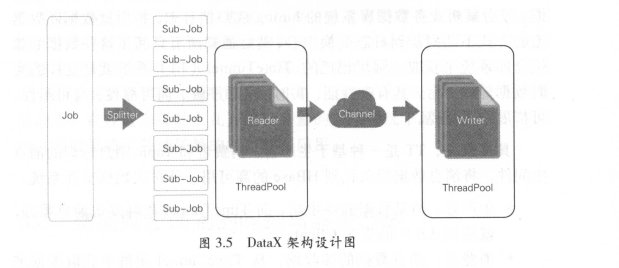

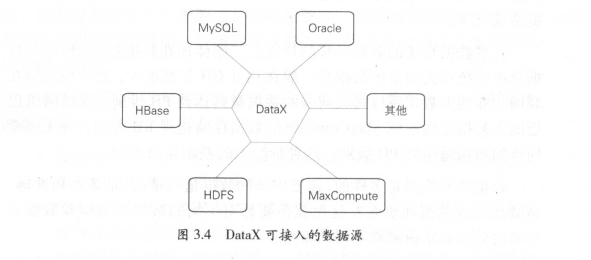

阿里巴巴的 DataX 就是这样一个能满足多方向高自由度的异构数据交换服务产品。对于不同的数据源, DataX 通过插件的形式提供支持,将数据从数据源读出并转换为中间状态,同时维护好数据的传输、缓存等工作。数据在 DataX 中以中间状态存在,并在目标数据系统中将中间状态的数据转换为对应的数据格式后写入。目前 DataX 每天都需要处理2PB 左右的批量数据同步任务,通过分布式模式,同步完所有的数据所需要的时间一般在3 小时以内,有力保障了大数据同步的准确性及高效性(见图3.4)。

DataX 采用 Framework+Plugin 的开放式框架实现, Framework 处理缓冲、流程控制、并发、上下文加载等高速数据交换的大部分技术问题,并提供简单的接口与插件接入(见图3.5 )。插件仅需实现对数据处理系统的访问,编写方便,开发者可以在极短的时间内开发一个插件以快速支持新的数据库或文件系统。数据传输在单进程(单机模式)/多进程(分布式模式)下完成,传输过程全内存操作,不读写磁盘,也没有进程间通信,实现了在异构数据库或文件系统之间的高速数据交换。

• Job :数据同步作业。

• Splitter :作业切分模块,将一个大任务分解成多个可以并发行的小任务。

• Sub-Job :数据同步作业切分后的小任务,或称之为 Task 。

• Reader :数据读入模块,负责运行切分后的小任务,将数据从源系统装载到 DataX 。

• Channel: Reader 和 Writer 通过 Channel 交换数据。

• Writer :数据写出模块,负责将数据从 DataX 导入目标数据系统。

对于日志类数据来说,由于每天的日志是源源不断产生的,并且分布在不同的服务器中,有些大型互联网公司的服务器集群有成千上万台机器,所以所产生的日志需要尽快以数据流的方式不间断地同步到数据仓库。另外,还有一些数据应用,需要对业务系统产生的数据进行实时处理,比如天猫“双11 ”的数据大屏,对所产生的交易数据需要实时汇总,实现秒级的数据刷新。这类数据是通过解析 MySQL 的 binlog 日志(相当于 Oracle 的归档日志)来实时获得增量的数据更新,并通过消息订阅模式来实现数据的实时同步的。具体来说,就是建立一个日志数据交换中心,通过专门的模块从每台服务器源源不断地读取日志数据,或者解析业务数据库系统的 binlog 或归档日志,将增量数据以数据流的方式不断同步到日志交换中心,然后通知所有订阅了这些数据的数据仓库系统来获取。阿里巴巴的 TimeTunnel (TT )系统就是这样的实时数据传输平台,具有高性能、实时性、顺序性、高可靠性、高可用性、可扩展性等特点。

具体来说, TT 是一种基于生产者、消费者和 Topic 消息标识的消息中间件,将消息数据持久化到 HBase 的高可用、分布式数据交互系统。

·生产者:消息数据的产生端,向 TimeTunnel 集群发送消息数据,就是图3.6 中的生产 Client 。

·消费者:消息数据的接收端,从 TimeTunnel 集群中获取数据进行业务处理。

• Topic :消息类型的标识,如淘宝 acookie 日志的 Topic 为taobao_acookie ,生产 Client 和消费 Client 均需要知道对应的Topic 名字。

• Broker 模块:负责处理客户端收发消息数据的请求,然后往HBase 取发数据。

Time Tunnel 支持主动、被动等多种数据订阅机制,订阅端自动负载均衡,消费者自己把握消费策略。对于读写比例很高的 Topic ,能够做到读写分离,使消费不影响发送。同时支持订阅历史数据,可以随意设置订阅位置,方便用户回补数据。另外,针对订阅有强大的属性过滤功能,用户只需关心自己需要的数据即可。 Time Tunnel 高效、稳定地支持阿里巴巴实时数据的同步,每天处理的日志类数据多达几百 TB ,数据库 binlog 解析的实时增量数据同步也有几百 TB ,在天猫“双 11”大促活动中,在峰值为每秒十几万笔交易量的极端情况下延迟控制在3s 以内,有效保障了各种场景的实时数据应用。

在实际的大数据同步应用中会遇到各种各样的挑战,处理方法也是不断变化的,下面就针对常见的问题一起讨论一下解决方案。

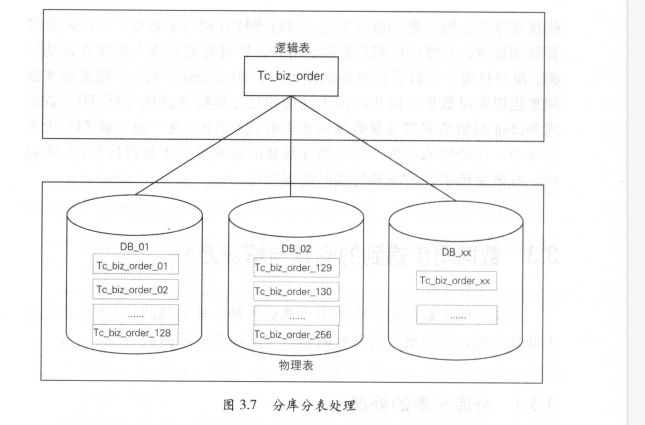

随着业务的不断增长,业务系统处理的数据量也在飞速增加,需要系统具备灵活的扩展能力和高并发大数据量的处理能力,目前一些主流数据库系统都提供了分布式分库分表方案来解决这个问题(见图3.7 )。但是对于数据同步来说,这种分库分表的设计无疑加大了同步处理的复杂度。试想一下,如果有一个中间表,具备将分布在不同数据库中的不同表集成为一个表的能力,就能让下游应用像访问单库单表一样方便。

阿里巴巴的 TDDL ( Taobao Distributed Data Layer )就是这样一个分布式数据库的访问引擎,通过建立中间状态的逻辑表来整合统一分库分表的访问(见图3.8 )。TDDL 是在持久层框架之下、 JDBC驱动之上的中间件,它与 JDBC规范保持一致,有效解决了分库分表的规则引擎问题,实现了 SQL 解析、规则计算、表名替换、选择执行单元并合并结果集的功能,同时解决了数据库表的读写分离、高性能主备切换的问题,实现了数据库配置信息的统一管理。

数据同步的方法通常是先创建目标表 ,再通过同步工具的填写数据库连接、表 、 字段等各种配置信息后测试完成数据同步。这也是 DataX任务的配置过程,同步中心对 DataX 进行进 一 步封装,通过源系统元数据降低了数据库连接、表和字段等信息的配置复杂度,但在实际生产过程 中我们仍然会遇到一些问题。

·随着业务的发展和变化,会新增大批量的数据同步,使用传统方式每天去完成成百上千的数据同步工作,一方面,工作量会特别大 ; 另 一 方面,相似并且重复的操作会降低开发入员的工作热情。

·数据仓库的数据源种类特别丰富,遇到不同类型的数据源同步就要求开发入员去了解其特殊配置。

·部分真正的数据需求方,如 Java 开发和业务运营,由于存在相关数据同步的专业技能门槛,往往需要将需求提交给数据开发方来完成,额外增加了沟通和流程成本。

为了解决上述问题,阿里巴巴数据仓库研发了 OneClick 产品:

· 对不同数据源的数据同步配置透明化,可以通过库名和表名唯 一定位,通过 IDB 接口获取元数据信息自动生成配置信息。

·简化了数据同步的操作步骤,实现了与数据同步相关的建表、配置任务、发布、测试操作一键化处理,并且封装成 Web 接口进一 步达到批量化的效果。

· 降低了数据同步的技能门槛,让数据需求方更加方便地获取和使用数据。

通过 OneClick 产品,真正实现了数据的一键化和批量化同步,一键完成 DDL 和 DML 的 生成、数据的冒烟测试以及在生产环境中测试等。因此,阿里巴巴通过极少的入力投入,实现了数据同步的集中化建设和管理;改变了之前各数据开发入员自行同步带来的效率低、重复同步和同步配置质量低下等问题,大大降低了数据同步成本。

注: IDB 是阿里巴巴集团用于统一管理 MySQL 、 OceanBase 、 PostgreSQL 、Oracle 、 SQLServer 等关系型数据库的平台,它是一种集数据管理、结构管理、诊断优化、实时监控和系统管理于一体的数据管理服务;在对集团数据库表的统一管理服务过程中, IDB 产出了数据库、表、字段各个级别元数据信息,并且提供了元数据接口服务。

在批量数据同步中,有些表的数据量随着业务的发展越来越大,如果按周期全量同步的方式会影响处理效率。在这种情况下,可以选择每次只同步新变更的增量数据,然后与上一个同步周期获得的全量数据进行合井,从而获得最新版本的全量数据。 在传统的数据整合方案中,合并技术大多采用merge 方式( update+insert );当前流行的大数据平台基本都不支持 update 操作 ,现在我们比较推荐的方式是全外连接( full outer join) +数据全量覆盖重新加载( insert overwrite ),即如日调度,则将当天的增量数据和前一天的全量数据做全外连接,重新加载最新的全量数据。在大数据量规模下,全量更新的性能比 update 要高得多。此外,如果担心数据更新错误问题,可以采用分区方式,每天保持一个最新的全量版本,保留较短的时间周期(如 3~7 天) 。

另外,当业务系统的表有物理删除数据的操作,而数据仓库需要保留所有历史数据时,也可以选择这种方式,在数据仓库中永久保留最新的全量数据 快照 。 下面我们以淘宝订单表的具体实例来说明。

淘宝交易订单表,每天新增、变更的增量数据多达几亿条,历史累计至今的全量数据则有几百亿条,面对如此庞大的数据量,如果每天从业务系统全量同步显然是不可能的 。 可行的方式是同步当天的增量数据,并与数据仓库中的前 一天全量数据合并,获得截至当天的最新全量数据(见图 3.9 )。

数据同步任务是针对不同数据库系统之间的数据同步问题而创建的一系列周期调度的任务。在大型的数据调度工作台上,每天会运行大量的数据同步任务。针对数据同步任务 , 一般首先需要设定首轮同步的线程数,然后运行同步任务。

这样的数据同步模式存在以下几个问题:

·有些数据同步任务的总线程数达不到用户设置的首轮同步的线程数时,如果同步控制器将这些同步线程分发到 CPU 比较繁忙的机器上,将导致这些同步任务的平均同步速度非常低,数据同步速度非常慢。

·用户不清楚该如何设置首轮同步的线程数,基本都会设置成一个固定的值,导致同步任务因得不到合理的 CPU 资源而影响同步效率。

·不同的数据同步任务的重要程度是不一样 的,但是同步控制器平等对待接收到的同步线程,导致重要的同步线程因得不到 CPU资源而无法同步。

上述数据同步模式存在的几个问题导致的最终结果是数据同步任务运行不稳定。

针对数据同步任务中存在的问题,阿里巴巴数据团队实践出了一套基于负载均衡思想的新型数据同步方案。该方案的核心思想是通过目标数据库的元数据估算同步任务的总线程数,以及通过系统预先定义的期望同步速度估算首轮同步的线程数,同时通过数据同步任务的业务优先级决定同步线程的优先级,最终提升同步任务的执行效率和稳定性。

具体实现步骤如下 :

·用户创建数据同步任务,并提交该同步任务。

·根据系统提前获知及设定的数据,估算该同步任务需要同步的数据量、平均同步速度、首轮运行期望的线程数、需要同步的总线程数。

·根据需要同步的总线程数将待同步的数据拆分成相 等数量的数据块,一个线程处理 一 个数据块,并将该任务对应的所有线程提交至同步控制器。

· 同步控制器判断需要同步的总线程数是否大于首轮运行期望的线程数,若大于,则跳转至;若不大于,则跳转至。

· 同步控制器采用多机多线程的数据同步模式,准备该任务第 一轮线程的调度,优先发送等待时间最长、优先级最高且同 一 任务的线程。

· 同步控制器准备 一定数据量(期望首轮线程数 -总线程数)的虚拟线程,采用单机多线程的数据同步模式 ,准备该任务相应实体线程和虚拟线程的调度,优先发送等待时间最长、优先级最高且单机 CPU 剩余资源可以支持首轮所有线程数且同 一 任务的线程,如果没有满足条件的机器,则选择 CPU 剩余资源最多的机器进行首轮发送。

· 数据任务开始同步,并等待完成。

· 数据任务同步结束。

通常我们把从源系统同步进入数据仓库的第一层数据称为 ODS 或者 staging 层数据,阿里巴巴统称为 ODS 。数据漂移是 ODS 数据的 一个顽疾,通常是指 ODS 表的同一个业务日期数据中包含前一天或后一天凌晨附近的数据或者丢失当天的变更数据。

由于 ODS 需要承接面向历史的细节数据查询需求,这就需要物理落地到数据仓库的 ODS 表按时间段来切分进行分区存储 ,通常的做法是按某些时间戳字段来切分,而实际上往往由于时间戳字段的准确性问题导致发生数据漂移。

通常,时间戳字段分为四类:

· 数据库表中用来标识数据记录更新时间的时间戳字段(假设这类字段叫 modified _time )。

· 数据库日志中用来标识数据记录更新时间的时间戳字段(假设这类宇段叫 log_time ) 。

· 数据库表中用来记录具体业务过程发生时间的时间戳字段 (假设这类字段叫 proc_time ) 。

· 标识数据记录被抽取到时间的时间戳字段(假设这类字段叫extract time ) 。

理论上,这几个时间应该是 一 致的,但是在实际生产中,这几个时间往往会出现差异,可能的原因有以下几点 :

· 由于数据抽取是需要时间的, extract_ time 往往会晚于前三个时间。

·前台业务系统手工订正数据时未更新 modified_time 。

· 由于网络或者系统压力问题, log_time 或者 modified_time 会晚于 proc_time 。

通常的做法是根据其中的某一个字段来切分 ODS 表,这就导致产生数据漂移。下面我们来具体看下数据漂移的几种场景。

· 根据 extract_ time 来获取数据。这种情况数据漂移的问题最明显 。

· 根据 modified_time 限制。在实际生产中这种情况最常见,但是往往会发生不更新 modified time 而导致的数据遗漏,或者凌晨时间产生的数据记录漂移到后一天。

· 根据 log_time 限制。由于网络或者系统压力问题, log_time 会晚于 proc_time ,从而导致凌晨时间产生的数据记录漂移到后一天。例如,在淘宝“双 11 ”大促期间凌晨时间产生的数据量非常大,用户支付需要调用多个接口,从而导致 log_time 晚于实际的支付时间。

· 根据 proc_time 限制。仅仅根据 proc_time 限制,我们所获取的ODS 表只是包含 一个业务过程所产生的记录 ,会遗漏很 多其他过程的变化记录,这违背了 ODS 和业务系统保持 一 致的设计原则 。

处理方法主要有以下两种:

(1)多获取后一天的数据

既然很难解决数据漂移的问题,那么就在 ODS 每个时间分区中向前、向后多冗余一些数据,保障数据只会多不会少,而具体的数据切分让下游根据自身不同的业务场景用不同的业务时间 proc_time 来限制。但是这种方式会有一些数据误差,例如 一 个订单是当天支付的,但是第二天凌晨申请退款关闭了该订单,那么这条记录的订单状态会被更新,下游在统计支付订单状态时会出现错误。

(2)通过多个时间戳字段限制时间来获取相对准确的数据

· 首先根据 log_time 分别冗余前一天最后 15 分钟的数据和后一天凌晨开始 15 分钟的数据,并用 modified_time 过滤非当天数据,确保数据不会因为系统问题而遗漏。

· 然后根据 log_time 获取后一天 15 分钟的数据;针对此数据,按照主键根据 log_time 做升序排列去重。因为我们需要获取的是最接近当天记录变化的数据(数据库日志将保留所有变化的数据,但是落地到 ODS 表的是根据主键去重获取最后状态变化的数据)。

· 最后将前两步的结果数据做全外连接,通过限制业务时间proc_time 来获取我们所需要的数据。

下面来看处理淘宝交易订单的数据漂移的实际案例。我们在处理“双 11 ”交易订单时发现,有 一 大批在 11 月11日23:59:59 左右支付的交易订单漂移到了 12 日 。主要原因是用户下单支付后系统需要调用支付宝的接口而有所延迟,从而导致这些订单最终生成的时间跨天了。即 modified _time 和 log_time 都晚于 proc_time 。

如果订单只有一个支付业务过程,则可以用支付时间来限制就能获取到正确的数据。但是往往实际订单有多个业务过程 : 下单、支付、成功,每个业务过程都有相应的时间戳字段,并不只有支付数据会漂移。如果直接通过多获取后 一 天的数据,然后限制这些时间,则可以获取到相关数据,但是后 一 天的数据可能已经更新多次,我们直接获取到的那条记录已经是更新多次后的状态,数据的准确性存在 一 定的问题。

因此,我们可以根据实际情况获取后 一 天 15 分钟的数据,并限制多个业务过程的时间戳字段(下单、支付、成功)都是“双 11 ”当天的,然后对这些数据按照订单的 mo dified_time 做升序排列,获取每个订单首次数据变更的那条记录。

此外,我们可以根据 log_time 分别冗余前 一 天最后 15 分钟的数据和后 一 天凌晨开始 15 分钟的数据,并用 modified _time 过滤非当天数据,针对每个订单按照 log_time 进行降序排列 ,取每个订单当天最后一次数据变更的那条记录。最后将两份数据根据订单做全外连接,将漂移数据回补到当天数据中。

从采集系统中收集了大量的原始数据后,数据只有被整合和计算,才能被用于洞察商业规律,挖掘潜在信息,从而实现大数据价值,达到赋能于商业和创造价值的目的。面对海量的数据和复杂的计算,阿里巴巴的数据计算层包括两大体系:数据存储及计算平台 (离线计算平台MaxCompute 和 实时计算平台 StreamCompute ) 、数据整合及管理体系( OneData ) 。

本章主要介绍 Max Compute 和阿里巴巴内部基于 Max Compute 的大数据开发套件,并对在数据开发过程中经常遇到的问题和相关解决方案进行介绍。

阿里数据研发岗位的工作大致可以概括为:了解需求→模型设计→ETL 开发→测试→发布上线→日常运维→任务下线。与传统的数据仓库开发( ETL )相比,阿里数据研发有如下几个特点:

·业务变更频繁一一业务发展非常快 ,业务需求多且变更频繁。

·需要快速交付一一业务驱动 ,需要快速给出结果。

·频繁发布上线一一 迭代周期以天为单位,每天需要发布数次。

·运维任务多 一一在集团公共层平均每个开发入员负责 500 多个任务。

·系统环境复杂一一 阿里平台系统多为自研,且为了保证业务的发展,平台系统的迭代速度较快,平台的稳定性压力较大。通过统一的计算平台( MaxCompute )、统一 的开发平台( D2 等相关平台和工具)、统一 的数据模型规范和统一的数据研发规范,可以在一 定程度上解决数据研发的痛点。

阿里离线数据仓库的存储和计算都是在阿里云大数据计算服务MaxCompute 上完成的。大数据计算服务 Max Compute 是由阿里云自主研发的海量数据处理平台,主要服务于海量数据的存储和计算 ,提供完善的数据导入方案,以及多种经典的分布式计算模型,提供海量数据仓库的解决方案,能够更快速地解决用户的海量数据计算问题,有效降低企业成本,并保障数据安全。

Max Compute 采用抽象的作业处理框架 ,将不同场景的各种计算任务统一在同一个平台之上,共享安全、存储 、数据管理和资源调度,为来自不同用户需求的各种数据处理任务提供统一 的编程接口和界面。它提供数据上传/下载通道、 SQL 、 Map Reduce 、机器学习算法 、 图编程模型 和流式计算模型多种计算分析服务,并且提供完善的安全解决方案。

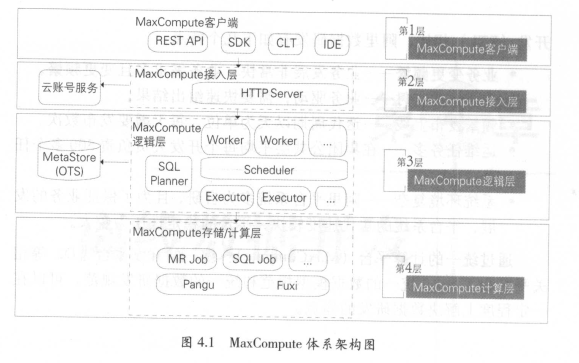

1 . MaxCompute 的体系架构

Max Compute 的体系架构如图 4.1 所示。

MaxCompute 由四部分组成,分别是客户端( MaxCompute Client )、接入层( Max Compute Front End )、逻辑层( MaxCompute Server )及存储与计算层( Apsara Core )。

Max Compute 客户端有以下几种形式。

• Web :以 RESTful API 的方式提供离线数据处理服务。

• SDK :对 RESTful API 的封装,目前有 Java 等版本的实现。

• CLT (Command Line Tool ):运行在 Windows /Linux 下的客户端工具,通过 CLT 可以提交命令完成 Project 管理、 DDL 、 DML等操作。

• IDE :上层可视化 ETL/BI 工具,即阿里内部名称是在云端(D2 ),用户可以基于在云端完成数据同步、任务调度、报表生成等常见操作。

接入层提供 HTTP 服务、 Cache 、负载均衡,实现用户认证和服务层面的访问控制。

逻辑层又称作控制层,是 Max Compute的核心部分,实现用户空间和对象的管理、命令的解析与执行逻辑、数据对象的访问控制与授权等功能。在逻辑层有 Worker 、 Scheduler 和 Executor 三个角色:

• Worker 处理所有的RESTful 请求,包括用户空间( Project )管理操作、资源( Resource )管理操作、作业管理等,对于 SQLDML 、MR 等需要启动 MapReduce 的作业,会生成 MaxCompute Instance(类似于 Hive 中的 Job ),提交给Scheduler 进一步处理。

• Scheduler 负责 MaxCompute Instance 的调度和拆解,并向计算层的计算集群询问资源占用情况以进行流控。

• Executor 负责 MaxCompute Instance 的执行,向计算层的计算集群提交真正的计算任务。

计算层就是飞天内核( Apsara Core ),运行在和控制层相互独立的计算集群上,它包括 Pangu (分布式文件系统)、 Fuxi (资源调度系统)、Nuwa/ZK U、Jamespace 服务)、 Shennong (监控模块)等。 Max Compute中的元数据存储在阿里云计算的另一个开放服务 OTS (Open TableService ,开放结构化数据服务)中,元数据内容主要包括用户空间元数据、 Table/Partition Schema 、 ACL 、 Job 元数据、安全体系等。

2 . MaxCompute 的特点

(1)计算性能高且更加普惠

2016 年 11 月 10 日, Sort Benchmark 在官方网站公布了2 016 年排序竞赛 Cloud Sort 项目的最终成绩。阿里云以$1.44/TB 的成绩获得 Indy(专用目的排序)和 Daytona (通用目的排序)两个子项的世界冠军,打破了 AWS 在2014 年保持的纪录$4.51 /TB 。这意味着阿里云将世界顶级的计算能力,变成普惠科技的云产品。 CloudSort 又被称为“云计算效率之争”,这项目赛比拼的是完成 100TB 数据排序谁的花费更少,也是Sort Benchmark 的各项比赛当中最具现实意义的项目之一。

(2)集群规模大且稳定性高

Max Compute 平台共有几万台机器、存储近 1000PB ,支撑着阿里巴巴的很多业务系统,包括数据仓库、 BI 分析和决策支持、信用评估和无担保贷款风险控制、广告业务、每天几十亿流量的搜索和推荐相关性分析等,系统运行非常稳定。同时, Max Compute 能保证数据的正确性,如对数据的准确性要求非常高的蚂蚁金服小额贷款业务,就运行于Max Compute 平台之上。

(3 )功能组件非常强大

• MaxCompute SQL :标准 SQL 的语法,提供各类操作和函数来处理数据。

• MaxCompute MapReduce :提供 Java MapReduce 编程模型,通过接口编写 MR 程序处理 MaxCompute 中的数据。还提供基于MapReduce 的扩展模型 MR2 ,在该模型下,一个 Map 函数后可以接入连续多个 Reduce 函数,执行效率比普通的 Map Reduce 模型高。

• MaxCompute Graph :面向迭代的图计算处理框架,典型应用有PageRank 、单源最短距离算法、 K-均值聚类算法。

• Spark :使用 Spark 接口编程处理存储在 Max Compute 中的数据。

• RMaxCompute :使用 R 处理 Max Compute 中的数据。

• Volume: MaxCompute 以 Volume 的形式支持文件,管理非二维表数据。

(4 )安全性高

Max Compute 提供功能强大的安全服务,为用户的数据安全提供保护。 Max Compute 采用多租户数据安全体系,实现用户认证、项目空间的用户与授权管理、跨项目空间的资源分享,以及项目空间的数据保护。如支付宝数据,符合银行监管的安全性要求,支持各种授权鉴权审查和“最小访问权限”原则,确保数据安全。

阿里数据开发平台集成了多个子系统来解决实际生产中的各种痛点。围绕 MaxCompute 计算平台,从任务开发、调试、测试、发布、监控、报警到运维管理,形成了整套工具和产品,既提高了开发效率,又保证了数据质量,并且在确保数据产出时效的同时,能对数据进行有效管理。

数据研发入员完成需求了解和模型设计之后,进入开发环节,开发时工作流如图4.2 所示。

对应于开发工作流的产品和工具如图4.3 所示,我们将对其功能进行简要介绍。

1 .在云端(D2)

D2 是集成任务开发、调试及发布,生产任务调度及大数据运维,数据权限申请及管理等功能的一站式数据开发平台,并能承担数据分析工作台的功能。

用户使用 D2 进行数据开发的基本流程如下:

·用户使用 IDE 进行计算节点的创建,可以是 SQL/MR 任务,也可以是 Shell 任务或者数据同步任务等,用户需要编写节点代 码、设置节点属性和通过输入输出关联节点间依赖。设置好这些后,可以通过试运行来测试计算逻辑是否正确、结果是否符合预期。

·用户点击提交,节点进入开发环境中,并成为某个工作流的其中一个节点。整个工作流可以被触发调度,这种触发可以是入为的(称之为“临时工作流”),也可以是系统自动的(称之为“日常工作流”)。当某个节点满足所有触发条件后,会被下发到调 度系统的执行引擎 A lisa 中,完成资源分配和执行的整个过程。

·如果节点在开发环境中运行无误,用户可以点击发布,将该节点正式提交到生产环境中,成为线上生产链路的一个环节。

2 .SQLSCAN

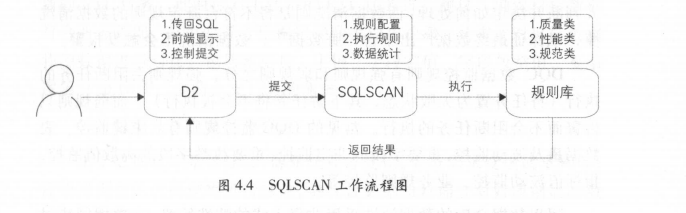

SQLSCAN 将在任务开发中遇到的各种问题,如用户编写的 SQL质量差、性能低、不遵守规范等,总结后形成规则,并通过系统及研发流程保障,事前解决故障隐患,避免事后处理。

SQLSCAN 与 D2 进行结合,嵌入到开发流程中,用户在提交代码时会触发 SQLS CAN 检查。 SQLSCAN 工作流程如图4.4 所示。

·用户在 D2 的 IDE 中编写代码。

·用户提交代码, D2 将代码、调度等信息传到 SQLSCAN 。

• SQLSCAN 根据所配置的规则执行相应的规则校验。

• SQLSCAN 将检查成功或者失败的信息传回 D20

• D2 的 IDE 显示 OK (成功)、 WARNNING (警告)、 FAILED(失败,禁止用户提交)等消息。

SQLSCAN 主要有如下三类规则校验:

·代码规范类规则,如表命名规范、生命周期设置、表注释等。

·代码质量类规则,如调度参数使用检查、分母为0 提醒、 NULL值参与计算影响结果提醒、插入字段顺序错误等。

·代码性能类规则,如分区裁剪失效、扫描大表提醒、重复计算检测等。

SQLSCAN 规则有强规则和弱规则两类。触发强规则后,任务的提交会被阻断,必须修复代码后才能再次提交;而触发弱规则,则只会显示违反规则的提示,用户可以继续提交任务。

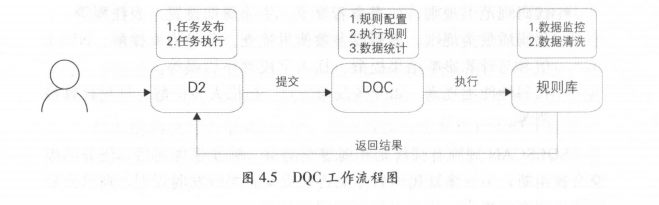

3 .DQC

DQC (Data Quality Center ,数据质量中心)主要关注数据质量,通过配置数据质量校验规则,自动在数据处理任务过程中进行数据质量方面的监控。

DQC 主要有数据监控和数据清洗两大功能。数据监控,顾名思义,能监控数据质量并报警,其本身不对数据产出进行处理,需要报警接收人判断并决定如何处理;而数据清洗则是将不符合既定规则的数据清洗掉,以保证最终数据产出不含“脏数据”,数据清洗不会触发报警。

DQC 数据监控规则有强规则和弱规则之分,强规则会阻断任务的执行(将任务置为失败状态,其下游任务将不会被执行);而弱规则只告警而不会阻断任务的执行。常见的 DQC 监控规则有:主键监控、表数据量及波动监控、重要字段的非空监控、重要枚举字段的离散值监控、指标值波动监控、业务规则监控等。

阿里数据仓库的数据清洗采用非侵入式的清洗策略,在数据同步过程中不进行数据清洗,避免影响数据同步的效率,其过程在数据进入ODS 层之后执行。对于需要清洗的表,首先在 DQC 配置清洗规则;对于离线任务,每隔固定的时间间隔,数据入仓之后,启动清洗任务,调用 DQC 配置的清洗规则,将符合清洗规则的数据清洗掉,并保存至DIRTY 表归档。如果清洗掉的数据量大于预设的阈值,则阻断任务的执行 ;否则不会阻断。

4 .在彼岸

数据测试的典型测试方法是功能测试,主要验证目标数据是否符合预期。其主要有如下场景:

(1 )新增业务需求

新增产品经理、运营、 BI 等的报表、应用或产品需求,需要开发新的 ETL 任务,此时应对上线前的 ETL 任务进行测试,确保目标数据符合业务预期,避免业务方根据错误数据做出决策。其主要对目标数据和源数据进行对比,包括数据量、主键、字段空值、字段枚举值、复杂逻辑(如 UDF 、多路分支)等的测试。

(2)数据迁移、重构和修改

由于数据仓库系统迁移、源系统业务变化、业务需求变更或重构等,需要对现有的代码逻辑进行修改,为保证数据质量需要对修改前后的数据进行对比,包括数据量差异、宇段值差异对比等,保证逻辑变更正确。

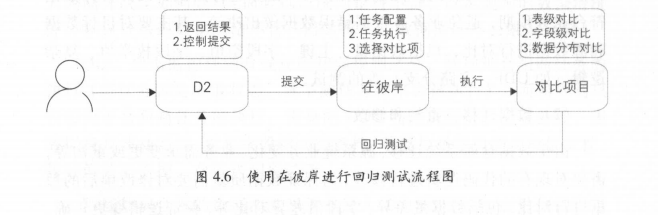

为了严格保证数据质量,对于优先级(优先级的定义见“数据质量”章节)大于某个阈值的任务,强制要求必须使用在彼岸进行回归测试,在彼岸回归测试通过之后,才允许进入发布流程。

在彼岸则是用于解决上述测试问题而开发的大数据系统的自动化测试平台,将通用的、重复性的操作沉淀在测试平台中,避免被“入肉”,提高测试效率。

在彼岸主要包含如下组件,除满足数据测试的数据对比组件之外,还有数据分布和数据脱敏组件。

·数据对比:支持不同集群、异构数据库的表做数据对比。表级对比规则主要包括数据量和全文对比;字段级对比规则主要包括字段的统计值(如 SUM 、 A VG 、 MAX 、 MIN 等)、枚举值、空值、去重数、长度值等。

·数据分布:提取表和字段的一些特征值,并将这些特征值与预期值进行比对。表级数据特征提取主要包括数据量、主键等;字段级数据特征提取主要包括字段枚举值分布、空值分布、统计值(如SUM 、 AVG 、 MAX 、 MIN 等)、去重数、长度值等。

.数据脱敏:将敏感数据模糊化。在数据安全的大前提下,实现线上数据脱敏,在保证数据安全的同时又保持数据形态的分布,以便业务联调、数据调研和数据交换。

现代信息化条件下的战争,从太空的卫星到空中的各类作战飞机,从地面的导弹到坦克火炮,从水面的大小舰艇到水下的潜艇,还有诸如网络、电磁环境等多种方式、多种维度的作战空间,各种武器装备、人员、作战环境纷繁复杂,如何能够准确、合理地调配这些资源,组织有序、高效的攻防体系赢得胜利,最关键的是需要有一个强大的指挥系统。

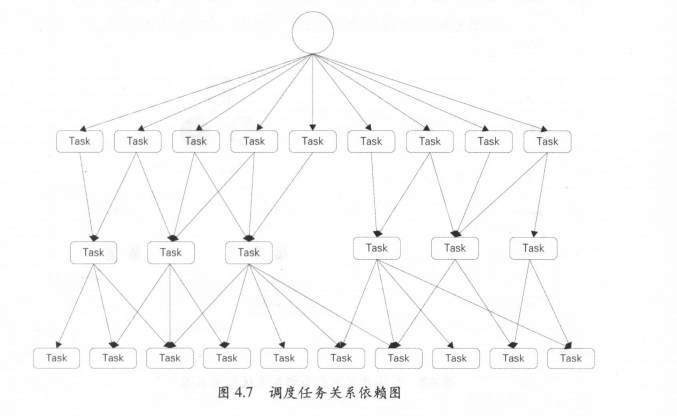

在云计算大数据时代,调度系统无疑是整个大数据体系的指挥中枢。如图4.7 所示,调度系统中的各类任务互相依赖,形成一个典型的有向无环图。在传统的数据仓库系统中,很多是依靠 Crontab 定时任务功能进行任务调度处理的。这种方式有很多弊端:①各任务之间的依赖基于执行时间实现,容易造成前面的任务未结束或失败而后面的任务已经运行;②任务难以并发执行,增加了整体的处理时间:③无法设置任务优先级;④任务的管理维护很不方便,无法进行执行效果分析等。

而在大数据环境下,每天需要处理海量的任务,多的可以达到几十上百万。另外,任务的类型也很繁杂,有 MapReduce 、 Hive 、 SQL 、Spark 、 Java 、 Shell 、 Python 、 Perl 、虚拟节点等,任务之间互相依赖且需要不同的运行环境。为了解决以上问题,阿里巴巴的大数据调度系统应运而生。

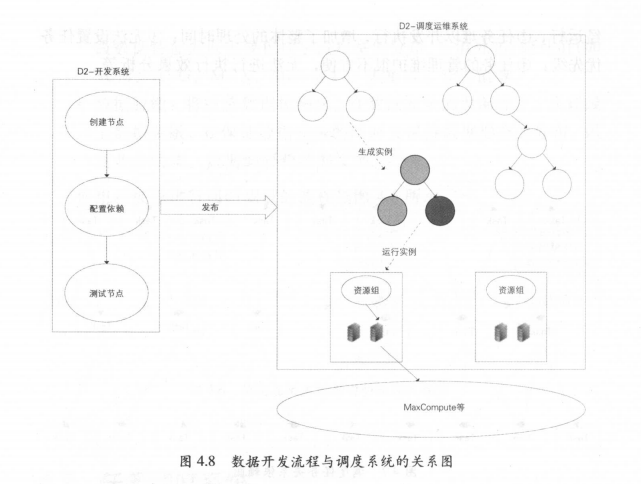

1 .数据开发流程与调度系统的关系

用户通过 D2 平台提交、发布的任务节点,需要通过调度系统,按照任务的运行顺序调度运行。

2 .调度系统的核心设计模型

整个调度系统共有两个核心模块:调度引擎( Phoenix Engine )和执行引擎( Alisa )。简单来说,调度引擎的作用是根据任务节点属性以及依赖关系进行实例化,生成各类参数的实值,并生成调度树 ;执行引擎的作用是根据调度引擎生成的具体任务实例和配置信息,分配 CPU 、内存、运行节点等资源,在任务对应的执行环境中运行节点代码。

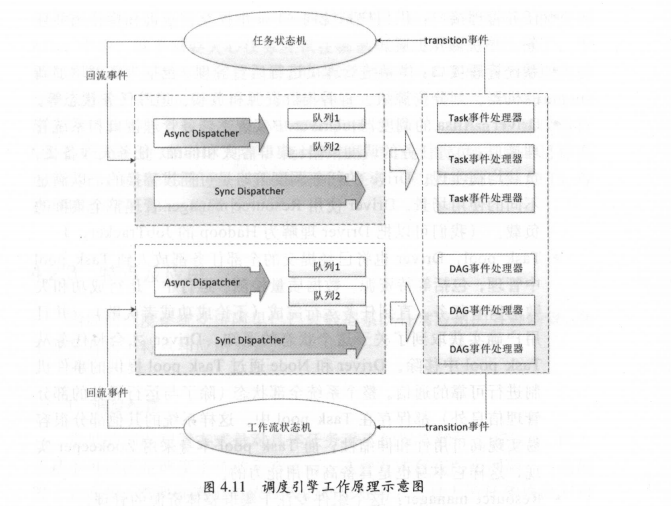

在介绍调度引擎设计之前,我们先来了解两个模型:任务状态机模型和工作流状态机模型。

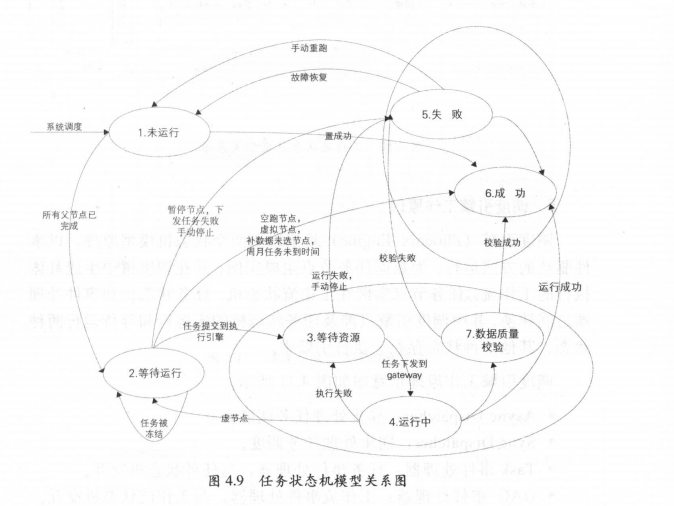

3 .任务状态机模型

任务状态机模型是针对数据任务节点在整个运行生命周期的状态定义,总共有6 种状态,状态之间的转换逻辑如图4.9 所示。

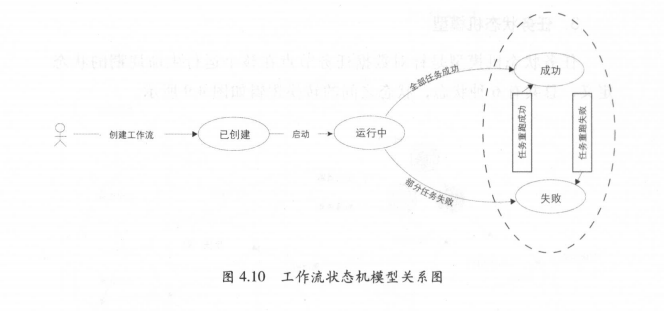

4 .工作流状态机模型

工作流状态机模型是针对数据任务节点在调度树中生成的工作流运行的不同状态定义,共有5 种状态,其关系如图4.10 所示。

5 .调度引擎工作原理

调度引擎( Phoenix Engine )基于以上两个状态机模型原理,以事件驱动的方式运行,为数据任务节点生成实例,并在调度树中生成具体执行的工作流。任务节点实例在工作流状态机、任务状态机和事件处理器之间转换,其中调度引擎只涉及任务状态机的未运行和等待运行两种状态,其他5 种状态存在于执行引擎中。

调度引擎工作原理示意图如图4.1 l 所示。

• Async Dispatcher :异步处理任务调度。

• Sync Dispatcher :同步处理任务调度。

• Task 事件处理器:任务事件处理器,与任务状态机交互。

• DAG 事件处理器:工作流事件处理器,与工作流状态机交互。

一个 DAG 事件处理器包含若干个 Task 事件处理器。

6 .执行引擎工作原理

首先来看看执行引擎( Alisa )的逻辑架构,如图4.12 所示。

·任务管理接口:供用户系统向 Alisa 中提交、查询和操作离线任务,并获得异步通知。

·系统管理接口:供系统管理员进行后台管理,包括为集群增加新的机器、划分资源组、查看集群资源和负载、追踪任务状态等。

• Driver: Alisa 的调度器, Driver 中实现了任务管理接口和系统管理接口;负责任务的调度策略、集群容灾和伸缩、任务失效备援、负载均衡实现。 Drive 的任务调度策略是可插拔替换的,以满足不同的使用场景。 Driver 使用 Resource manager 管理整个集群的负载。(我们可以把 Driver 理解为 Hadoop 的 Job Tracker 。)

• Task pool: Driver 也将已经提交的全部任务都放入到 Task pool中管理,包括等待资源、数据质量检测、运行中、运行成功和失败的所有任务。直到任务运行完成(不论成功或者失败),并且用户确实获取到了关于这个状态的通知, Driver 才会将任务从 Task pool 中移除。 Driver 和 Node 通过 Task pool 提供的事件机制进行可靠的通信。整个系统全部状态(除了与运行无关的部分管理信息外)都保存在 Task pool 中,这样系统的其他部分很容易实现高可用性和伸缩性。而 Task pool 本身采用 Zoo keeper 实现,这样它本身也是具备高可用能力的。

• Resource manager :这个组件专注于集群整体资源的管理。

• Task container :类似于 Web Server ,为 Task 提供运行的容器(类似的, Web Server 为 Action 提供运行的容器)。容器负责处理Task 的公共逻辑,如文件下载,任务级 Session 、流程级 Session的维护等。同时 Task container 负责收集机器的实际负载并上报给 Resource manager 。

• Session manager :这个组件实现了对 Task session 的管理。

• Node: Node 代表 Alisa 集群中的一个节点。节点负责提供任务运行所需的物理资源。 Node 是逻辑概念,一台物理机器上可以部署一个或者多个 Node (Node 类似于 Hadoop 的 TaskTracker )。

7 .执行引擎的用法

Alisa 的用户系统包括上文的工作流服务、数据同步服务,以及调度引擎生成的各类数据处理任务的调度服务。这样系统将任务提交到Alisa 中后,就不需要关心任务应该在哪里执行以及如何被执行了,于是大大降低了系统本身的复杂度。同时其任务可以共享同一个物理集群资源,提高了资源的利用效率。如果 Alisa 中的任务是一个 Max Compute任务,计算实际会被提交到 Max Compute 集群中, Alisa 中仅仅运行Max Compute 的 Client ;同样,流计算任务等会被提交到对应的目标系统中运行;而 S hell 任务、离线数据同步任务、实时同步任务( TT )等将直接运行在 A lisa 集群上。

当前的调度系统支持阿里巴巴大数据系统日常应用的各种场景,其主要具有如下特点和应用场景。

1 .调度配置

常见的调度配置方式是对具体任务手工配置依赖的上游任务,此方式基本可以满足调度系统的正常运行。这种方式存在两个问题:一是配置上较麻烦,需要知道上游依赖表的产出任务 z 二是上游任务修改不再产出依赖表或本身任务不再依赖某上游任务时,对调度依赖不做修改,导致依赖配置错误。

阿里巴巴的调度配置方式采用的是输入输出配置和自动识别相结合的方式。任务提交时, SQL 解析引擎自动识别此任务的输入表和输出表,输入表自动关联产出此表的任务,输出表亦然。通过此种方式,解决了上述问题,可以自动调整任务依赖,避免依赖配置错误。

2 .定时调度

可以根据实际需要,设定任务的运行时间,共有5 种时间类型:分钟、小时、日、周、月,具体可精确到秒。比如日任务可选择每天的几点几分运行,周任务可选择每周几的几点几分运行,月任务也可选择每月第几天的几点几分运行。对于周任务和月任务,通常选择定时调度的方式。

3 .周期调度

可按照小时、日等时间周期运行任务,与定时调度的区别是无须指定具体的开始运行时间。比如离线数据处理的大多数日任务就是这种类型,任务根据依赖关系,按照调度树的顺序从上依次向下运行,每个周期的具体运行时间随着每天资源和上游依赖任务运行的总体情况会有所不同。

4 .手动运行

当生产环境需要做一些数据修复或其他一次性的临时数据操作时,可以选择手动运行的任务类型,在开发环境( IDE )中写好脚本后发布到生产环境,再通过手动触发运行。

5 .补数据

在完成数据开发的发布以后,有些表需要进行数据初始化,比如有些日增量表要补齐最近三年的历史数据,这时就需要用到补数据任务了。可以设定需要补的时间区间,并圈定需要运行的任务节点,从而生成一个补数据的工作流,同时还能选择并行的运行方式以节约时间。

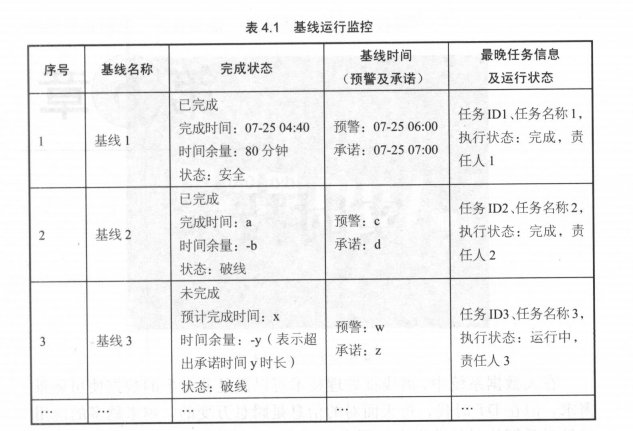

6 .基线管理

基于充分利用计算资源,保证重点业务数据优先产出,合理安排各类优先级任务的运行,调度系统引入了按优先级分类管理的方法。优先级分类从 1 ~9 ,数字越大代表优先级越高,系统会先保障高优先级任务的运行资源。对于同一类优先级的任务,放到同一条基线中,这样可以实现按优先级不同进行分层的统一管理,并可对基线的运行时间进行预测估计,以监控是否能在规定的时间内完成。基线运行监控如表4 .1 所

7 .监控报警

调度系统有一套完整的监控报警体系,包括针对出错的节点、运行超时未完成的节点,以及可能超时的基线等,设置电话、短信、邮件等不同的告警方式,实现了日常数据运维的自动化。具体产品介绍请参考“数据质量”章节。

阿里巴巴的大数据调度系统经过几年的迭代研发和实际运行,目前已经很好地支撑阿里系各个数据团队各类数据处理任务的日常运行和维护,每天在系统上运行的各类数据处理任务多达数十万个,日处理数据量达 P B 级,在性能、成本控制、稳定性等方面取得了良好的效果。

在大数据系统中,离线批处理技术可以满足非常多的数据使用场景需求,但在 DT 时代,每天面对的信息是瞬息万变的,越来越多的应用场景对数据的时效性提出了更高的要求。数据价值是具有时效性的,在一条数据产生的时候,如果不能及时处理并在业务系统中使用,就不能让数据保持最高的“新鲜度”和价值最大化。

如图5.1 所示是2016 年“双 11”全球狂欢节当天,面向媒体开发的数据直播大屏在24 点时定格的成交数据:1207 亿。在前台实时直播的数据,实际上是阿里实时计算系统在承载。直播大屏对数据有着非常高的精度要求,同时面临着高吞吐量、低延时、零差错、高稳定等多方面的挑战。在“双门”的24 小时中,支付峰值高达12 万笔/秒,下单峰值达17 .5 万笔/秒,处理的总数据量高达百亿,并且所有数据是实时对外披露的,所以数据的实时计算不能出现任何差错。除此之外,所有的代码和计算逻辑都需要封存,并随时准备面对监管机构的问询和检查。

除面向媒体的数据大屏外,还有面向商家端的数据大屏、面向阿里巴巴内部业务运营的数据大屏。整个大屏直播功能需要实时处理的数据量非常庞大,每秒的总数据量更是高达亿级别,这就对实时计算架构提出了非常高的要求。面对如此庞大的数据量,阿里巴巴的实时处理是如何做到高精度、高吞吐量、低延时、强保障的呢?

相对于离线批处理技术,流式实时处理技术作为一个非常重要的技术补充,在阿里巴巴集团内被广泛使用。在大数据业界中,流计算技术的研究是近年来非常热门的课题。

业务诉求是希望能在第一时间拿到经过加工后的数据,以便实时监控当前业务状态并做出运营决策,引导业务往好的方向发展。比如网站上一个访问量很高的广告位,需要实时监控广告位的引流效果,如果转化率非常低的话,运营入员就需要及时更换为其他广告,以避免流量资源的浪费。在这个例子中,就需要实时统计广告位的曝光和点击等指标作为运营决策的参考。

按照数据的延迟情况,数据时效性一般分为三种(离线、准实时、实时):

·离线:在今天( T)处理 N 天前( T-N, N > I )的数据,延迟时间粒度为天。

·准实时:在当前小时( H)处理 N 小时前( H-N, N>O ,如0.5小时、 1 小时等)的数据,延迟时间粒度为小时。

·实时:在当前时刻处理当前的数据,延迟时间粒度为秒;

离线和准实时都可以在批处理系统中实现(比如 Hadoop 、Max Compute 、 Spark 等系统),只是调度周期不一样而己,而实时数据则需要在流式处理系统中完成。简单来说,流式数据处理技术是指业务系统每产生一条数据,就会立刻被采集并实时发送到流式任务中进行处理,不需要定时调度任务来处理数据。

整体来看,流式数据处理一般具有以下特征。

1 .时效性高

数据实时采集、实时处理,延时粒度在秒级甚至毫秒级,业务方能够在第一时间拿到经过加工处理后的数据。

2 .常驻任务

区别于离线任务的周期调度,流式任务属于常驻进程任务,一旦启动后就会一直运行,直到人为地终止,因此计算成本会相对比较高。这一特点也预示着流式任务的数据源是无界的,而离线任务的数据源是有界的。这也是实时处理和离线处理最主要的差别,这个特性会导致实时任务在数据处理上有一定的局限性。

3 .性能要求高

实时计算对数据处理的性能要求非常严格,如果处理吞吐量跟不上采集吞吐量,计算出来的数据就失去了实时的特性。比如实时任务1 分钟只能处理30 秒采集的数据,那么产出的数据的延时会越来越长,不能代表当前时刻的业务状态,有可能导致业务方做出错误的运营决策。在互联网行业中,需要处理的数据是海量的,如何在数据量快速膨胀的情况下也能保持高吞吐量和低延时,是当前面临的重要挑战。因此,实时处理的性能优化占了任务开发的很大一部分工作。

4 .应用局限性

实时数据处理不能替代离线处理,除了计算成本较大这个因素外,对于业务逻辑复杂的场景(比如双流关联或者需要数据回滚的情况),其局限性导致支持不足。另外,由于数据源是流式的,在数据具有上下文关系的情况下,数据到达时间的不确定性导致实时处理跟离线处理得出来的结果会有一定的差异。

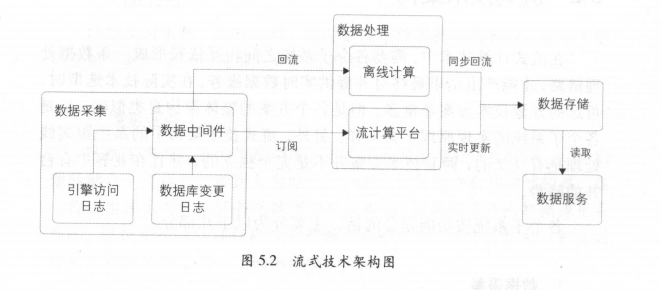

在流式计算技术中,需要各个子系统之间相互依赖形成一条数据处理链路,才能产出结果最终对外提供实时数据服务。在实际技术选型时,可选的开源技术方案非常多,但是各个方案的整体架构是类似的,只是各个子系统的实现原理不太一样。另外,流式技术架构中的系统跟离线处理是有交叉的,两套技术方案并不是完全独立的,并且在业界中有合并的趋势。各个子系统按功能划分的话,主要分为以下几部分。

1 .数据采集

数据的源头,一般来自于各个业务的日志服务器(例如网站的浏览行为日志、订单的修改日志等),这些数据被实时采集到数据中间件中,供下游实时订阅使用。

2 .数据处理

数据被采集到中间件中后,需要下游实时订阅数据,并拉取到流式计算系统的任务中进行加工处理。这里需要提供流计算引擎以支持流式任务的执行。

3 .数据存储

数据被实时加工处理(比如聚合、清洗等)后,会写到某个在线服务的存储系统中,供下游调用方使用。这里的写操作是增量操作,并且是源源不断的。

4 .数据服务

在存储系统上会架设一层统一的数据服务层(比如提供 HSF 接口、HTTP 服务等),用于获取实时计算结果。

从图5.2 可以看出,在数据采集和数据服务部分实时和离线是公用的,因为在这两层中都不需要关心数据的时效性。这样才能做到数据源的统一,避免流式处理和离线处理的不一致。

数据采集是整个数据处理链路的源头,是所有数据处理链路的根节点,既然需要做到实时计算,那么自然就需要做到实时采集了。所采集的数据都来自于业务服务器,从所采集的数据种类来看,主要可以划分为两种:

·数据库变更日志,比如 MySQL 的 binlog 日志、 HBase 的 hlog 日志、 Ocean Base 的变更日志、 Oracle 的变更日志等。

·引擎访问日志,比如用户访问网站产生的 Apache 引擎日志、搜索引擎的接口查询日志等。不管是数据库变更日志还是引擎访问日志,都会在业务服务器上落地成文件,所以只要监控文件的内容发生变化,采集工具就可以把最新的数据采集下来。一般情况下,出于吞吐量以及系统压力上的考虑,并不是新增一条记录就采集一次,而是基于下面的原则,按批次对数据进行采集。

·数据大小限制:当达到限制条件时,把目前采集到的新数据作为一批(例如512KB 写一批)。

·时间阐值限制:当时间达到一定条件时,也会把目前采集到的新数据作为一批,避免在数据量少的情况下一直不采集(例如30 秒写一批)。

只要上面的其中一个条件达到了,就会被作为一批新数据采集到数据中间件中。这两个条件的参数需要根据业务的需求来设定,当批次采集频繁时,可以降低延时,但必然会导致吞吐量下降。

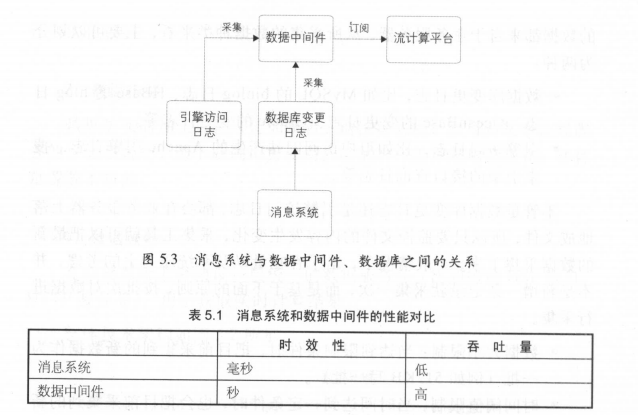

对于采集到的数据需要一个数据交换平台分发给下游,这个平台就是数据中间件。数据中间件系统有很多实现方式,比如开源的系统有Kafka ,而阿里巴巴集团内部用得比较多的是 TimeTunnel (原理和 Kafka类似),还有 MetaQ 、 Notify 等消息系统。 从图5 .3 可以看出,消息系统是数据库变更节点的上游,所以它的延时比数据中间件低很多,但是其支持的吞吐量有限。因此,消息系统一般会用作业务数据库变更的消息中转,比如订单下单、支付等消息。

对于其他较大的业务数据(每天几十 T B 的容量),一般会通过数据中间件系统来中转,虽然它的延时在秒级,但是其支持的吞吐量高。消息系统和数据中间件的性能对比如表5.1 所示。

另外,在一些情况下,有些业务并没有通过消息系统来对数据库进行更新(比如有些子业务的订单数据是通过同步方式导入 MySQL 的)。也就是说,从消息系统中获取的数据并不是最全的,而通过数据库变更日志拿到的业务变更过程数据肯定是全的。因此,为了和离线数据源保持一致,一般都是通过数据中间件来采集数据库变更数据这种形式来获取实时数据的(这需要在数据处理层对业务主键进行 merge 处理,比如一笔订单可能会被变更多次,会有多条变更记录,这时就需要进行 merge拿到最新的数据)。

时效性和吞吐量是数据处理中的两个矛盾体,很多时候需要从业务的角度来权衡使用什么样的系统来做数据中转。

实时计算任务部署在流式计算系统上,通过数据中间件获取到实时源数据后进行实时加工处理。在各大互联网公司中,有各种开源的和非开源的流计算引擎系统在使用。在业界使用比较广泛的是 Twitter 开源的 Storm 系统、雅虎开源的 S4 系统、 Apache 的 Spark Streaming ,以及最近几年兴起的 Flink 。这些系统的整体架构大同小异,但是很多细节上的实现方式不太一样,适用于不同的应用场景。

在阿里巴巴集团内使用比较多的是阿里云提供的 StreamCompute系统,作为业界首创的全链路流计算开发平台,涵盖了从数据采集到数据生产各个环节,力保流计算开发严谨、可靠。其提供的 SQL 语义的流式数据分析能力( StreamSQL ),让流数据分析门槛不再存在。它在Storm 的基础上包装了一层 SQL 语义,方便开发入员通过写 SQL 就可以实现实时计算,不需要关心其中的计算状态细节,大大提高了开发效率,降低了流计算的门槛。当然,它也支持传统模式的开发,就像 Hadoop中的 Hive 和 MapReduce 的关系一样,根据不同的应用场景选择不同的方式。另外, StreamCompute 还提供了流计算开发平台,在这个平台上就可以完成应用的相关运维工作,不需要登录服务器操作,极大地提高了运维效率。

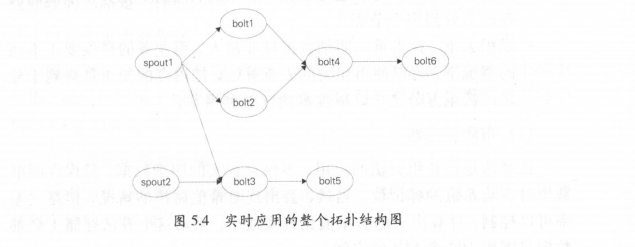

下面以 Storm 为例,简单讲一下流数据处理的原理。实时应用的整个拓扑结构是一个有向无环图(详情可参考 Apache Storm 的官网:http ://storm.apache.org/ index.html ),如图5.4 所示。

• spout :拓扑的输入,从数据中间件中读取数据,并且根据自定义的分发规则发送给下游的 bolt ,可以有多个输入源。

• bolt :业务处理单元,可以根据处理逻辑分为多个步骤,其相互之间的数据分发规则也是自定义的。

实时数据处理应用出于性能考虑,计算任务往往是多线程的。一般会根据业务主键进行分桶处理,并且大部分计算过程需要的数据都会放在内存中,这样会大大提高应用的吞吐量。当然,为了避免内存溢出,内存中过期的数据需要定时清理,可以按照 LRU (最近最少使用)算法或者业务时间集合归类清理(比如业务时间属于 T-1 的,会在今天凌晨进行清理)。

下面就实时任务遇到的几个典型问题进行讲解。

1 .去重指标

在 BI (商业智能)统计类实时任务中,对于资源的消耗有一类指标是非常高的,那就是去重指标。由于实时任务为了追求处理性能,计算逻辑一般都是在内存中完成的,中间结果数据也会缓存在内存中,这就带来了内存消耗过多的问题。在计算去重时,势必要把去重的明细数据保存下来,当去重的明细数据达到上亿甚至几十亿时,内存中放不下了,怎么办?这时需要分两种情况去看:

·精确去重。在这种情况下,明细数据是必须要保存下来的,当遇到内存问题时,可以通过数据倾斜来进行处理,把一个节点的内存压力分到多个节点上。

·模糊去重。在去重的明细数据量非常大,而业务的精度要求不高的情况下,可以使用相关的去重算法,把内存的使用量降到千分之一甚至万分之一,以提高内存的利用率。

( 1 )布隆过滤器

该算法是位数组算法的应用,不保存真实的明细数据,只保存明细数据对应哈希值的标记位。当然,会出现哈希值碰撞的情况,但是误差率可以控制,计算出来的去重值比真实值小。采用这个算法存储 1亿条数据只需要100 多 MB 的空间。

适用场景:统计精度要求不高,统计维度值非常多的情况。比如统计全网各个商家的 UV 数据,结果记录数达到上千万条。因为在各个维度之间,布隆过滤器是可以共用的。

(2 )基数估计

该算法也是利用哈希的原理,按照数据的分散程度来估算现有数集的边界,从而得出大概的去重值总和。这里估算的去重值可能比真实值大,也可能比真实值小。采用这个算法存储1 亿条数据只需要几 KB 的内存。

适用场景:统计精度要求不高,统计维度非常粗的情况。比如整个大盘的 UV 数据,每天的结果只有一条记录。基数估计在各个维度值之间不能共用,比如统计全天小时的 UV 数据,就需要有2 4 个基数估计对象,因此不适合细粒度统计的场景。这两个算法可以在网上搜索到具体的实现细节,这里就不细讲了。

2 .数据倾斜

数据倾斜是 ETL 中经常遇到的问题,比如计算一天中全网访客数或者成交额时,最终的结果只有一个,通常应该是在一个节点上完成相关的计算任务。在数据量非常大的时候,单个节点的处理能力是有限的,必然会遇到性能瓶颈。这时就需要对数据进行分桶处理,分桶处理和离线处理的思路是一样的。

(1 )去重指标分桶

通过对去重值进行分桶 Hash ,相同的值一定会被放在同一个桶中去重,最后再把每个桶里面的值进行加和就得到总值,这里利用了每个桶的 CPU 和内存资源。

(2)非去重指标分桶

数据随机分发到每个桶中,最后再把每个桶的值汇总,主要利用的是各个桶的 CPU 能力。

3 .事务处理

由于实时计算是分布式处理的,系统的不稳定性必然会导致数据的处理有可能出现失败的情况。比如网络的抖动导致数据发送不成功、机器重启导致数据丢失等。在这些情况下,怎么做到数据的精确处理呢?

上面提到的几个流计算系统几乎都提供了数据自动 ACK 、失败重发以及事务信息等机制。

·超时时间:由于数据处理是按照批次来进行的,当一批数据处理超时时,会从拓扑的 spout 端重发数据。另外,批次处理的数据量不宜过大,应该增加一个限流的功能(限定一批数据的记录数或者容量等),避免数据处理超时。

·事务信息:每批数据都会附带一个事务 ID 的信息,在重发的情况下,让开发者自己根据事务信息去判断数据第一次到达和重发时不同的处理逻辑。

·备份机制:开发入员需要保证内存数据可以通过外部存储恢复,因此在计算中用到的中间结果数据需要备份到外部存储中。

上面的这些机制都是为了保证数据的幕等性。

实时任务在运行过程中,会计算很多维度和指标,这些数据需要放在一个存储系统中作为恢复或者关联使用。其中会涉及三种类型的数据:

·中间计算结果一一在实时应用处理过程中,会有一些状态的保存(比如去重指标的明细数据),用于在发生故障时,使用数据库中的数据恢复内存现场。

·最终结果数据一一指的是通过 ETL 处理后的实时结果数据,这些数据是实时更新的,写的频率非常高,可以被下游直接使用。

·维表数据一一在离线计算系统中,通过同步工具导入到在线存储系统中,供实时任务来关联实时流数据。后面章节中会讲到维表的使用方式。

数据库分为很多种类型,比如关系型数据库、列式数据库、文档数据库等,那么在选择实时任务所使用的数据库时应该注意哪些特征呢?

前面提到实时任务是多线程处理的,这就意味着数据存储系统必须能够比较好地支持多并发读写,并且延时需要在毫秒级才能满足实时的性能要求。在实践中,一般使用 HBase 、 Tair 、 MongoDB 等列式存储系统。由于这些系统在写数据时是先写内存再落磁盘,因此写延时在毫秒级;读请求也有缓存机制,重要的是多并发读时也可以达到毫秒级延时。

但是这些系统的缺点也是比较明显的,以 HBase 为例,一张表必须要有 row key ,而 rowkey 是按照 ASCII 码来排序的,这就像关系型数据库的索引一样, row key 的规则限制了读取数据的方式。如果业务方需要使用另一种读取数据的方式,就必须重新输出 row key 。从这个角度来看, HBase 没有关系型数据库方便。但是 HBase 的一张表能够存储几 TB 甚至几十 TB 的数据,而关系型数据库必须要分库分表才能实现这个量级的数据存储。因此,对于海量数据的实时计算,一般会采用非关系型数据库,以应对大量的多并发读写。

下面介绍在数据统计中表名设计和 rowkey 设计的一些实践经验。

1 .表名设计

设计规则:汇总层标识+数据域+主维度+时间维度

例如: dws_trd_slr_dtr ,表示汇总层交易数据,根据卖家( sir )主维度+0点截至当日( dtr )进行统计汇总。这样做的好处是,所有主维度相同的数据都放在一张物理表中,避免表数量过多,难以维护。另外,可以从表名上直观地看到存储的是什 么数据内容,方便排查问题。

2 .rowkey 设计

设计规则: MD5 +主维度+维度标识+子维度1 +时间维度+子维度2

例如:卖家 ID 的 MD5 前四位+卖家 ID+ app +一级类目 ID+ddd +二级类目 ID 。以 MD5 的前四位作为 row key 的第一部分,可以把数据散列,让服务器整体负载是均衡的,避免热点问题。在上面的例子中,卖家 ID 属于主维度,在查数据时是必传的。每个统计维度都会生成一个维度标识,以便在 row key 上做区分。

实时数据落地到存储系统中后,使用方就可以通过统一的数据服务获取到实时数据。比如下一章将要讲到的 OneService ,其好处是:

·不需要直连数据库,数据源等信息在数据服务层维护,这样当存储系统迁移时,对下游是透明的。

·调用方只需要使用服务层暴露的接口,不需要关心底层取数逻辑的实现。

·屏蔽存储系统间的差异,统一的调用日志输出,便于分析和监控下游使用情况。

数据模型设计是贯通数据处理过程的,流式数据处理也一样,需对数据流建模分层。实时建模跟要离线建模非常类似,数据模型整为五层( ODS 、 DWD 、 DWS 、ADS 、 DIM )。

由于实时计算的局限性,每一层中并没有像离线做得那么宽,维和指标也没有那么多,特别是涉及回溯状态的指标,在实时数据模型中几乎没有

整体来看,实时数据模型是离线数据模型的一个子集,在实时数据处理过程中,很多模型设计就是参考离线数据模型实现的。

下面从数据分层、多流关联、维表使用这三个方面来详细说明。

在流式数据模型中,数据模型整体上分为五层。

1 .ODS 层

跟离线系统的定义一样, ODS 层属于操作数据层,是直接从业务系统采集过来的最原始数据,包含了所有业务的变更过程,数据粒度也是最细的。在这一层,实时和离线在源头上是统一的,这样的好处是用同一份数据加工出来的指标,口径基本是统一的,可以更方便进行实时和离线间数据比对。例如:原始的订单变更记录数据、服务器引擎的访问日志。

2 .DWD 层

DWD 层是在 ODS 层基础上,根据业务过程建模出来的实时事实明细层,对于访问日志这种数据(没有上下文关系,并且不需要等待过程的记录),会回流到离线系统供下游使用,最大程度地保证实时和离线数据在 ODS 层和 DWD 层是一致的。例如:订单的支付明细表、退款明细表、用户的访问日志明细表。

3 .DWS 层

订阅明细层的数据后,会在实时任务中计算各个维度的汇总指标。如果维度是各个垂直业务线通用的,则会放在实时通用汇总层,作为通用的数据模型使用。比如电商网站的卖家粒度,只要涉及交易过程,就会跟这个维度相关,所以卖家维度是各个垂直业务的通用维度,其中的汇总指标也是各个业务线共用的。例如:电商数据的几大维度的汇总表(卖家、商品、买家)。

4 .ADS 层

个性化维度汇总层,对于不是特别通用的统计维度数据会放在这一层中,这里计算只有自身业务才会关注的维度和指标,眼其他业务线一般没有交集,常用于一些垂直创新业务中。例如:手机淘宝下面的某个爱逛街、微淘等垂直业务。

5 .DIM 层

实时维表层的数据基本上都是从离线维表层导出来的,抽取到在线系统中供实时应用调用。这一层对实时应用来说是静态的,所有的 ETL处理工作会在离线系统中完成。维表在实时应用的使用中跟离线稍有区别,后面章节中会详细说明。例如:商品维表、卖家维表、买家维表、类目维表。

下面通过简单的例子来说明每一层存储的数据。

• ODS 层:订单粒度的变更过程,一笔订单有多条记录。

• DWD 层:订单粒度的支付记录,一笔订单只有一条记录。

• DWS 层:卖家的实时成交金额,一个卖家只有一条记录,并且指标在实时刷新。

• ADS 层:外卖地区的实时成交金额,只有外卖业务使用。

• DIM 层:订单商品类目和行业的对应关系维表。

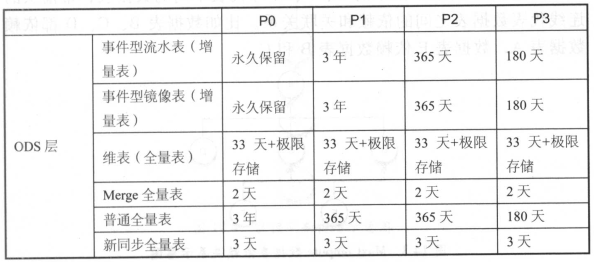

其中, ODS 层到 DIM 层的 ETL 处理是在离线系统中进行的,处理完成后会同步到实时计算所使用的存储系统。 OD S 层和 DWD 层会放在数据中间件中,供下游订阅使用。而 DWS 层和 ADS 层会落地到在线存储系统中,下游通过接口调用的形式使用。 在每一层中,按照重要性划分为 P0 、 P1 、 P2 、 P3 等级, P0 属于最高优先级保障。根据不同的优先级给实时任务分配不同的计算和存储资源,力求重要的任务可以得到最好的保障。

另外,字段命名、表命名、指标命名是按照 OneData 规范来定义的,以便更好地维护和管理。具体 On e Data 的说明见后续章节。

在流式计算中常常需要把两个实时流进行主键关联,以得到对应的实时明细表。在离线系统中两个表关联是非常简单的,因为离线计算在任务启动时已经可以获得两张表的全量数据,只要根据关联键进行分桶关联就可以了。但流式计算不一样,数据的到达是一个增量的过程,并且数据到达的时间是不确定的和无序的,因此在数据处理过程中会涉及中间状态的保存和恢复机制等细节问题。

比如 A 表和 B 表使用 ID 进行实时关联,由于无法知道两个表的到达顺序,因此在两个数据流的每条新数据到来时,都需要到另外一张表中进行查找。如 A 表的某条数据到达,到 B 表的全量数据中查找,如果能查找到,说明可以关联上,拼接成一条记录直接输出到下游;但是如果关联不上,则需要放在内存或外部存储中等待,直到 B 表的记录也到达。多流关联的一个关键点就是需要相互等待,只有双方都到达了,才能关联成功。

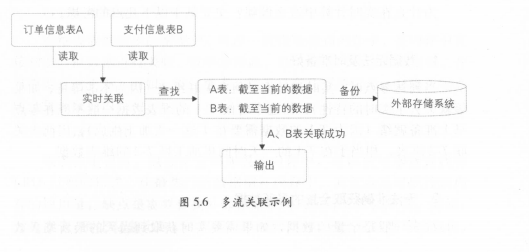

下面通过例子(订单信息表和支付信息表关联)来说明,如图5 .6所示。

在上面的例子中,实时采集两张表的数据,每到来一条新数据时都在内存中的对方表截至当前的全量数据中查找,如果能查找到,则说明关联成功,直接输出;如果没查找到,则把数据放在内存中的自己表数据集合中等待。另外,不管是否关联成功,内存中的数据都需要备份到外部存储系统中,在任务重启时,可以从外部存储系统中恢复内存数据,这样才能保证数据不丢失。因为在重启时,任务是续跑的,不会重新跑之前的数据。

另外,订单记录的变更有可能发生多次(比如订单的多个字段多次更新),在这种情况下,需要根据订单 ID 去重,避免 A 表和 B 表多次关联成功;否则输出到下游就会有多条记录,这样得到的数据是有重复的。

以上是整体的双流关联流程,在实际处理时,考虑到查找数据的性能,实时关联这个步骤一般会把数据按照关联主键进行分桶处理,并且在故障恢复时也根据分桶来进行,以降低查找数据量和提高吞吐量。

在离线系统中,一般是根据业务分区来关联事实表和维表的,因为在关联之前维表的数据就已经就绪了。而在实时计算中,关联维表一般会使用当前的实时数据( T )去关联 T-2 的维表数据,相当于在 T 的数据到达之前需要把维表数据准备好,并且一般是一份静态的数据。为什么在实时计算中这么做呢?主要基于以下几点的考虑。

1 .数据无法及时准备好

当到达零点时,实时流数据必须去关联维表(因为不能等待,如果等就失去了实时的特性),而这个时候 T-1 的维表数据一般不能在零点马上准备就绪(因为 T-1 的数据需要在 T 这一天加工生成),因此去关联T-2 维表,相当于在 T-1 的一天时间里加工好 T-2 的维表数据。

2 .无法准确获取全量的最新数据

维表一般是全量的数据,如果需要实时获取到当天的最新维表数据,则需要 T-1 的数据+当天变更才能获取到完整的维表数据。也就是说,维表也作为一个实时流输入,这就需要使用多流实时关联来实现。但是由于实时数据是无序的并且到达时间不确定,因此在维表关联上有歧义。

3 .数据的无序性

如果维表作为实时流输入的话,获取维表数据将存在困难。比如10:00 点的业务数据成功关联维表,得到了相关的维表字段信息,这个时候是否就已经拿到最新的维表数据了呢?其实这只代表拿到截至10:00 点的最新状态数据(实时应用永远也不知道什么时候才是最新状态,因为不知道维表后面是否会发生变更)。因此在实时计算中维表关联一般都统一使用 T-2 的数据,这样对于 业务来说,起码关联到的维表数据是确定的(虽然维表数据有一定的延时,但是许多业务的维表在两天之间变化是很少的)。

在有些业务场景下,可以关联 T-1 的数据,但 T-1 的数据是不全的。比如在 T-1的晚上22:00 点开始对维表进行加工处理,在零点到达之前,有两个小时可以把数据准备好,这样就可以在 T 的时候关联 T-1 的数据了,但是会缺失两个小时的维表变更过程。另外,由于实时任务是常驻进程的,因此维表的使用分为两种形式。

( 1)全量加载

在维表数据较少的情况下,可以一次性加载到内存中,在内存中直接和实时流数据进行关联,效率非常高。但缺点是内存一直占用着,并且需要定时更新。例如:类目维表,每天只有几万条记录,在每天零点时全量加载到内存中。

(2)增量加载

维表数据很多,没办法全部加载到内存中,可以使用增量查找和LRU 过期的形式,让最热门的数据留在内存中。其优点是可以控制内存的使用量;缺点是需要查找外部存储系统,运行效率会降低。例如:会员维表,有上亿条记录,每次实时数据到达时,去外部数据库中查询,并且把查询结果放在内存中,然后每隔一段时间清理一次最近最少使用的数据,以避免内存溢出。

在实际应用中,这两种形式根据维表数据量和实时性能要求综合考虑来选择使用。

大促是电商行业的狂欢节,在这期间,各个业务系统面临的峰值都会达到最高点,每年大促的海量数据处理给实时计算的性能和保障提出了很大的挑战。

大促和日常比较,在数据量以及要求上有非常大的区别,日常不怎么关注的点,在大促的时候会被放大,并且一天中的峰值特别明显,数据量是其他时间点的几倍甚至数十倍,这对系统的抗压能力要求非常高,不能因为洪流的到来而把系统压垮。

1 .毫秒级延时

大促期间,业务方和用户都会对实时数据非常关注,特别是在跨过零点的时候,第一个实时数字的跳动对业务方来说意义重大,预示着大促狂欢节真正开始。其他的产品,例如全球媒体直播大屏,更是要求延时达到毫秒级。这种要求吞吐量和延时兼得的情况,必须要做一些有针对性的优化工作才能满足要求。

2 .洪峰明显

大促就是全国乃至全世界的狂欢节,零点开售时的峰值陡峰是非常明显的,一般是日常峰值的几十倍,这对数据处理链路的每个系统都是巨大的挑战。因此,在大促前会进行多次全链路压测和预案梳理,确保系统能够承载住洪峰的冲击。

3.高保障性

由于关注的人非常多,只要出现数据延迟或者数据质量的问题,业务方的反弹就比较大,并且会第一时间感知到数据异常。因此,在大促期间一般都要求高保障’性,一些特殊的情况甚至需要做到强保障。对于强保障的数据,需要做多链路冗余(从来集、处理到数据服务整个数据链路都需要做物理隔离)(见图5.7 )。当任何一条链路出现问题时,都能够一键切换到备链路,并且需要对业务方透明,让下游感知不到有链路上的切换(由于各个链路计算的速度有一定的差异,会导致数据在切换时出现短时间下跌的情况,使用方需要做指标大小的判断,避免指标下跌对用户造成困扰)。

4.公关特性

大促期间,数据及时对公众披露是一项重要的工作,这时候要求实时计算的数据质量非常高。这里面涉及主键的过滤、去重的精准和口径的统一等一系列问题,只有把每一个环节都做好才能保障和离线的数据一致。

大促是一场对数据计算的高吞吐量、低延时、高保障性、高准确性的挑战。

1 .如何进行实时任务优化

大促前的优化工作在实时计算中显得尤为重要,如果吞吐量跟不上的话,也就失去了实时的特性。吞吐量不佳原因非常多,有些眼系统资源有关,有些眼实现方式有关,以下几点是实时任务优化中经常需要考虑的要素。

(1 )独占资源和共享资源的策略

在一台机器中,共享资源池可以被多个实时任务抢占,如果一个任务在运行时80 %以上的时间都需要去抢资源,这时候就需要考虑给它分配更多的独占资源,避免抢不到 CPU 资源导致吞吐量急剧下降。

(2)合理选择缓存机制,尽量降低读写库次数

内存读写性能是最好的,根据业务的特性选择不同的缓存机制,让最热和最可能使用的数据留在内存中,读写库次数降低后,吞吐量自然就上升了。

(3)计算单元合并,降低拓扑层级

拓扑结构层级越深,性能越差,因为数据在每个节点间传输时,大部分是需要经过序列化和反序列化的,而这个过程非常消耗 CPU 和时间。

(4)内存对象共享,避免字符拷贝

在海量数据处理中,大部分对象都是以字符串形式存在的,在不同线程间合理共享对象,可以大幅降低字符拷贝带来的性能消耗,不过要注意不合理使用带来的内存溢出问题。

(5)在高吞吐量和低延时间取平衡

高吞吐量和低延时这两个特性是一对矛盾体,当把多个读写库操作或者 ACK 操作合并成一个时,可以大幅降低因为网络请求带来的消耗,不过也会导致延时高一些,在业务上衡量进行取舍。

2.如何进行数据链路保障

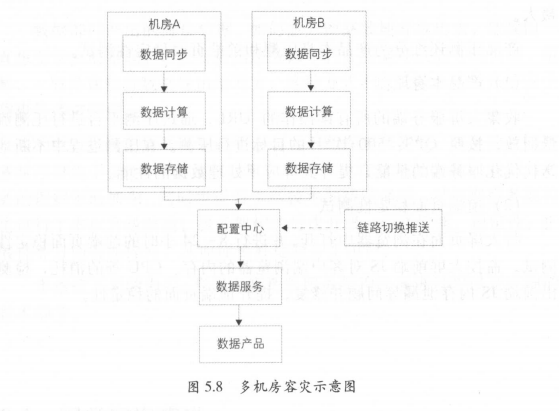

实时数据的处理链路非常长(数据同步→数据计算→数据存储→数据服务),每一个环节出现问题,都会导致实时数据停止更新。实时计算属于分布式计算的一种,而单个节点故障是常态的,这种情况在直播大屏中表现特别明显,因为数据不再更新,所有的用户都会发现数据出现了问题。因此,为了保障实时数据的可用性,需要对整条计算链路都进行多链路搭建,做到多机房容灾,甚至异地容灾(见图5.8 )。

由于造成链路问题的情况比较多,并且一般不能在秒级定位到原因,因此会通过工具比对多条链路计算的结果数据,当某条链路出现问题时,它一定会比其他链路计算的值小,并且差异会越来越大。这时候会一键切换到备链路,并且通过推送配置的形式让其秒级生效,所有的接口调用会立刻切换到备链路,对直播大屏完全透明,并且用户也感知不到故障的发生。

3.如何进行压测

在大促备战中,会对实时链路进行多次压测,主要是模拟“双1 1 ”的峰值情况,验证系统是否能够正常运行。压测都是在线上环境中进行的,分为数据压测和产品压测。数据压测主要是蓄洪压测,就是把几个小时甚至几天的数据积累下来,并在某个时刻全部放开,模拟“双11 ”洪峰流量的情况,这里面的数据是真实的。比如通过把实时作业的订阅数据点位调到几个小时或者几天前,这时候每一批读到的数据都是最多的,对实时计算的压力也最大。

产品压测还细分为产品本身压测和前端页面稳定性测试。

(1)产品本身压测

收集大屏服务端的所有读操作的 URL ,通过压测平台进行压测流量回放,按照 QPS: 500 次/秒的目标进行压测。在压测过程中不断地迭代优化服务端的性能,提升大屏应用处理数据的性能。

(2)前端页面稳定性测试

将大屏页面在浏览器中打开,并进行8 ~24 小时的前端页面稳定性测试。监控大屏前端 JS 对客户端浏览器的内存、 CPU 等的消耗,检测出前端 JS 内存泄漏等问题并修复,提升前端页面的稳定性。

数据部门产出的海量数据,如何能方便高效地开放出去,是我们一直想要解决的难题。在没有数据服务的年代,数据开放的方式简单、粗暴,一般是直接将数据导出给对方。这种方式不仅低效,还带来了安全隐患等诸多问题。

为此,我们在数据服务这个方向上不断探索和实践。最早的数据服务雏形诞生于2010 年,至今已有7 个年头。在这期间,随着我们对业务的理解不断加深,同时也得益于新技术的持续涌现,对数据服务架构也进行了多次升级改造。服务架构的每次升级,均在性能、稳定性、扩展性等方面有所提升,从而能更好地服务于用户。

本章接下来的内容,将为大家揭示服务架构的演进过程以及详细的技术细节。

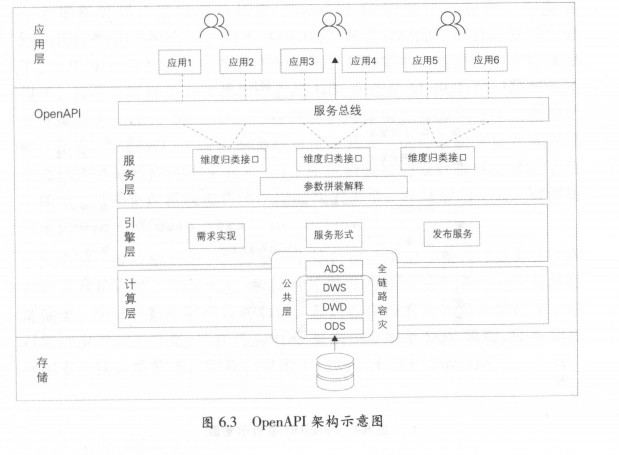

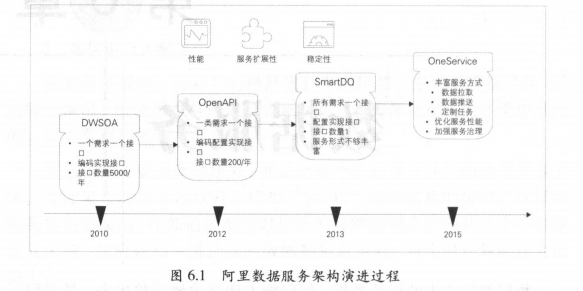

阿里数据服务架构演进过程如图6.1 所示。基于性能、扩展性和稳一寸大数据之路一一阿里巴巴大数据实践定性等方面的要求,我们不断升级数据服务的架构,依次经历了内部代号为 DWSOA 、 OpenAPI 、 SmartDQ 和 OneService 的四个阶段,下面将

详细介绍各个阶段的特点及问题。

DWSOA 是数据服务的第一个阶段,也就是将业务方对数据的需求通过 SOA 服务的方式暴露出去。由需求驱动,一个需求开发一个或者几个接口,编写接口文档,开放给业务方调用。

这种架构实现起来比较简单,但是其缺陷也是特别明显的。一方面,接口粒度比较粗,灵活性不高,扩展性差,复用率低。随着业务方对数据服务的需求增加,接口的数量也会很快从一位数增加到两位数,从两位数增加到三位数,其维护成本可想而知。另一方面,开发效率不高,无法快速响应业务。一个接口从需求开发、测试到最终的上线,整个流程走完至少需要 1天的时间,即使有时候仅仅是增加一、两个返回字段,也要走一整套流程,所以开发效率比较低,投入的入力成本较高。

DWSOA 阶段存在的明显问题,就是烟囱式开发,导致接口众多不好维护,因此需要想办法降低接口的数量。当时我们对这些需求做了调研分析,发现实现逻辑基本上就是从 DB 取数,然后封装结果暴露服务,并且很多接口其实是可以合并的。

OpenAPI 就是数据服务的第二个阶段。具体的做法就是将数据按照其统计粒度进行聚合,同样维度的数据,形成一张逻辑表,采用同样的接口描述。以会员维度为例:把所有以会员为中心的数据做成一张逻辑宽表,只要是查询会员粒度的数据,仅需要调用会员接口即可。通过一段时间的实施,结果表明这种方式有效地收敛了接口数量。

然而,数据的维度并没有我们想象的那么可控,随着时间的推移,大家对数据的深度使用,分析数据的维度也越来越多,当时 OpenAPI生产已有近100 个接口;同时也带来大量对象关系映射的维护工作量。

于是,在 OpenAPI 的基础上,再抽象一层,用 DSL (Domain Specific Language ,领域专用语言)来描述取数需求。新做一套 DSL 必然有一定的学习成本,因此采用标准的 SQL 语法,在此基础上做了一些限制和特殊增强,以降低学习成本。同时也封装了标准 DataSource ,可以使用 ORM (Object Relation Mapping ,对象关系映射)框架(目前比较主流的框架有 Hibernate 、 MyBatis 等)来解决对象关系映射问题。至此,所有的简单查询服务减少到只有一个接口,这大大降低了数据服务的维护成本。传统的方式查问题需要翻源码,确认逻辑;而 SmartDQ 只需要检查 SQL 的工作量,并且可以开放给业务方通过写 SQL 的方式对外提供服务,由服务提供者自己来维护 SQL ,也算是服务走向 DevOps 的一个里程碑吧。逻辑表虽然在 OpenAPI 阶段就已经存在,但是在SmartDQ 阶段讲更合适,因为 SmartDQ 把逻辑表的作用真正发挥出来了。 SQL 提供者只需关心逻辑表的结构,不需要关心底层由多少物理表组成,甚至不需要关心这些物理表是 HBase 还是 MySQL 的,是单表还是分库分表,因为 SmartDQ 已经封装了跨异构数据源和分布式查询功能。此外,数据部门字段的变更相对比较频繁,这种底层变更对应用层来说应该算是最糟糕的变更之一了。而逻辑表层的设计很好地规避了这个痛点,只变更逻辑表中物理字段的映射关系,并且即刻生效,对调用方来说完全无感知。

小结:接口易上难下,即使一个接口也会绑定-批人(业务方、接口开发维护入员、调用方)。所以对外提供的数据服务接口一定要尽可能抽象,接口的数量要尽可能收敛,最后在保障服务质量的情况下,尽可能减少维护工作量。现在 SmartDQ 提供300 多个 SQL 模板,每条 SQL承担多个接口的需求,而我们只用 1 位同学来维护 SmartDQ 。

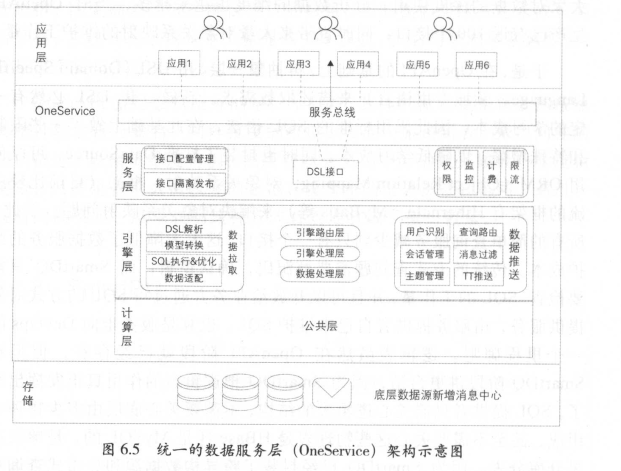

第四个阶段是统一的数据服务层(即 OneService )。大家心里可能会有疑问: SQL 并不能解决复杂的业务逻辑啊。确实, SmartDQ 其实只满足了简单的查询服务需求。我们遇到的场景还有这么几类:个性化的垂直业务场景、实时数据推送服务、定时任务服务。所以 OneService主要是提供多种服务类型来满足用户需求,分别是 OneService-SmartDQ 、OneService-Lego 、 OneService-iPush 、OneService-uTiming 。

上面提到过, SmartDQ 不能满足个性化的取数业务场景,可以使用Lego 。 Lego 采用插件化方式开发服务,一类需求开发一个插件,目前一共生产5 个插件。为了避免插件之间相互影响,我们将插件做成微服务,使用 Docker 做隔离。

实时数据服务 iPush 主要提供 Web Socket 和 long polling 两种方式,其应用场景主要是商家端实时直播。在“双 11”当天,商家会迫不及待地去刷新页面,在这种情况下 long polling 会给服务器带来成倍的压力。而 WebSocket 方式,可以在这种场景下,有效地缓解服务器的压力,给用户带来最实时的体验。

uTiming主要提供即时任务和定时任务两种模式,其主要应用场景是满足用户运行大数据量任务的需求。

在 OneService 阶段,开始真正走向平台化。我们提供数据服务的核心引擎、开发配置平台以及门户网站。数据生产者将数据入库之后,服务提供者可以根据标准规范快速创建服务、发布服务、监控服务、下线服务,服务调用者可以在门户网站中快速检索服务,申请权限和调用服务。

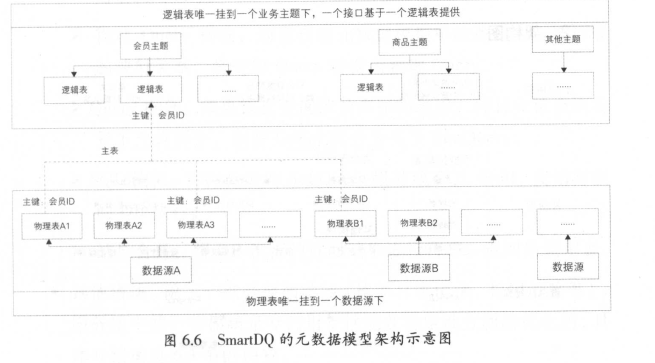

1 .元数据模型

SmartDQ 的元数据模型,简单来说,就是逻辑表到物理表的映射。

自底向上分别是:

(1)数据源

SmartDQ 支持跨数据源查询,底层支持接入多种数据源,比如 MySQL 、 HBase 、 Open Search 等。

(2)物理表

物理表是具体某个数据源中的一张表。每张物理表都需要指明主键由哪些列组成,主键确定后即可得知该表的统计粒度。

(3)逻辑表

逻辑表可以理解为数据库中的视图,是一张虚拟表,也可以看作是由若干主键相同的物理表构成的大宽表。 SmartDQ 对用户展现的只是逻辑表,从而屏蔽了底层物理表的存储细节。

(4)主题

逻辑表一般会挂载在某个主题下,以便进行管理与查找。

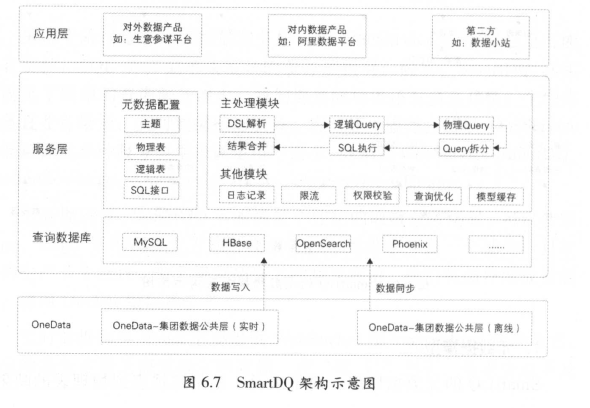

2.架构图

( 1 )查询数据库

SmartDQ 底层支持多种数据源,数据的来源主要有两种:①实时公共层的计算作业直接将计算结果写入 HBase ;②通过同步作业将公共层的离线数据同步到对应的查询库。

(2)服务层

·元数据配置。数据发布者需要到元数据中心进行元数据配置,建立好物理表与逻辑表的映射关系,服务层会将元数据加载到本地缓存中,以便进行后续的模型解析。

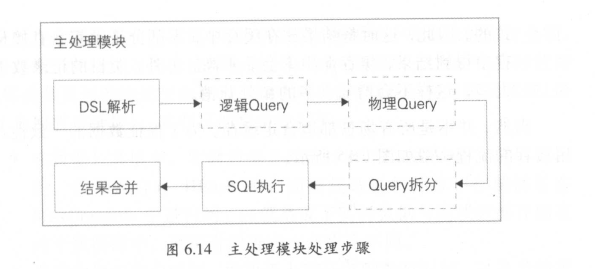

·主处理模块。一次查询从开始到结果返回,一般会经过如下几步。

DSL 解析:对用户的查询 DSL 进行语法解析,构建完整的查询树。

逻辑 Query 构建:遍历查询树,通过查找元数据模型,转变为逻辑 Query 。

物理 Query 构建:通过查找元数据模型中的逻辑表与物理表的映射关系,将逻辑 Query 转变为物理 Query 。

Query 拆分:如果该次查询涉及多张物理表,并且在该查询场景下允许拆分,则将 Query 拆分为多个 SubQuery 。

SQL 执行:将拆分后的 SubQuery 组装成 SQL 语句,交给对应的 DB 执行。

结果合并:将 DB 执行的返回结果进行合井,返回给调用者。

·其他模块。除了一些必要的功能(比如日志记录、权限校验等),服务层中的一些模块是专门用于性能及稳定性方面的优化的,具体介绍请见6.3 节的内容。

iPush 应用产品是一个面向 TT 、 MetaQ 等不同消息源,通过定制过滤规则,向 Web 、无线等终端推送消息的中间件平台。 iPush 核心服务器端基于高性能异步事件驱动模型的网络通信框架 Netty 4 实现,结合使用 Guava 缓存实现本地注册信息的存储, Filter 与 Server 之间的通信采用 Thrift 异步调用高效服务实现,消息基于 Disruptor 高性能的异步处理框架(可以认为是最快的消息框架)的消息队列,在服务器运行中Zookeeper 实时监控服务器状态,以及通过 Diamond 作为统一的控制触发中心。

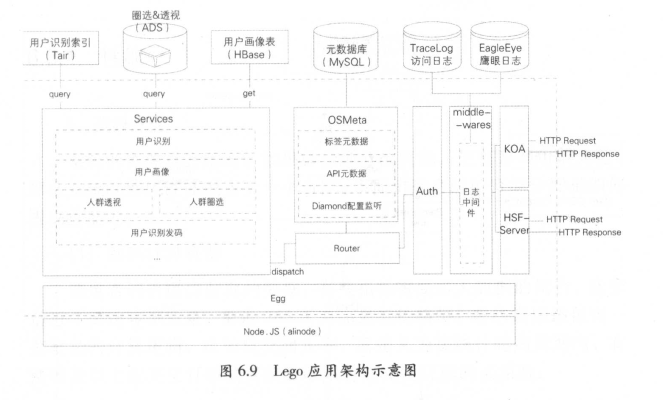

Lego 被设计成一个面向中度和高度定制化数据查询需求、支持插件机制的服务容器。它本身只提供日志、服务注册、 Diamond 配置监听、鉴权、数据源管理等一系列基础设施,具体的数据服务则由服务插件提供。基于 Lego 的插件框架可以快速实现个性化需求并发布上线。Lego 采用轻量级的 Node.JS 技术核实现,适合处理高并发、低延迟的 IO 密集型场景,目前主要支撑用户识别发码、用户识别、用户画像、入群透视和入群圈选等在线服务。底层根据需求特点分别选用 Tair 、HBase 、 ADS 存储数据。

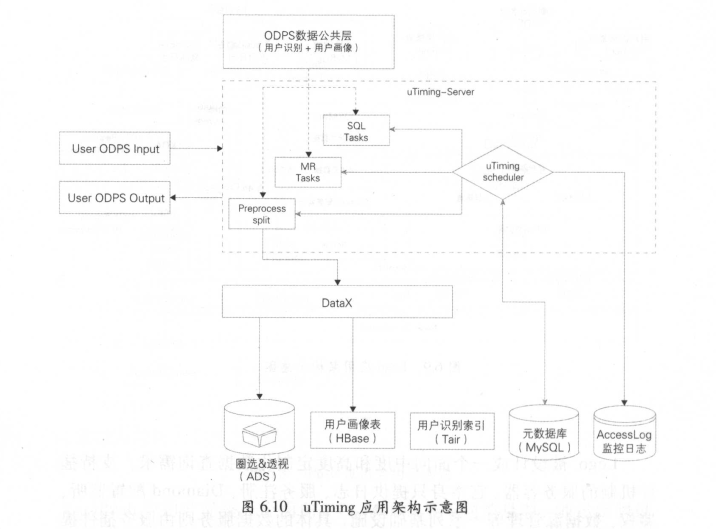

uTiming 是基于在云端的任务调度应用,提供批量数据处理服务,支撑用户识别、用户画像、入群圈选三类服务的离线计算,以及用户识别、用户画像、入群透视的服务数据预处理、入库。uTiming-scheduler 负责调度执行 SQL 或特定配置的离线任务,但并不直接对用户暴露任务调度接口。用户使用数据超市工具或 Lego API建立任务。

1.资源分配

系统的资源是有限的,如果能合理分配资源,使资源利用最大化,那么系统的整体性能就会上一个台阶。下面讲述合理的资源分配是如何提高性能的。

(1)剥离计算资源

调用者调用接口获取的数据,有些指标需要多天数据的聚合,比如最近7 天访客浏览量、最近365 天商品最低价格等;有些指标还包含一些复杂的计算逻辑,比如成交回头率,其定义为在统计时间周期内,有两笔及以上成交父订单的买家数除以有成交父订单的买家数。如此复杂的计算逻辑,如果放在每次调用接口时进行处理,其成本是非常高的。因此剥离复杂的计算统计逻辑,将其全部交由底层的数据公共层进行处理,只保留核心的业务处理逻辑。详细内容请参见第9 章。

(2)查询资源分配

查询接口分为两种: Get 接口,只返回一条数据; List 接口,会返回多条数据。一般来说, Get 查询基本都转换为 KV 查询,响应时间比较短,或者说查询代价比较小。而 List 查询的响应时间相对较长,且返回记录数比较多,这就增加了序列化以及网络传输的成本,查询代价肯定会更高一些。

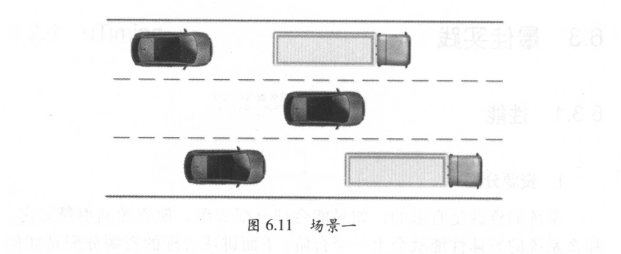

假如将 Get 、 List 请求都放在同一个线程池中进行查询,那么查询效率会怎么样?想象一下如图6.11 所示的场景,在高速公路上,行车道以及超车道全部都有大卡车在慢速行驶,后面的小轿车只能慢慢等待,并祈祷前方路段能少一些大卡车。这样整个路段的行车速度就降了下来,车流量也会下降许多。同理,虽然 Get 请求的真正查询耗时很短,但是会在队列等待上消耗大量的时间,这样整体的 QPS 会很不理想。

为此,我们设计了两个独立的线程池: Get 线程池和 List 线程池,分别处理 Get 请求和 List 请求,这样就不会因为某些 List 慢查询,而影响到 Get 快查询。系统的 QPS 比之前提升许多。回到上文的类比中,在高速公路上大卡车只行驶在最右车道上,小轿车行驶在其他车道上,这样整个路段也会畅通许多,如图6.12 所示。

List 查询的响应时间相对较长,所以 List 线程池设置的最大运行任务数就稍微多一些。另外,由于超时的限制, List 线程池的等待队列不宜过长。具体的参数设置,可以根据压力测试的结果评估出来。后期,也可以根据线上调用日志的统计,比如 List 请求与 Get 请求的比例来进行优化调整。

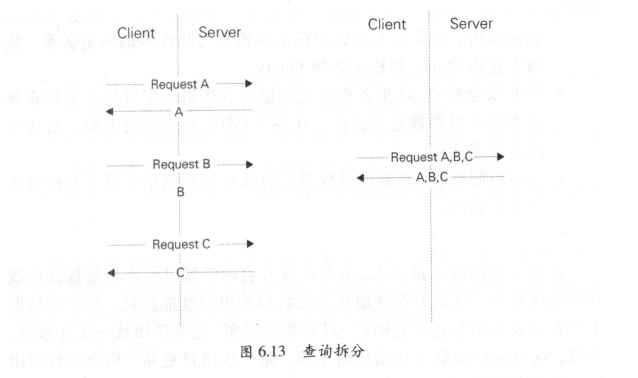

(3)执行计划优化

①查询拆分。举个例子,顾客去肯德基点餐,需要一个汉堡、一包薯条,再加一杯饮料。他可以先点个汉堡,拿到后再点包薯条,最后再点杯饮料,是不是很浪费时间?为了节约时间,他可以叫上朋友来帮忙,每个人负责一样,同时去点餐。这样是快了很多,但是需要顾客付出额外的成本。那么现实中应该是怎么样的呢?顾客直接跟服务员说需要这些,服务员可以分工协作,最后统一放在餐盘中,告知顾客可以取餐了。查询接口同样如此,接口暴露给调用者的指标都是逻辑字段,调用者不用关注这些逻辑字段对应的是哪张物理表的哪个物理宇段。比如调用者调用了 A,B,C 三个指标,这些指标分别在三张物理表中,引擎层会 将调用者的请求拆分成三个独立的查询,分别去三张物理表中查询,且这些查询是并发执行的。查询结束后,引擎层会将三个查询的结果汇总到一起返回给调用者,这样最大程度地降低了调用者的调用成本,并能保证查询性能(见图6.13 )。

②查询优化。上文提到 Get 请求与 List 请求分别有独立的线程池进行查询,但是一个请求具体是 Get 还是 List ,则依赖调用者具体调用哪个方法。在很多情况下,调用者调用的方法不一定是最合适的。比如,为了使代码更简洁,所有的调用全用 List 方法,这样就会造成很多本可以快速返回的查询,也在 List 线程池中进行排队。

查询优化,就是分析用户请求中的 SQL 语句,将符合条件的 List查询转换为 Get 查询,从而提高性能。具体的步骤是:

·解析 SQL 语句中的 WHERE 子句,提取出筛选字段以及筛选条件。

·假如筛选字段中包含了该逻辑表的所有主键,且筛选条件都为equal ,则说明主键都已经确定为固定值,返回记录数肯定为 1条。在这种场景中, List 查询就转换为 Get 查询。

2.缓存优化

(1)元数据缓存

在接口查询的过程中,查询引擎需要频繁地调用元数据信息。举例来说:

·查询解析,需要从元数据中得出逻辑表与物理表的映射关系,从而将逻辑 Query 解析为物理 Query 。

• SQL 安全检查,这里要根据元数据中的逻辑表配置信息来检查调用者的调用参数是否合法。比如 LIMIT 是否超过上限、必传字段是否遗漏等。

·字段权限检查,需要通过权限元数据来判断调用者是否有权限进行本次访问。

·.......

这些元数据的总量不大,因此在服务启动时就已经将全量数据加载到本地缓存中,以最大程度地减少元数据调用的性能损耗。后台对数据生产者的发布信息进行监听,一旦有新的发布,就重新加载一次元数据。不过,这时候的加载与初始化时不同,是一次增量更新,只会加载刚刚修改的元数据。

(2)模型缓存

接口查询的输入其实是 DSL ,而最终提交给 DB 执行的是物理 SQL 。在从 DSL 到物理 SQL 的转换过程中,经过了多步解析处理,如图6.14所示是 SmartDQ 架构图(见图6.7 )的一部分,展示了主处理模块的处理步骤。

模型缓存,就是将解析后的模型(包括逻辑模型、物理模型)缓存在本地。下次再遇到相似的 SQL 时,直接从缓存中得到解析结果,直接省略了图6 .14 中虚线框中的步骤,因而节省了 DSL-> SQL 的解析时间。具体做法如下:

·对 DSL 进行语法、词法分析,并替换 WHERE 中的常量。比如将 where user_id = 123 替换为 where user_id =?。

·以替换后的语句做 key ,去本地缓存中进行查找。如果命中,则提取出缓存中的模型,直接将 SQL 提交给 DB 查询。

·如果上一步没有命中,则进行正常的解析处理,并缓存解析后的结果。

需要注意的是,由于模型缓存在本地,为了避免占用太多的内存,需要定期将过期的模型淘汰掉。假如元数据有变更,则缓存中的模型有可能已经失效或者是错误的,因此需要全部清理掉。

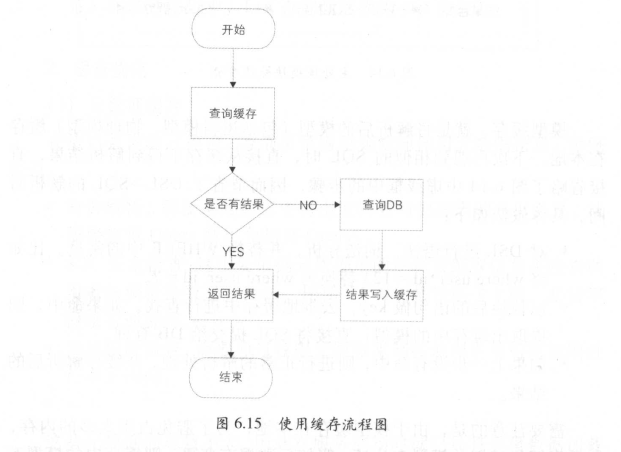

(3)结果缓存

在某些场景下,会对查询结果进行缓存,以提高查询性能。例如:

·某些查询可能比较复杂,直接查询 DB 响应时间较长。这时可以将结果进行缓存,下次执行相同的查询时,即可直接从缓存中获取结果,省去了 DB 查询这一步耗时操作。

·还有一种场景,比如获取某个卖家所属类目的统计指标,一个类目下可能会有十几万个卖家,这些卖家请求的结果肯定是完全一致的。因此,这时将结果放在缓存中,大部分请求都会直接从缓存中得到结果,缓存命中率会非常高。另外,类目的记录数不会太多,这样不会增加太多的额外开销。

当然,并不是所有场景都适合走缓存。为了保证数据的一致性,使用缓存的流程一般如图6.15 所示。

假设有这样的场景:获取某个卖家对应的指标。由于每个卖家只能请求自己的指标,因此就会导致绝大部分请求都需要从 DB 查询,再写入缓存中。这样不仅使得单次请求的成本会提升,而且缓存的记录数会非常大,利用率也非常低。所以,这种场景其实是不太适合走缓存的,直接走 DB 查询是比较合适的。

3 .查询能力

(1)合并查询

数据产品的有些场景,虽然表面上看只是展现几个数字而己,但是后台的处理逻辑其实并不简单。举例来说,展现某一日卖家的支付金额,有个日期选择框可以任意选择日期。日期为今天时,展现的是实时数据(从零点截至当前的成交金额);日期为昨天时,展现的就是离线数据(最近 1 天的成交金额)。其背后的复杂性在于:

·在数据公共层中,实时数据是在流计算平台 Galaxy 上进行计算的,结果保存在 HBase 中;而离线数据的计算和存储都是在 Max Compute 中进行的。这就造成了实时数据与离线数据存储在两个数据源中,调用者的查询方式完全不同。

·离线数据的产出时间,取决于上游任务的执行时间,以及当前平台的资源情况。所以其产出时间是无法估算的,有可能3 : 00 产出,也有可能延迟到6: 00 。在昨天的离线任务产出之前,其前台展现的数字只能来源于实时数据。

·出于对性能和成本的考虑,实时作业做了一些折中,去重时,视情况可能使用一些不精准的去重算法,这就导致实时数据的计算结果与离线数据存在一些差异。

综上所述,离线数据最准确,需要优先使用离线数据。如果离线数据还未产出,则改用实时数据。所以在简单的数字背后,需要使用者清晰地了解上述三点。

为了降低这种场景的复杂性,我们设计了一种新的语法一-REPLACE ,如图6.16 所示。

REPLACE 的效果就是用上边 SQL 的结果,根据 replace_key 去替换下边 SQL 的结果。比如上述 SQ L ,上边的查询是取离线数据,下边的查询是取实时数据,那么结果就是优先取离线数据,如果没有再去取实时数据。

调用者使用这样的语法,就可以实现离线数据替换实时数据的功能,不再需要考虑离线数据未产出等问题。

(2 )推送服务

有些数据产品需要展现实时指标,为了追求数据的实时性,都是轮询请求最新数据。轮询的间隔时间设置很重要,如果设置间隔时间较长,用户体验会不太好;如果设置很短,对服务器的请求压力会非常大,从而影响整体性能。另外,这种轮询请求的方式,其实很大部分时间是在浪费资源,因为有可能后台的数据根本没有更新,而前端却一直在请求。

那能不能换种方式呢?监听数据提供者,新数据产生时能够及时知道,并且告知用户,为此“推送”应运而生。推送服务很好地解决了数据更新的实时性问题,同时也减少了对服务器的请求压力。其主要从网络、内存、资源等方面做了如下设计:

·对消息生产者进行监听。比如监听消息源 TT ,一天的消息量可能有几百亿,但实际在线用户关心的可能就几亿甚至更少,所以并不是所有的消息都需要关心,做好消息过滤是非常必要的。

·过滤后的消息量也是可观的,推送服务无法满足高效的响应需求,这就需要考虑将符合条件的消息放置在临时队列中,但对于 有锁的队列,存在竞争则意味着性能或多或少会有些下降,所以采用无锁的队列 Disruptor 来存放消息是最佳的选择。在采用 Disruptor 的情况下,推送应用也考虑到可以对重要的消息配置单独的队列单线程运转,以提高性能。

·消息的推送必须基于 Socket 来实现, Netty 在性能表现上比较优秀,采用基于高性能异步事件的网络通信框架 Netty 是我们的最终选择。不同事件采用不同的监昕处理,职责分明也是提高性能的基础。

·推送应用是典型的 IO 密集型系统,在采用多线程解决性能问题的同时,也带来了上下文切换的损耗。在注册消息向 Filter 广播时,采用协程方式可以大大减少上下文切换,为性能的提高做出相应的贡献。

·从业务角度出发,主题也会存在重要级别或者优先级,适当地控制线程数以及流量,为某些重要的业务消息节约服务器资源也是备选方案。

·缓存的利用在推送应用中多处体现。例如对注册的在线用户信息做本地缓存,可以极大地提高读性能。

·对突发事件的推送也有针对性地做了很多工作。比如过滤服务器异常重启时,在线用户信息需要重新向该过滤服务器投递,但每条用户信息才几百字节,如果逐条投递,则会造成高流量带宽的浪费,所以批量投递甚至打包投递会大大降低网络开销。

1.发布系统

上文中提到,服务启动时会将元数据全量加载到本地缓存中。数据生产者会对元数据做一些修改,并发布到线上。那么,如何保证用户的变更是安全的,不会导致线上故障昵?如何保证不同用户发布的变更不会相互影响呢?下面将会阐述发布系统在稳定性保障方面的作用。

( 1)元数据隔离

一般的应用都会有三个环境:日常环境、预发环境和线上环境。日常环境用于线下开发测试。预发环境隔离了外部用户的访问,用于在正式发布前校验即将上线的代码。为了保障系统的稳定性,根据应用环境设计了三套元数据:日常元数据、预发元数据和线上元数据,如图6.17所示。

由图6.17 可知,三套元数据分别对应着三个应用环境,每个环境的应用只会访问对应的元数据。从用户修改元数据到最终正式上线,经过如下以下几步:

.用户在元数据管理平台上进行操作,修改元数据。此时, DB 中的预发元数据发生了变更,但是还没有加载到本地缓存中。

‘•

‘•

·用户点击“预发布”,此时预发元数据就会被加载到引擎的本地缓存中,在预发环境中就可以看到用户的最新修改了。此时,可以验证用户的修改是否会影响线上已有的功能。

·如果验证通过,则表明此次用户的修改是安全的。用户点击“正式发布”,预发元数据会将变更同步到线上元数据,并加载到引擎的本地缓存中。此时,在线上环境中也可以看到用户的变更。

至此,发布的整个流程就结束了。

此外,会有一个定时任务,定期将预发元数据同步到日常环境。通过元数据的隔离,使得用户的变更可以在预发环境中进行充分的验证,验证通过后再发布到线上环境中,避免了因用户误操作而导致线上故障,保障了系统的稳定性。

(2)隔离发布

发布系统还需要考虑到一点,就是隔离发布,即不同用户的发布不会相互影响。要实现这一点,需要做到:

·资源、划分。为了做到隔离发布,首先需要确定隔离的最小单元。由于调用者的查询请求最终都会转换成对某张逻辑表的查询,因此我们决定将隔离的粒度控制在逻辑表层面上。

·资源独占。当用户开始修改的时候,系统会锁定其正在修改的逻辑表及其下挂的物理表等资源,禁止其他用户修改。当用户正式发布变更后,就会释放锁定的资源,这时其他用户才可以对相关元数据进行修改。

·增量更新。用户每次只会修改某张逻辑表的对应元数据,因此发布时引擎是不需要重新加载全量元数据的,只需要加载所发布的逻辑表元数据即可。同理,预发元数据与线上元数据之间的数据同步,也仅仅需要同步用户修改的部分。

2 .隔离

隔离的一个作用是将系统划分为若干个独立模块,当某个模块出现问题时,整体功能仍然能保证可用。隔离的另一个作用是可以对系统资源进行有效的管理,从而提高系统的可用性。

( 1 )机房隔离

将服务器部署在两个机房中,每个机房独立部署一个集群,且机器数量尽量保持均衡,以实现双机房容灾。当一个机房发生故障时,另一个机房中的应用仍然可以对外服务。同时,需要保障内部调用优先,服务调用同机房优先,最大程度地减少双机房部署带来的网络开销。

(2)分组隔离

不同调用者的优先级不尽相同,且查询场景也存在一定的差异。所以,可以根据某些条件将调用者进行分层,然后将服务端的机器划分为若干个分组,每个分组都有明确的服务对象和保障等级。即使某个分组出现性能较差的查询,或者有突发大流量涌入,也不会影响其他分组的正常使用。另外,可以动态地调整分组规则,以重新分配每个分组的机器数量,在总体机器数量不变的情况下,实现资源的最大化利用。

3 .安全限制

对调用者的调用做了诸多安全限制,以防止查询消耗大量的资源,或者返回太多的记录。主要体现在以下几点:

·最大返回记录数。数据库的查询强制带上 LIMIT 限制,具体的数值以用户配置为准。

·必传字段。每张逻辑表都会配置主键,并标识哪些字段是调用者必须传入的。这样最终的 SQL 肯定会带上这些字段的限制条件,防止对表做全表扫描。

·超时时间。设置合适的超时时间,以使得超时的查询能及时终止并释放资源,保障系统不会被偶发的超时拖垮。

4 .监控

(1)调用日志采集

如果要对调用做监控,首先要保证调用日志的完整性。对于每次调用都进行了采集,采集的信息包括:

·基础信息,包括调用时间、接口名、方法名、返回记录数等。

·调用者信息,包括调用者应用名、来源 IP 地址等。

·调用信息,包括调用指标、查询筛选条件等。

·性能指标,包括响应时间、是否走缓存等。

·错误信息,包括出错原因、错误类型、数据源、错误堆械等。

(2)调用监控

有了调用日志,就可以监控系统的健康状况,及时发现问题。监控可以从以下几个方面展开:

·性能趋势。总体的 QPS 趋势图、 RT 趋势图、响应时长区间分布。分组性能统计、单机 QPS 统计,以对当前系统容量做评估。

·零调用统计。找出最近 N 天无调用的表,进行下线处理,节约成本。

·慢 SQL 查找。找出响应时间较长的 SQL ,及时进行优化。

·错误排查。当系统的调用错误数突增时,能从错误日志中及时发现出错原因、出错的数据源等。

5 .限流、降级

系统的总体容量,主要是根据平日的性能监控,以及定期的全链路压测评估得出,但是难免会遇到突发流量涌入的情况。此时,系统需要有合适的方式来应对突增流量,以免系统被压垮。

(1)限流

限流有很多种方法,我们采用的是应用内的 QPS 保护。针对调用者以及数据源等关键角色做了 QPS 阔值控制。也就是说,如果某个调用者的调用量突增,或者对某个数据源的查询流量突增,超过了预设的QPS 阈值,则后续的请求立即失败返回,不再继续处理。通过快速失败,将超出系统处理能力的流量直接过滤掉,保障了系统的可用性。

(2)降级

查询引擎底层是支持多种数据源接入的,但是接入的数据源越多,系统就越复杂,出问题的概率也就越大。假设某个数据源突然出现问题,或者某个数据源中的某张表访问超时,那么该如何处理才能保障整体的可用性呢?

理想的做法肯定是将这些数据源、表全部隔离成独立的模块,单个模块的故障不会引起整体不可用。但是,实际中隔离带来的成本也是比较大的,且有可能造成资源的浪费。假如没有隔离措施,所有数据源共享资源,这时候就需要通过降级将故障影响降到最低。降级主要有两种做法:

·通过限流措施,将 QPS 置为0 ,则对应的所有访问全部立即失败,防止了故障的扩散。

通过修改元数据,将存在问题的资源置为失效状态,则重新加载元数据后,对应的访问就全部失败了,不会再消耗系统资源。

进入 DT 时代,阿里巴巴作为全球最大的零售电子商务平台,正推动着大规模数据采集、计算、挖掘和产品化服务的生态圈构建。2016年财报显示,阿里巴巴集团平台成交额突破3 万亿元,年度活跃买家达到4.23 亿,已成为全球最大的移动经济实体。与 Google 、 Face book 、Amazon 等世界上其他先进的互联网公司一样,高速增长的业务必然催生大数据挖掘应用的蓬勃发展。当我们从业务系统中能够轻松采集到海量数据时,往往会发现里面的有效数据信息却越来越稀疏,有效数据和无效数据的增长率是不成比例的。因此,如何从海量数据中挖掘出有效信息形成真正的生产力,是所有大数据公司需要面对的共同课题。

数据挖掘技术与数据仓储及计算技术的发展是相辅相成的,没有数据基础设施的发展与分布式并行计算技术,就不会有深度学习,更不会见证 AlphaGo 的神奇。同样在阿里巴巴集团,得益于阿里云 Max Compute云计算平台的发展,海量、高速、多变化、多终端的结构与非结构化数据得以存储并高效地计算。近年来,阿里巴巴数据挖掘应用也呈现出井喷式的增长态势。面向海量会员和商品的全局画像、基于自然人的全域ID-Mapping、广告精准投放平台、千人千面的个性化搜索和推荐平台、非人流量与恶意设备的识别、商业竞争情报的自动化挖掘系统……这些或传统或新兴的大数据挖掘应用已深入阿里巴巴业务的各个环节,“无 数据不智能,无智能不商业”,大数据与 AI/机器学习融合后的新商业革命己然到来。

基于大数据的企业级数据挖掘需要包含两个要素:①面向机器学习算法的并行计算框架与算法平台;②面向企业级数据挖掘的算法资产管理体系。基于此,在接下来的章节中,我们会首先介绍阿里巴巴算法平台的发展历史,以及当下正在使用的算法计算框架和平台。然后阐述阿里巴巴的算法资产管理体系,领略企业级数据挖掘服务的标准、规范及资产管理艺术。最后将展示阿里巴巴当下最热门的一些数据挖掘应用案例,如消费者画像和互联网反作弊等,希望通过这些典型的应用案例,能让你更深层次地感知大数据、机器学习、入工智能融合后所产生的巨大能量及其在商业中发挥的巨大价值。

2012 年以前,由于数据的规模还不是特别庞大,大部分挖掘应用所需处理的样本量在百万以内,而处理的特征一般也少于100 维,那时业界有许多成熟的商业挖掘软件如 SAS 、 SPSS 、 Clementine 等,这些单机版运行的软件已经能满足绝大部分挖掘应用的需求,因此早几年阿里巴巴尚没有研发面向海量数据的高性能并行计算的算法平台。然而,随着数据量爆炸式的增长,以及分布式计算 Hadoop 、 Spark 、 Storm 等技术的引入,阿里巴巴的商业挖掘应用也步入大数据时代,和早几年不同,如今的挖掘算法需要面对的训练数据量动辄上亿,特征维度动辄百万,因此,近两、三年来,阿里巴巴集团也在大力发展自己的机器学习算法平台,并已取得阶段性成果。如今,阿里巴巴已建成一套稳定、高效的算法平台,该平台架构于阿里云 MaxCompute 、 GPU 等计算集群之上,汇集了阿里巴巴集团大量优质的分布式算法,包括数据处理、特征工程、机器学习算法、文本算法等,可高效地完成海量、亿级维度数据的复杂计算。除此之外,平台还提供了一套极易操作的可视化编辑页面,大大降低了数据挖掘的门槛,提高了建模效率。未来还将面向外部客户开放,配合阿里云的其他基础数据设施,为外部企业提供数据挖掘应用的基础能力。

下面简单介绍阿里巴巴算法平台的框架和原理。

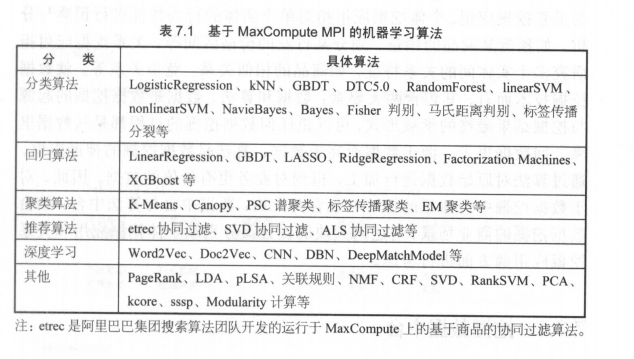

支持海量样本的高维特征训练是算法平台的必备要素,因此计算框架的选择非常重要。近几年来,业界主流的并行计算框架主要有MapReduce 、 MPI 、 Spark 等。在阿里巴巴集团内部,基于 MapReduce与 Hive 的计算己经能解决公司业务90%以上的离线数据分析任务。对于需要频繁进行网络通信、内存消耗高、计算要求快速迭代的算法任务, MPI 无疑是最佳选择。 MPI 是一种基于消息传递的并行计算框架,由于没有 IO 操作,性能优于 MapReduce 。因此,阿里巴巴的算法平选用 MPI 作为基础计算框架,其核心机器学习算法的开发都是基于阿里云 MaxCompute 的 MPI 实现的。

MaxCom pute MPI 的处理流程如图7 .1 所示,与分布式计算系统的原理类似,不再赘述。其中伏羲为阿里云飞天系统的分布式调度系统,女娲为阿里云飞天系统的分布式一致性协同服务系统,盘古为阿里云飞天系统的分布式文件存储系统。

基于 MaxCompute MPI ,目前阿里巴巴的算法平台已经集成了绝大部分业界主流的机器学习算法(见表7.1 ),从传统的分类、聚类算法,到互联网应用中非常流行的协同过滤、 PageRank 算法,再到当前最火热的深度学习算法,这些算法基本可以满足企业级数据挖掘应用的需要。配合阿里巴巴的大数据计算平台 Max Compute ,工程师们可以通过简易的命令式调用或拖拽式的可视化界面操作,将这些算法应用于自己的实际业务当中,体验机器学习算法与大数据结合后的强大功能与魅力。

在阿里巴巴集团,由于业务场景与商业智能分析需求的多样化,多个部门、多个商业智能及算法团队针对应用问题所提出的算法解决方案往往是独立的,通常一次数据挖掘的过程包括商业理解、数据准备、特征工程、模型训练、模型测试、模型部署、线上应用及效果反馈等环节。

如果对于每个应用都完全独立地设计这么一套流程,那么对于阿里巴巴成千上万的挖掘应用而言无疑将产生巨大的时间与经济成本,带来大量的重复建设和资源浪费。事实上,早在2015 年,阿里巴巴集团便提出了中台战略,将一些通用的技术集成起来形成中台技术体系,为各业务部门提供统一、高效的技术服务,避免各业务部门在各自业务发展的过程中进行重复的技术建设造成不必要的资源浪费与时间消耗。对于数据挖掘技术而言,中台发展的思路同样适用,并且从长远来看,构建数据挖掘中台技术体系也是绝对有必要的。

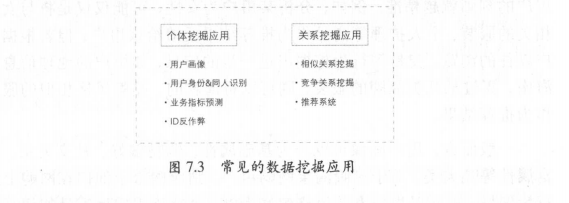

就数据挖掘的商业场景而言,可以分为两大类应用:个体挖掘应用与关系挖掘应用。个体挖掘应用指对单个实体的行为特征进行预测与分析,如预测某商品的销量、划分某行业的价格区间等;关系挖掘应用指研究多个实体间的关系特征,如商品的相似关系、竞争关系等。就数据挖掘技术而言,其包含两大要素:数据和算法。数据是数据挖掘的起源与挖掘结果最终的承载形式,可以说任何数据挖掘的过程都是从数据里来,回数据里去,源于数据而高于数据:算法是数据挖掘的神经中枢,通过算法对原始数据进行加工,得到对业务更有价值的数据。因此,对于数据挖掘中台体系的设计也包含两大块:数据中台与算法中台;结合数据挖掘的商业场景,对这两大块的设计又分别从个体挖掘应用和关系挖掘应用两方面进行考虑。

在数据挖掘的过程中包含两类数据:特征数据与结果数据。这两类数据很好理解,比如要预测某商品的销量,那么算法需要的特征变量其实就是特征数据,算法最终输出的商品销量的预测结果就是结果数据。

对于特征数据,相信有一定数据挖掘工作经验的读者都知道,在挖掘项目中80%的时间可能都是在处理特征,这些特征的提取、清洗、标准化,以及基于业务场景的再组合和二次加工往往是我们工作内容的主体部分。试想,如果有一套标准、规范且索引方便的全局特征库,每个挖掘工程师只需访问几张物理表就能迅速地搜集到绝大部分自己想要的特征,是不是一件很酷的事情?同时,通过算法生成的结果数据也需要进行合理的分层存储。有的结果非常通用和基础化,可以在很多的业务场景中复用,有的结果则相对个性和场景化,只适用于某个具体的业务和产品,因此需要对结果数据进行合理的分层,有效隔离通用性强和个性 化强的结果,这样可以充分发挥通用性强的算法结果的作用,提升它的复用率,减少不必要的重复建设。

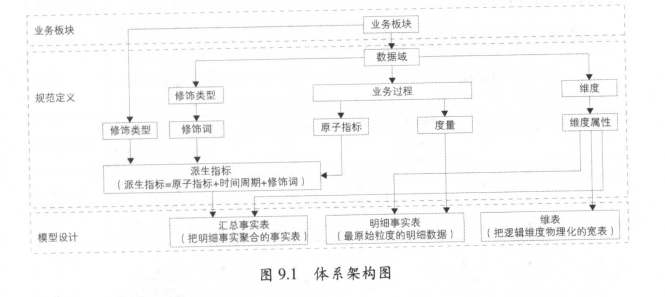

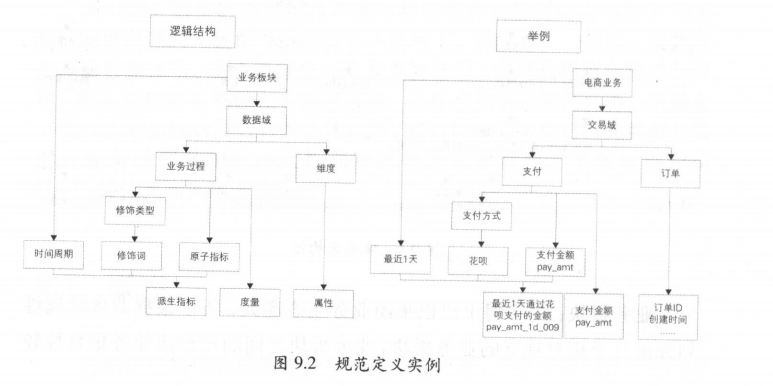

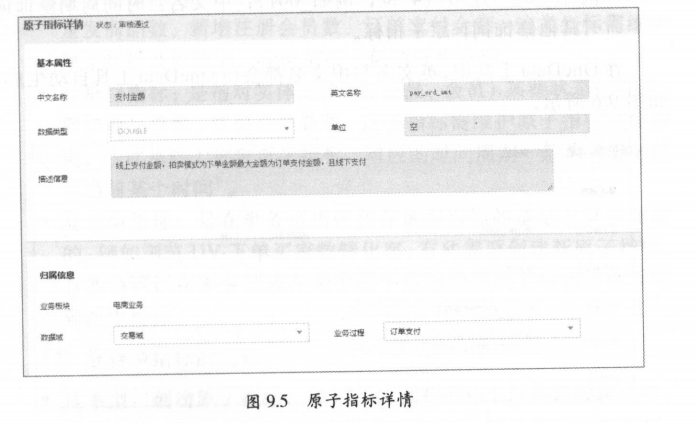

基于以上分析,我们把数据中台分为三层:特征层( Featural Data Mining Layer, FDM )、中间层和应用层( Application-oriented Data Mining Layer, ADM ),其中中间层包括个体中间层( Individual Data Mining Layer, IDM )和关系中间层( Relational Data Mining Layer, RDM ),如图7.2 所示。

不同数据层的作用有所区别:

• FDM 层:用于存储在模型训练前常用的特征指标,并进行统一的清洗和去噪处理,提升机器学习特征工程环节的效率。

• IDM 层:个体挖掘指标中间层,面向个体挖掘场景,用于存储通用性强的结果数据,主要包含商品、卖家、买家、行业等维度的个体数据挖掘的相关指标。

• RDM 层:关系挖掘指标中间层,面向关系挖掘场景,用于存储 ,通用性强的结果数据,主要包含商品间的相似关系、竞争关系店铺间的相似关系、竞争关系等。

•ADM 层:用来沉淀比较个性偏应用的数据挖掘指标,比如用户偏好的类目、品牌等,这些数据已经过深度的加工处理,满足某一特点业务或产品的使用。

通过挖掘数据中台的建设,能够大幅度节省数据挖掘特征工程的工作时间,而中间层与应用层的分层设计则能更有效地管理通用的挖掘计算结果,大量减少重复的基础数据挖掘工作。

算法是数据挖掘的神经中枢,算法使用的方式往往决定应用的成败。理解算法的原理不难,难的是在理解原理的基础上如何能结合业务合理地运用算法。很多开发者对算法了如指掌,但发现结合实际的业务仍然会有很多困难,甚至会踩很多地雷或陷阱。例如,在阿里巴巴会员画像的建设中会发现标注样本的缺失是个很普遍的问题,预测一个用户是否有小孩,用传统的分类方法看似是顺理成章的选择,然而有监督的分类算法需要有可靠的标注数据,这个样本从哪里来?即使采用调研的方式,面对淘宝4 亿的活跃会员,也会显得十分苍白和无力。又如对于销量预测,方法的选型本身就是一个很头疼的问题,即使是熟知回归分析各种算法的工程师,如果没有极佳的业务经验和数据洞察能力,对于这个问题恐怕也没有太好的捷径找到最合适的方法。此时我们会想,如果能像金融领域的风控一样,有一套类似于评分卡建模的方法论和实操模板,那么处理业务问题的效率将会大大提升。而阿里巴巴数据挖掘算法中台建设的目的同样在于从各种各样的挖掘场景中抽象出有代表性的几类场景,并形成相应的方法论和实操模板。

按照个体挖掘应用和关系挖掘应用的分类方式,可以抽象出常见的几类数据挖掘应用场景一一在个体挖掘应用中,消费者画像与业务指标预测是两类非常有代表性的场景;而在关系挖掘应用中,相似关系与竞争关系是两类非常通用的关系挖掘应用,在此基础上构建的推荐系统与竞争分析系统,则是电商领域持续关注的两大热 门话题。

依托强大的云计算技术、算法平台与数据挖掘中台体系,近几年阿里巴巴集团沉淀了大量的电商数据挖掘案例,并逐步形成以商家、消费者、商品为核心要素的全域数据挖掘应用体系。本节以淘宝市场上的消费者群体为例,介绍用户画像和互联网反作弊领域中的相关应用案例。

在阿里巴巴旗下的淘宝网、虾米音乐上都不乏个性化推荐场景,淘宝、天猫平台上的众多商家则需要通过用户调研和产品研发来把握产品的目标入群和入群偏好,从而对用户投其所好。对用户有深刻的理解是网站推荐、企业经营制胜的重要一环。在传统企业中,获取用户的反馈信息耗时长、结果缺失,是个难关。然而,随着大数据热潮的兴起,快速捕捉海量用户行为并精确分析入群偏好等商业信息已经成为可能。作为个性化技术的重要基础,相比于传统企业的购物篮分析、问卷调查,在用户画像的塑造上具备技术的天然优势。

阿里全域数据提供了足够的数据基础,正是基于用户网购、搜索和娱乐影音等行为的数据洞察,可以利用数据分析辅以算法的视角对用户进行360 。全方位的特征刻画。那么,究竟什么是用户画像?通俗地讲,用户画像即是为用户打上各种各样的标签,如年龄、性别、职业、商品品牌偏好、商品类别偏好等。这些标签的数目越丰富,标签越细化,对用户的刻画就越精准。例如,分析某用户为女性,可能仅仅是将与女性相关的服装、个入护理等商品作为推荐结果反馈给该用户:但若根据用户以往的浏览、交易等行为挖掘出进一步的信息,如用户的地理信息为海南,买过某几类品牌的服装,则可以将薄款的、品牌风格相似的服装作为推荐结果。

一般而言,用户画像可以分为基础属性、购物偏好、社交关系、财富属性等几大类。对于刻画淘宝网购用户,则应侧重于他们在网购上的行为偏好。下面以用户女装风格偏好为例,讲解该用户标签是如何基于全域数据产出的。

购买过淘宝商品的读者对商品详情页都不会陌生,一件商品的关键特征除了反映在商品图片和详情页中以外,主要可以采集的信息是商品的标题以及参数描述。女装有哪些风格?首先需要将女装行业下的商品标题文本提取出来,对其进行分词,得到庞大的女装描绘词库。然而,淘宝商品的标题由卖家个入撰写,并不能保证其中的词语都与商品风格描述相关。因此,对于所得到的女装描绘词库,首先,需要根据词语权重去除无效的停用词,方法如计算 TF-IDF 值。其次,在女装商品的参数描述中,如果已经包含了一种商品风格,例如“通勤”“韩版”等常见风格,那么通过计算词库中词语与参数描述中风格词的相似度,可以过滤得到女装风格词库,利用无监督机器学习如 LDA 等方法可以计算出一种风格所包含的词汇及这些词汇的重要性。那么,买家偏好什么风 格昵?在淘宝网上,买家拥有浏览、搜索、点击、收藏、加购物车以及交易等多种行为,针对每种行为赋予不同的行为强度(比如浏览行为强度弱于交易行为),再考虑该商品的风格元素组成,就能够通过合理的方式获知买家对该风格的偏好程度了。

对于这样的商品偏好计算,数据挖掘入员需要仔细分析用户偏好的商品的类型、品牌、风格元素、下单时间,这一系列行为可以构成复杂的行为模块。同理,利用机器学习算法,可以从用户行为中推测其身份,例如男生和女生、老年与青年偏好的商品和行为方式存在区别,根据一定的用户标记,最后能够预测出用户的基础身份信息。

在人们享受互联网带来的便捷和高效时,有一批人将其黑手伸向了这一领域,他们利用某些网站的技术和业务漏洞进行作弊,从而满足自己的灰色利益需求。可以看到,作弊黑产业链的滋生与发展使得入们的信息安全、资金安全,甚至入身安全面临着严重威胁。从业务上看,反作弊工作主要体现在以下几个方面:

(1)账户/资金安全与网络欺诈防控

账户的安全性越来越重要,尤其是购物和理财的网站或 APP ,其账户以及资金的安全更是维持用户信任的最后一道防线。账户隐私数据的泄露和非法交易问题不容忽视。

(2)非人行为和账户识别

大量的非人行为和账户利用自动化程序来模拟人的注册、浏览、点击等行为,帮助一些商家达到提升商品排名或者攻击竞争对手的目的。

(3)虚假订单与信用炒作识别

在平台类电商网站中,随着商家之间的竞争升级,虚假订单和信用炒作逐渐成为许多商家依赖的竞争手段。当下,虚假销量与 GMV 正在毒害健康的经营环境。

(4)广告推广与 APP 安装反作弊

正当大量的企业开始投入人力和财力进行公司产品和品牌的宣传推广时,也有人通过自动化程序或者人工的方式产生虚假的点击和浏览行为,以此打击竞争对手,或者是从中获取直接的经济利益。同样在无线端,在 APP 以 CPA 为主要推广结算方式的情况下,大量的专业刷装机量的公司为很多 APP 产生虚假的装机量数据,以此达到各方获取不正当利益的目的。

(5) UGC 恶意信息检测

用户在各类网站上产生的 UGC 信息,本可以帮助网站更好地了解用户的使用习惯以及潜在需求,帮助优化网站或者产品。但是,很多人却利用文本、图片、声音、视频等内容的复杂性和多样性,恶意传播色情、诈骗、谣言、暴力等不正当信息,给互联网环境造成了很大的威胁。

随着作弊场景和手法的不断变化,各个维度的安全技术也在不断升级保护正常用户免受黑色利益链条的侵害,其中包括物理安全、网络安全、应用安全、数据安全等方面。在数据安全的保障工作中数据挖掘算法也扮演着十分重要的作用。从所采用的算法技术上说,反作弊方法主要包括如下几类:

(1)基于业务规则的方法

这类方法主要是根据实际的业务场景,不断地发现总结作弊和获利手法,通过反作弊规则的不断拓展或产品设计的完善来识别、缓解甚至消除作弊现象。比如在电商产品的搜索排名中,对刷单的销量采取类似于降权的处理方式,避免市场秩序受到影响,以此减少商家的刷单行为带来的不正当利益。或者是在 APP 安装反作弊工作中,通过查看单个设备的单日出现城市数、登录账号数、设备 id 合法性等建立规则来衡量作弊情况。

这类方法的优点是精度高、可解释性强,能准确识别老的作弊方式;

缺点是人力成本高,而且对新的作弊手法滞后性较强。

(2)基于有监督学习的方法

将基于有监督学习的方法应用于反作弊工作中,其基本思路是按照有监督分类算法的流程来建模,通过正负样本标记、特征提取、模型训练及预测等过程来识别作弊行为。比如在账户反欺诈场景下,以账户的属性信息和行为数据作为模型特征输入,以历史的欺诈事件作为标记样本,通过训练分类模型对当前账户的作弊风险进行预测评估。但在反作弊领域内,此类方法遇到的最大问题是类不平衡现象。因为绝大多数用户及行为都是正常的,只有少数一些用户及行为是恶意的。比如相对于正常用户的转账行为,资金欺诈行为数量是极少的,但是这些极少的行为可能给用户带来无法挽回的经济损失。为了缓解这一问题,我们会在采样或者模型训练过程中进行一些技术处理,以减少类不平衡给识别结果造成的影响。这类方法的优点是通用性强,人力成本主要集中在样本的标记和特征的处理上;缺点是有些算法结果的可解释性不强,容易造成错判,需要辅以其他指标和方法进行综合判断。

(3)基于无监督学习的方法

在此类方法中较常见的是异常检测算法,该方法假设作弊行为极其罕见且在某些特征维度下和正常行为能够明显地区分开来。所以,假设检验、统计分析、聚类分析等手段常被用来做异常检测。比如我们发现账户的网站访问时间段分布有一定的规律,和入们日常的作息时间具有相关性,如果某个账户长期在凌晨发生大量的访问行为且转化率较低,那么就需要适当提高对应账户的风险等级。可以采用类似于上述算法,然后辅以一定的业务知识来综合判断行为的风险情况。此类方法的优点是不需要标记正负样本,而且检测到的异常行为还可以沉淀到规则系统中;缺点是特征设计和提取的工作量大,需要在所有可能的风险维度下刻画行为特征。

除了上述方法外,类似于多媒体数据处理、图计算模型等方法也逐渐被用来处理反作弊问题。

此外,在实际应用中,上述几种方法并不是完全割裂的,有可能一个完整的反作弊系统会同时使用所有方法。而且,除了算法理论方面的工作外,在算法实现方面我们还会遇到很多问题,因此算法的实际应用工作也是十分重要的。这部分工作主要分为以下两个方面:

(1)离线反作弊系统

离线反作弊系统主要包含规则判断、分类识别、异常检测等模块,通过历史行为和业务规则的沉淀,来判断未来行为的作弊情况。其优点是准确率较高,所使用的历史数据越多,判断结果越准确:缺点是时效性较差,无法及时给出判断结果。

(2)实时反作弊系统

随着在某些场景下对时效性要求的不断提高,人们逐渐发现实时反作弊系统的必要性和重要性。所以,将离线中的许多规则和算法进行总结,在基本满足准确率和覆盖率的前提下抽取出其中计算速度较快的部分,以此来满足对实时性的要求。但是要求高的实时性可能要以一定的准确率为代价,而且由于数据需要进行实时采集和计算,所以对数据存储和计算系统的性能要求也非常高。

通过对现有的作弊以及反作弊相关内容的介绍,我们可以看到,这一领域的很多问题暂时未得到解决,未来还面临着诸多挑战。比如:

(1)作弊手段的多样性和多变性

随着黑产公司的规模化和“正规”化,作弊与获利手段的多样性和多变性越来越明显,而反作弊系统如何能更及时地发现识别出新的手法和灰色利益链条,这是挖掘算法所面临的一个重要挑战。

(2)算法的及时性和准确性

由于普通用户的隐私和安全意识越来越强,所以反作弊系统的准确性和及时性要求越来越高,不仅要尽可能减少误判的情况,还需要及时发现真正的作弊行为,在给用户造成更大的损失之前对其实施有效的控制措施。

(3)数据及作弊手段的沉淀和逆向反馈

随着反作弊系统的升级改造,算法工程师无论在业务还是算法上都积累了相当多的数据和经验,如何将这些作弊手法以及反作弊手段进行通用性的沉淀,以及高效地逆向反馈到新的反作弊系统中,保证算法能紧跟市场脚步,也是反作弊工程师需要考虑的重要问题。

大数据时代为入们带来了丰富的基础数据和应用方式,也对信息安全提出了更高的要求,相信数据挖掘领域的不断发展能为这一方面的工作带来创新和突破。

·第8 章 大数据领域建模综述

·第9 章 阿里巴巴数据整合及管理体系

·第10 章 维度设计

·第 11 章 事实表设计

随着 DT 时代互联网、智能设备及其他信息技术的发展,数据爆发式增长,如何将这些数据进行有序、有结构地分类组织和存储是我们面临的一个挑战。

如果把数据看作图书馆里的书,我们希望看到它们在书架上分门别类地放置;如果把数据看作城市的建筑,我们希望城市规划布局合理;如果把数据看作电脑文件和文件夹,我们希望按照自己的习惯有很好的文件夹组织方式,而不是糟糕棍乱的桌面,经常为找一个文件而不知所措。

数据模型就是数据组织和存储方法,它强调从业务、数据存取和使用角度合理存储数据。 Linux 的创始入 Torvalds 有一段关于“什么才是优秀程序员”的话:“烂程序员关心的是代码,好程序员关心的是数据结构和它们之间的关系”,其阐述了数据模型的重要性。有了适合业务和基础数据存储环境的模型,那么大数据就能获得以下好处。

·性能:良好的数据模型能帮助我们快速查询所需要的数据,减少数据的I/O 吞吐。

·成本:良好的数据模型能极大地减少不必要的数据冗余,也能实现计算结果复用,极大地降低大数据系统中的存储和计算成本。

·效率:良好的数据模型能极大地改善用户使用数据的体验,提高使用数据的效率。

·质量:良好的数据模型能改善数据统计口径的不一致性,减少数据计算错误的可能性。

因此,毋庸置疑,大数据系统需要数据模型方法来帮助更好地组织和存储数据,以便在性能、成本、效率和质量之间取得最佳平衡。

E.F .Codd 是关系数据库的鼻祖,他首次提出了数据库系统的关系模型,开创了数据库关系方法和关系数据理论的研究。随着一大批大型关系数据库商业软件(如 Oracle 、 lnformix 、 DB2 等)的兴起,现代企业信息系统几乎都使用关系数据库来存储、加工和处理数据。数据仓库系统也不例外,大量的数据仓库系统依托强大的关系数据库能力存储和处理数据,其采用的数据模型方法也是基于关系数据库理论的。虽然近年来大数据的存储和计算基础设施在分布式方面有了飞速的发展,NoSQL 技术也曾流行一时,但是不管是 Hadoop 、 Spark 还是阿里巴巴集团的 MaxCompute 系统,仍然在大规模使用 SQL 进行数据的加工和处理,仍然在用 Table 存储数据,仍然在使用关系理论描述数据之间的关系,只是在大数据领域,基于其数据存取的特点在关系数据模型的范式上有了不同的选择而已。关于范式的详细说明和定义,以及其他一些关系数据库的理论是大数据领域建模的基础,有兴趣的读者可以参考相关的经典数据库理论书籍,如《数据库系统概念》。

OLTP 系统通常面向的主要数据操作是随机读写,主要采用满足3NF 的实体关系模型存储数据,从而在事务处理中解决数据的冗余和一致性问题;而 OLAP 系统面向的主要数据操作是批量读写,事务处理中的一致性不是 OLAP 所关注的,其主要关注数据的整合,以及在一次性的复杂大数据查询和处理中的性能,因此它需要采用一些不同的数据建模方法。

数据仓库之父 Bill Inmon 提出的建模方法是从全企业的高度设计一个3NF 模型,用实体关系( Entity Relationship, ER )模型描述企业业务,在范式理论上符合3NF 。数据仓库中的3NF 与 OLTP 系统中的3NF的区别在于,它是站在企业角度面向主题的抽象,而不是针对某个具体业务流程的实体对象关系的抽象。其具有以下几个特点:

·需要全面了解企业业务和数据。

·实施周期非常长。

·对建模入员的能力要求非常高。

采用 ER 模型建设数据仓库模型的出发点是整合数据,将各个系统中的数据以整个企业角度按主题进行相似性组合和合并,并进行一致性处理,为数据分析决策服务,但是并不能直接用于分析决策。

其建模步骤分为三个阶段。

·高层模型:一个高度抽象的模型,描述主要的主题以及主题间的关系,用于描述企业的业务总体概况。

·中层模型:在高层模型的基础上,细化主题的数据项。

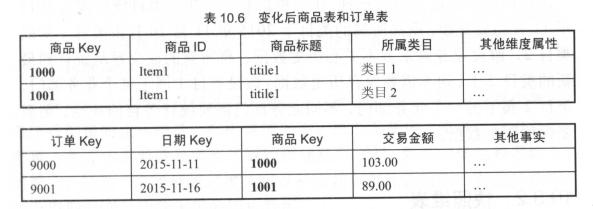

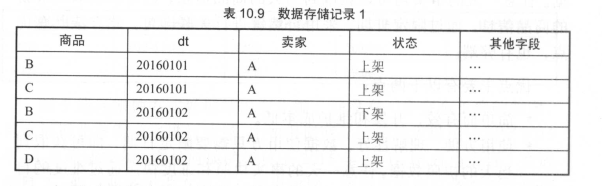

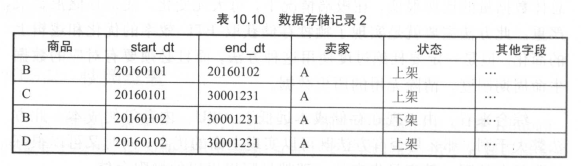

·物理模型(也叫底层模型):在中层模型的基础上,考虑物理存储,同时基于性能和平台特点进行物理属性的设计,也可能做一些表的合并、分区的设计等。