OpenUE is a lightweight toolkit for knowledge graph extraction.

OpenUE 是一个轻量级知识图谱抽取工具。

特点

- 基于预训练语言模型的知识图谱抽取任务 (兼容BERT, Roberta等预训练模型.)

- 实体关系抽取

- 事件抽取

- 槽位和意图抽取

- 更多的任务

- 训练和测试接口

- 快速部署NLP模型

- python3.8

- requirements.txt

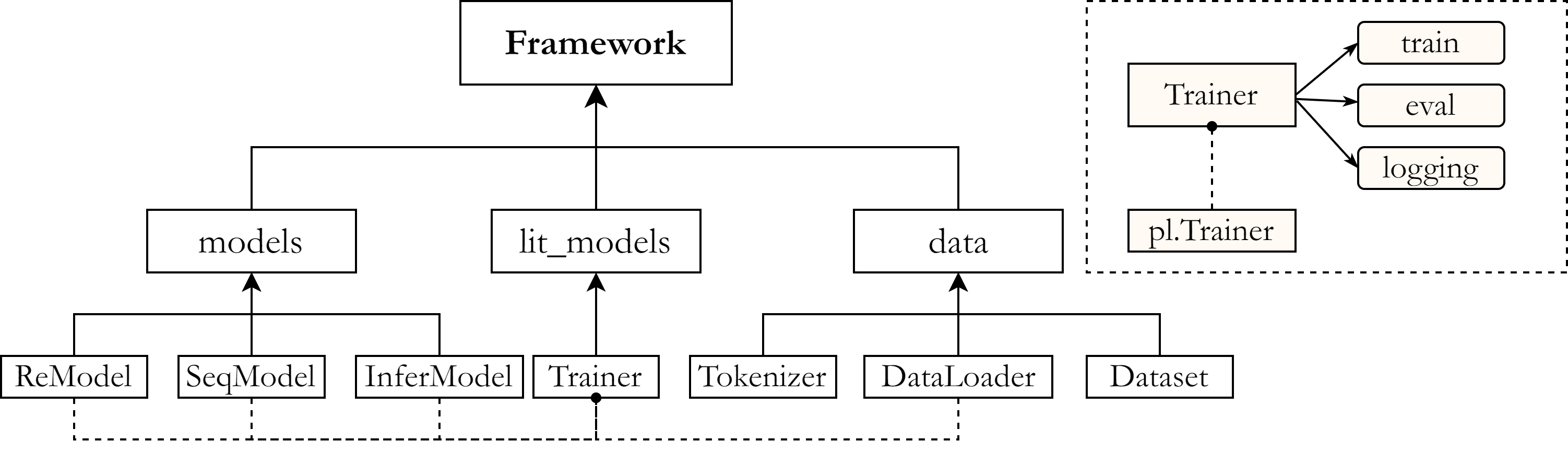

其中主要分为三个模块,models,lit_models和data模块。

其存放了我们主要的三个模型,针对整句的关系识别模型,针对已知句中关系的命名实体识别模型,还有将前两者整合起来的推理验证模型。其主要源自transformers库中的已定义好的预训练模型。

其中的代码主要继承自pytorch_lightning.Trainer。其可以自动构建单卡,多卡,GPU,TPU等不同硬件下的模型训练。我们在其中定义了training_steps和validation_step即可自动构建训练逻辑进行训练。

由于其硬件不敏感,所以我们可以使用多种不同环境下调用OpenUE训练模块。

data中存放了针对不同数据集进行不同操作的代码。使用了transformers库中的tokenizer先对数据进行分词处理再根据不同需要将数据变成我们需要的features。

conda create -n openue python=3.8

conda activate openue

pip install -r requirements.txt

conda install pytorch torchvision torchaudio cudatoolkit=11.1 -c pytorch -c nvidia # 视自己Nvidia驱动环境选择对应的cudatoolkit版本

python setup.py install

pip install openuepython setup.py develop数据格式为json文件,具体例子如下。

{

"text": "查尔斯·阿兰基斯(Charles Aránguiz),1989年4月17日出生于智利圣地亚哥,智利职业足球运动员,司职中场,效力于德国足球甲级联赛勒沃库森足球俱乐部",

"spo_list": [{

"predicate": "出生地",

"object_type": "地点",

"subject_type": "人物",

"object": "圣地亚哥",

"subject": "查尔斯·阿兰基斯"

}, {

"predicate": "出生日期",

"object_type": "Date",

"subject_type": "人物",

"object": "1989年4月17日",

"subject": "查尔斯·阿兰基斯"

}]

}将数据存放在./dataset/目录下之后进行训练。如目录为空,运行以下脚本,将自动下载数据集和预训练模型并开始训练,过程中请保持网络畅通以免模型和数据下载失败。

# 训练NER命名实体识别模块

./scripts/run_ner.sh

# 训练SEQ句中关系分类模块

./scripts/run_seq.sh下面使用一个小demo简要展示训练过程,其中仅训练一个batch来加速展示。

ske数据集训练notebook

使用中文数据集作为例子具体介绍了如何使用openue中的lit_models,models和data。方便用户构建自己的训练逻辑。

colab快速开始 使用colab云端环境,无需配置环境。

# 在代码中将logger 部分替换成wandb logger即可支持wandb

logger = pl.loggers.WandbLogger(project="openue")我们已经在deploy文件夹下放置了对应的部署类handler_seq.py和handler_ner.py。

# 使用torch-model-archiver 将模型文件进行打包,其中

# extra-files需要加入以下文件

# config.json, setup_config.json 针对模型和推理的配置config。

# vocab.txt : 分词器tokenizer所使用的字典

# model.py : 模型具体代码

torch-model-archiver --model-name BERTForNER_en \

--version 1.0 --serialized-file ./ner_en/pytorch_model.bin \

--handler ./deploy/handler.py \

--extra-files "./ner_en/config.json,./ner_en/setup_config.json,./ner_en/vocab.txt,./deploy/model.py" -f

# 将打包好的.mar文件加入到model-store文件夹下,并使用curl命令将打包的文件部署到docker中。

sudo cp ./BERTForSEQ_en.mar /home/model-server/model-store/

curl -v -X POST "http://localhost:3001/models?initial_workers=1&synchronous=false&url=BERTForSEQ_en.mar&batch_size=1&max_batch_delay=200"浙江大学:张宁豫、谢辛、毕祯、王泽元、陈想、余海阳、邓淑敏、叶宏彬、田玺、郑国轴、陈华钧

达摩院:陈漠沙、谭传奇、黄非

如果您使用或扩展我们的工作,请引用以下文章:

@inproceedings{zhang-2020-opennue,

title = "{O}pe{UE}: An Open Toolkit of Universal Extraction from Text",

author = "Ningyu Zhang, Shumin Deng, Zhen Bi, Haiyang Yu, Jiacheng Yang, Mosha Chen, Fei Huang, Wei Zhang, Huajun Chen",

year = "2020",

}