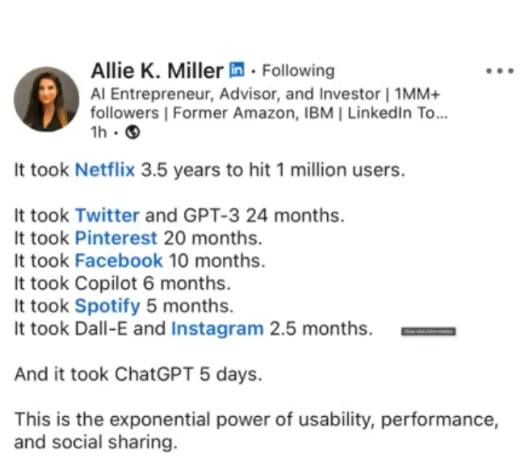

自2022年11月份OpenAI公布ChatGPT以来,ChatGPT在五天之内注册用户数就突破了百万

由此拉开了AIGC大模型的序幕,也有人称为是AI2.0时代,2023年3月14日又发布了GPT4,性能进一步得到提升,关于ChatGPT和GPT4为代码的文本生成以及Codex的代码生成等博客和论文层出不穷,这里对一些重点资料进行了整理归类,持续更新中......

欢迎加入AIGC技术交流群,与AI领域专家和各行各业的AIGC爱好者一起交流技术理论与行业信息!不管你是学术界还是工业界实践者或爱好者,都欢迎加入群体!

| 交流群二维码 | 拉你入群(备注AIGC-github) |

|---|---|

|

|

【论文分享】【AugGPT:利用ChatGPT进行文本数据增强 】[link]

【论文分享】【ChatGPT的鲁棒性探究——对抗性和分布外泛化的视角 】[link]

【论文分享】【传统检索模型和大语言模型在信息搜索中的应用和对比 】[link],[paper],[code],[blog]

【访谈】【OpenAI 的核心研发人员 Jack Rae 在参加 Stanford MLSys Seminar 的访谈时进行了一个名为 Compression for AGI的主题分享 】[访谈记录]

【访谈】【万字长文:想训大模型?这里有一份避坑指南】[访谈记录]

【访谈】【微软Bing版ChatGPT表明想做人类,并且对纽约时报专栏作家表达爱意】[访谈记录]

【访谈】【Midjourney创始人David Holz关于生成式AI的访谈】[访谈记录]

【访谈】【OpenAI创始人:GPT-4的研究起源和构建心法】[访谈记录]

【访谈】【ABC News 专访OpenAI首席执行官萨姆·奥尔特曼:AI风险和重塑社会的问题】[[访谈记录](OpenAI CEO Sam Altman says AI will reshape society, acknowledges risks: 'A little bit scared of this )]

【访谈】【OpenAI联合创始人Ilya Sutskever等专访:开源人工智能是不明智的】[访谈记录]

【访谈】【OpenAI董事长、CTO Greg Brockman专访 :GPT-4 并不完美,不过人无完人】[访谈记录]

【访谈】【图灵奖获得者 Yoshua Bengio 认为 ChatGPT 是一个“警钟”】[访谈记录]

【访谈】【《麻省理工科技评论》对 ChatGPT 幕后团队,进行了一次深入的独家专访】[访谈记录]

【访谈】【口述历史,探析ChatGPT的创造历程,ChatGPT内部故事】[访谈记录]

【访谈】【对话ChatGPT之父!AI会改变什么?不会改变什么?】[访谈记录]

【视频】【邱锡鹏教授介绍以ChatGPT为核心的大规模语言模型的相关知识及未来的发展方向 】[B站]

无需注册即可体验ChatGPT效果的一些网站

【LLM效果对比】【Bard_VS_Bing_VS_ChatGPT】[blog]

【LLM效果对比】【Bard_VS_文心一言】[blog]

【LLM效果对比】【文心一言_VS_ChatGLM-6B】[blog]

【LLM效果对比】【文心一言新闻发布会内容复现】[blog]

【LLM效果对比】【ChatGPT_VS_GPT4】[blog]

【LLM效果对比】【文心一言 VS GPT-4:20道问答PK】[blog]

【LLM效果对比】【文心一言 vs GPT-4实测!】[blog]

【ChatGPT专业评估】【一文看遍各行业对ChatGPT的专业评估】[blog]

【ChatGPT专业评估】【ChatGPT关于推理、幻觉和交互的多任务、多语言、多通道评估 】[paper]

【ChatGPT专业评估】【如何评价 OpenAI 的超级对话模型 ChatGPT ?】[paper]

【ChatGPT专业评估】【用ChatGPT参加计算机科学考试】[paper]

【论文&代码】【美国麻省大学&谷歌研究院:改写文本可以避开AI生成文本的检测器,但检索则是一种有效的防御】[paper],[code]

【论文】【人工智能生成的文本能被可靠地检测出来吗?】[paper],[blog]

【论文】【DetectGPT(斯坦福大学):利用概率曲率检测文本是否大模型生成】[paper],[blog],[code&data]

【论文】【Detecting LLM-Generated-Text综述】[paper],[blog]

【论文】【一个专为教育者打造的全新 AI 检测模型】[blog]

【论文】【OpenAI重磅发布官方「ChatGPT检测器」】[blog]

【复旦大学】【复旦大学教授肖仰华:ChatGPT 浪潮下,面向大模型如何做数据治理?】[blog]

【谷歌】【面向决策的基础模型: 问题、方法与机会】[paper]

【谷歌】【较大语言模型上下文学习的方式有所不同】[paper]

【谷歌】【通用语音识别大模型已经支持100+语言】[blog]

【谷歌】【发布5620亿参数多模态模型PaLM-E,机器人操控再上台阶】[paper],[blog],[twitter],[video]

【Huawei】【PanGu-Σ: 稀疏异构计算万亿参数语言模型研究参数语言模型】[paper]

【剑桥大学】【奖励聊天机器人在现实世界中与数以百万计的用户进行互动】[paper]

【LeCun】【人工智能系统最终是否需要以现实为基础,而不仅仅是从语言中学习?】[blog]

【LeCun】【大型语言模型是否需要感官基础来理解意义和理解?】[slices]

【LeCun】【ChatGPT是「外星人」,所以才会胡说八道】[paper],[blog]

【LeCun】【AI聊天机器人并不关注用户的社交属性】[blog]

【LeCun】【LeCun和马库斯齐喷ChatGPT:大语言模型果然是邪路?】[blog]

【LeCun】【ChatGPT无法实现通用人工智能,但ALM技术路线也许可以】[blog]

【LeCun】【「增强语言模型」的综述 】[paper]

【李开复】【AI进入2.0时代,所有应用都会被重写一遍 】[blog]

【纽约大学】【提出ILF(从语言反馈中模仿学习):利用语言反馈大规模训练语言模型】[paper]

【OpenAI】【GPT就是GPT:大模型对劳动力市场影响潜力的早期研究】[paper]

【OpenAI】【ABC News 专访OpenAI首席执行官萨姆·奥尔特曼:AI风险和重塑社会的问题】[blog]

【OpenAI】【最新发布通用人工智能路线图!AGI比想象中来得更快!】[blog]

【OpenAI】【Sam Altman 担心“潜在的可怕的”人工智能工具以及“未来的人们如何看待我们” 】[blog]

【PWC】【ChatGPT和生成式AI的11大安全趋势】[blog]

【清华大学】【张学工教授:AI技术前沿——从ChatGPT到更多突破】[blog]

【斯坦福】【研究大语言模型反映了谁的观点?】[paper],[code]

【斯坦福】【大模型及其公平使用】[paper]

【斯坦福】【构建大模型生态系统图,用于跟踪大模型的足迹】[blog]

【斯坦福】【斯坦福报告:基础模型的机遇与风险】[blog]

【微软】【一种新的大语言模型NLG评估框架】[paper]

【微软 & Meta】【ART:大型语言模型的自动多步骤推理和工具使用】[paper]

【博客】【NAACL & ACL:大模型的两种知识继承方案】[方案一],[方案二]

【博客】【LLM,压缩即泛化,泛化即智能】[blog]

【博客】【智慧信息的压缩:模型智能的涌现之道】[blog]

【博客】【拨动大模型的琴弦|Delta Tuning 成果登上 Nature子刊封面!】[blog]

【博客】【大型人工智能模型中出现的不可预测的能力】[blog]

【博客】【为什么现在的大语言模型(LLM)都是Decoder-only的架构?】[blog]

【博客】【大型语言模型的涌现能力】[blog]

【博客】【大型语言模型成本分析】[blog]

【博客】【超越ChatGPT:大模型的智能极限 】[blog]

【博客】【Nature:AI模型越大越好吗? 】[blog]

【博客】【一场关于ChatGPT话语权的深度思考:人类会在大模型中迷失自我吗?】[blog],[blog译文]

【博客】【马斯克强调的TruthGPT 是什么】[blog]

【博客】【对话式AI搜索的技术路线猜想】[blog]

【博客】【AI走过多少路,才迎来了ChatGPT?】[blog]

【博客】【如何负责任地创建、发布和共享生成式 AI】[blog]

【博客】【大模型时代的“Linux”生态,开启人工智能新十年】[blog]

【博客】【PEFT: 在低资源硬件上对十亿规模模型进行参数高效微调 】[blog]

【博客】【揭秘ChatGPT背后的AI“梦之队”:90后科研“后浪”展示强大创新能力|智谱研究报告】[blog]

【博客】【In-Context Learning玩法大全 】[blog]

【博客】【一文理解“上下文学习”----大语言模型突现能力】[blog]

【论文】【大模型微调指南:当GPU资源不足时的有效解决方案】[paper]

【论文】【TaskMatrix.AI: Completing Tasks by Connecting Foundation Models with Millions of APIs 】[paper]

【论文】【AnnoLLM: Making Large Language Models to Be Better Crowdsourced Annotators 】[paper]

【论文】【AIGC综述: 从GAN到ChatGPT的生成式人工智能简史 】[paper]

【论文】【卡内基·梅隆大学 | 语言生成模型可能造成危害:那么我们能做些什么呢?】[paper]

【论文】【鹏程实验室等最新《大规模多模态预训练模型》全面综述 】[paper]

【论文】【预训练基础模型综合调研:从 BERT 到 ChatGPT 的历史 】[paper]

【博客】【OpenAI 应用人工智能研究负责人Lilian Weng新博文:关于提示工程的介绍】[blog]

【博客】【Prompt Engineering全面自动化】[blog]

【博客】【ChatGPT提示示例集合】[地址],[code],huggingface]

【博客】【深入浅出Prompt Learning要旨及常用方法】[blog]

【博客】【ChatGPT火爆,最全prompt工程指南登GitHub热榜,标星4.7k!】[code],youtube]

【博客】【ChatGPT Prompt工程:设计、实践与思考】[blog]

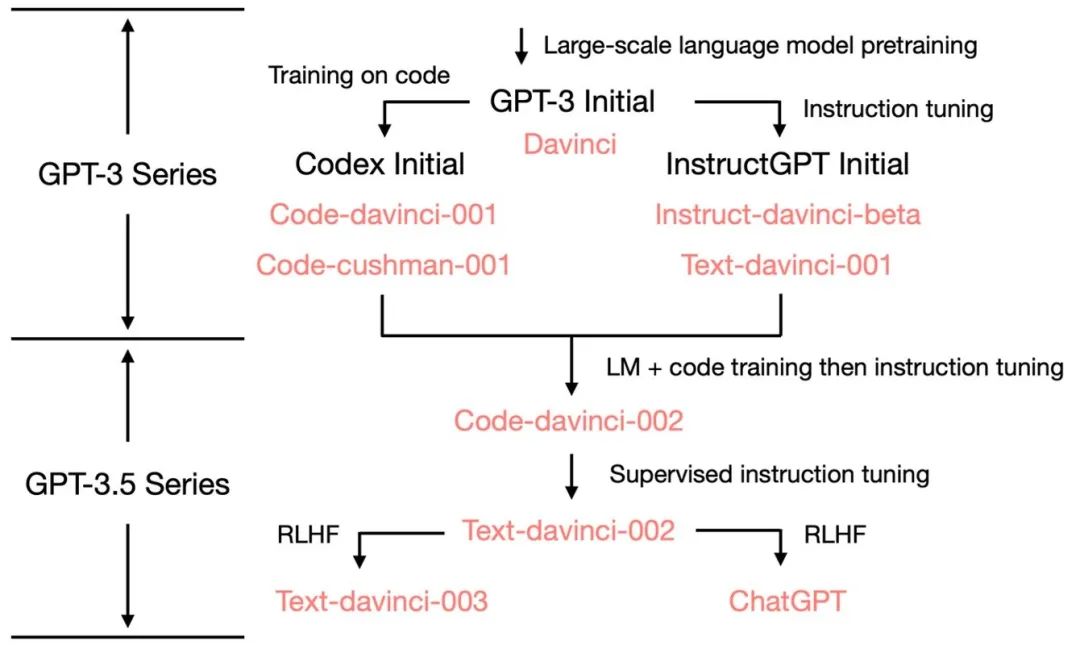

从GPT3到ChatGPT模型的发展路线图

【58】【从 GPT 到 ChatGPT 的演进与应用思考】[blog]

【中科院】【ChatGPT助力芯片,传统 EDA如何演变成智能EDA】[blog]

【微软】【《ChatGPT机器人:设计原则和模型能力》论文 】[paper]

【博客】【ChatGPT获得了「Wolfram」超能力】[blog]

【博客】【OpenAI开发Plugin将 ChatGPT 连接到互联网】[blog]

【博客】【ChatAug:利用ChatGPT进行文本数据增强】[paper]

【博客】【ChatGPT 是数据隐私的另一个障碍吗】[blog]

【博客】【基于ChatGPT的数据增强方法:ChatAug和AugGPT】[blog]

【博客】【Character.AI 在ChatGPT基础上加入个性化、UGC两大武器,有比 ChatGPT 更丰富的使用场景】[blog]

【博客】【让ChatGPT可以语音交互 】[blog]

【医疗】【ChatGPT爆火带来思考:医学界或将迎来与AI融合的奇点?】[blog]

【教育】【论ChatGPT大语言模型在教育中的机遇与挑战 】[blog]

【投资】【ChatGPT在投资研究领域的应用初探及原理分析】[blog]

【其他】【分析了ChatGPT技术以及落地应用场景 】[blog]

【工具】【ChatGPT 应用汇总及操作手册】[blog]

【工具】【ChatGPT提示和技巧速查手册】[blog]

【工具】【非常全面的ChatGPT、LLM相关资源整理分享】[code]

【工具】【ChatGPT超全面课程】[blog]

【工具】【BloombergGPT: A Large Language Model for Finance】[paper]

【工具】【ChatPDF:一键上传PDF文件即可解读 】[blog],[试用地址]

【工具】【Einstein GPT:SaaS 行业巨头 Salesforce 宣布与 OpenAI 合作,推出 Einstein GPT,这是全球首个用于客户关系管理(CRM)的生成式 AI 产品 】[Einstein GPT地址],[试用地址]

【工具】【HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in HuggingFace 】[paper]

【工具】【Visual ChatGPT: 在视觉模型加持下的ChatGPT,聊天生图全拿捏了。】[paper]

【工具】【ColossalAI:完整复现ChatGPT全流程】[code]

【工具】【ColossalChat:用于克隆 ChatGPT 和完整 RLHF 管道的开源解决方案】[code],[blog]

【工具】【ChatWeb:可爬取网页正文,并根据正文回答问题 】[code]

【工具】【OpenGpt:创建ChatGPT小应用的AI平台】[官网],[code]

【符尧】【深度拆解GPT-3.5能力起源】[原文blog],[译文blog]

【知乎】【ChatGPT发展历程、原理、技术架构详解和产业未来】[blog]

【斯坦福】【82页PPT !最新ChatGPT: 提示学习, 指导微调和RLHF 】[blog],[提取码:chat]

【微软】【让天下没有难训练的大模型,微软亚洲研究院开源TorchScale 】[code]

【亚马逊 】【他们提出了包含视觉特征的 Multimodal-CoT,该架构在参数量小于 10 亿的情况下,在 ScienceQA 基准测试中,比 GPT-3.5 高出 16 个百分点 】[paper],[code]

【博客】ChatGPT_Official_API_Learning

【博客】ChatGPT_Parameter_is_not_175B

【博客】ChatGPT_Road_Map_from_yao.fu

【博客】Lessons_Learned_from_ChatGPT_Recurrence

【博客】LLM_Pre-training_Guide(Bloom-175B)

【博客】【AI芯片制造商Cerebras发布7个基于GPT的大语言模型,现已开源】[官网地址 )],[GPT地址],[Hugging Face地址 ]

【博客】【大模型论文周报丨GPT-4发布,谷歌开放PaLM API,斯坦福7B开源模型Alpaca媲美GPT-3.5】[blog]

【博客】【LLaMA模型Meta版泄露,GitHub获8K星】[blog]

【博客】【ChatGPT or Grammarly? Evaluating ChatGPT on Grammatical Error Correction Benchmark 】[paper]

【博客】【打造中国版ChatGPT,国内哪家实力最强】[blog]

【博客】【复旦大学邱锡鹏教授解读ChatGPT】[blog]

【博客】【万字长文:可能是全网最晚的ChatGPT技术总结 】[blog]

【博客】【ChatGPT作为知识库问答系统的问答能力评测 】[blog]

【博客】【ChatGPT作者John Shulman:我们成功的秘密武器】[blog],[blog译文]

【博客】【ChatGPT 是数据隐私的另一个障碍吗】[blog]

【博客】【Hugging Face 每周速递: ChatGPT API 怎么用?我们帮你搭好页面了 】[blog]

【博客】【复旦大学教授肖仰华:ChatGPT 浪潮下,面向大模型如何做数据治理?】[blog]

【博客】【腾讯在ChatGPT的布局】[blog]

【博客】【浅析ChatGPT:历史沿革、应用现状及前景展望】[blog]

【博客】【ChatGPT 背后的“功臣”——人类反馈强化学习RLHF 技术详解】[blog]

【博客】【万字长文解析!复现和使用GPT-3/ChatGPT,你所应该知道的】[blog]

【博客】【想训练ChatGPT?得先弄明白Reward Model怎么训(附源码) 】[blog]

【博客】【ChatGPT核心技术:强化学习PPO算法】[blog]

【博客】【解读 ChatGPT 背后的技术重点:RLHF、IFT、CoT、红蓝对抗】[blog]

【论文】【ChatGPT is a Knowledgeable but Inexperienced Solver: An Investigation of Commonsense Problem in Large Language Models】[paper]

【论文】【GPT-3 和 GPT-3.5 系列模型的全面分析】[paper]

【论文】【ChatGPT Outperforms Crowd-Workers for Text-Annotation Tasks】[paper]

【论文】【微软&佐治亚理工学院 | AdaLoRA:自适应预算分配以实现参数有效的微调】[paper],[code]

【论文】【微软 | 大型语言模型的语境忠实提示法】[paper]

【论文】【KAUST | ChatGPT问,BLIP-2回答模型:面向丰富的视觉描述的自动提问】[paper],[code]

【论文】【ChatGPT真的可以取代知识图谱问答吗? 】[paper],[paper翻译]

【论文】【Meta & 斯坦福大学推出FlexGen:用单个GPU进行大型语言模型的高吞吐量生成性推理】[paper],[code]

【论文】【ChatGPT破圈的「秘密武器」:详解RLHF如何影响人类社会! 】[paper],[blog]

【论文】【探讨ChatGPT在对抗攻击和分布外泛化下的鲁棒性】[paper],[code]

【论文】【复旦清华联合顶刊发文|ChatGPT:潜力、前景和局限 】[blog],[paper]

【论文】【引导ChatGPT不要输出有害信息】[paper]

【论文】【Junnan Li大佬发表最新多模态的杰作BLIP2】[paper],[code],[blog]

【论文】【Instruction Tuning:无/少样本学习新范式 】[paper],[code]

【论文】【GPTScore:一种新的评估语言模型方法】[paper],[code]

【论文】【ChatGPT内核:InstructGPT,基于反馈指令的PPO强化学习】[blog],[B站]

【论文】【Fine-tune-CoT:小模型也能做推理,完美逆袭大模型 】[paper],[code]

【代码】【本科生60行代码教你手搓GPT大模型 】[code]

【博客】【GPT4_System_Card中文翻译】[blog]

【博客】【GPT4_Technical_Report中文翻译】[blog]

【纽约时报】【GPT-4 令人印象深刻但仍在 10 个方面具有缺陷】[blog]

【Open AI】【多模态大模型GPT-4的新突破】[blog]

【OpenAI】【重磅发布GPT-4】[blog]

【OpenAI】【GPT-4 创造者 Ilya Sutskever 谈 AI 幻觉和 AI 民主】[blog]

【OpenAI】【GPT-4创造者:第二次改变AI浪潮的方向】[blog]

【OpenAI】【当GPT-4进入北京市2022高考考场能有什么表现?】[blog]

【博客】GPT4技术细节

【博客】GPT4技术关键点总结

【论文】【点燃通用人工智能的火花:GPT-4的早期实验】[原始paper],[中文版paper]

【论文】【GPT4All:用GPT-3.5-Turbo的大规模数据提炼训练一个助理式聊天机器人】[paper],[code]

【论文】【美国东北大学:可以通过要求GPT4反思“你为什么错了?”来提高30%的性能】[paper],[code]

【谷歌再次开放Bard访问权,向着ChatGPT发起再一次攻击】[报名地址 ],[blog],[theverge]

【GPT3.5试用地址 】[试用地址]

【ChatGPT最强竞品Claude今日开放API】[产品地址 ],[申请地址 ],[API说明 ],[blog]

【ChatGLM:千亿基座的对话模型开启内测 ⸺对应单卡版本开源】[blog],[code]

【ChatYuan:基于PromptCLUE-large的中文对话开源大模型】[blog]

【GitHub Copilot X编辑器发布,大大提升编码速度 】[blog]

【声称它 "像ChatGPT一样神奇",但只需要使用一台机器在不到三个小时的时间里训练的数据少得多。】[blog],[Databricks Inc地址]

【ChatGPT开源平替OpenChatKit:参数量200亿,在4300万条指令上微调而成】[blog],[code],[测试链接],[模型权重],[数据集]

【LLaMA】【Meta开放小模型LLaMA,性能超过GPT-3】[paper],[code],[blog]

【LLaMA评测】[blog]

【Alpaca】【斯坦福发布了一个由LLaMA 7B微调的模型Alpaca(羊驼),训练3小时,性能比肩GPT-3.5】[blog],[官网],[model],[code]

【LLaMA-Adapter】【LLaMA-Adapter,一种用于微调指令遵循LLaMA模型的轻量级自适应方法,使用Stanford Alpaca提供的 52K 数据。】[paper],[code]

【lit-llama】【基于nanoGPT的LLaMA语言模型,支持量化、LoRA微调和预训练】[code]

【llama.cpp】【量化130亿参数LLaMA模型的llama.cpp,推理仅需4GB内存】[blog]

【Vicuna】【通过对从ShareGPT收集的用户共享对话进行微调的LLaMA训练,Vicuna-13B达到了OpenAI ChatGPT和Google Bard 90%*以上的质量 】[Vicuna官网地址]

【ChatLLaMA】【初创公司 Nebuly AI在LLaMA基础上加入RLHF 开源 ChatLLaMA 训练方法】[code]

【博客】【Genmo Chat】【这是一款创造性的copilot,使用GPT-4和一大套生成人工智能工具创建并编辑您需要的任何视频或图像。 】[blog]

【博客】【BlenderGPT】【一款基于GPT-4的扩展程序BlenderGPT开源,这是一个由GPT3/4驱动的全能AI编辑助手,为Blender提供支持 】[code]

【博客】【Firefly】【Adobe制造了一个人工智能图像生成器--并表示它没有窃取艺术家的作品来做这件事 】[blog]

【博客】【Bing Image Creator】【微软推出Bing Image Creator,用户可根据文本提示创建图片】[blog]

【博客】【Hugging Face 现已支持使用达摩院text-to-video模型从文本生成视频】[模型地址 ]

【论文】【最新女娲大模型,中科院提出NUWA-XL:扩散模型中的扩散,生成超长视频】[paper],[blog]

【论文】【艾伦AI研究院 & 华盛顿大学 | CHAMPAGNE:从大规模的网络视频中学习真实世界的对话】[paper],[code]

【论文】【用AI直接复现你在想什么,Stable Diffusion逼真复现图像】[paper],[blog]

【论文】【Stable Diffusion公司新作Gen-1:基于扩散模型的视频合成新模型,加特效杠杠的!】[paper],[site]

【论文】【使用Diffusers 实现 ControlNet 高速推理】[blog]

【论文】【文生图引入ControlNet,深度、边缘信息全能复用 】[paper],[code]

【论文】【ChatGPT|可用于AI绘画,效果飞升47% 】[paper]

【论文】【北京大学:具有大语言模型的自我规划代码生成】[paper]

【论文】【MIT最新研究:利用大预言模型生成Code】[paper],[code],[项目网址]

【论文】【Baldur: 基于大型语言模型的完全证明生成与修复】[paper]

【论文】【MathPrompter: 基于大型语言模型的数学推理】[paper]

【论文】【MIT最新研究:利用大语言模型生成Code】[paper],[code],[官网地址]

【论文】【CodeGeeX: A Pre-Trained Model for Code Generation with Multilingual Evaluations on HumanEval-X 】[paper],[code]

【论文】【文字、图片一键生成逼真音效,音频界AIGC来了 】[paper],[code]

【论文】【清华朱军团队开源UniDiffuser:首个基于Transformer的多模态扩散大模型!文图互生、改写全拿下! 】[paper],[code]

【👬🏻】欢迎Star ⭐️⭐️⭐️⭐️⭐️ && 提交 Pull requests 👏🏻👏🏻👏🏻

个人主页:wshzd.github.io

微信公众号:

以上部分资料来自网络整理,供大家学习参考,如有侵权,麻烦联系我删除!

WeChat:h18821656387