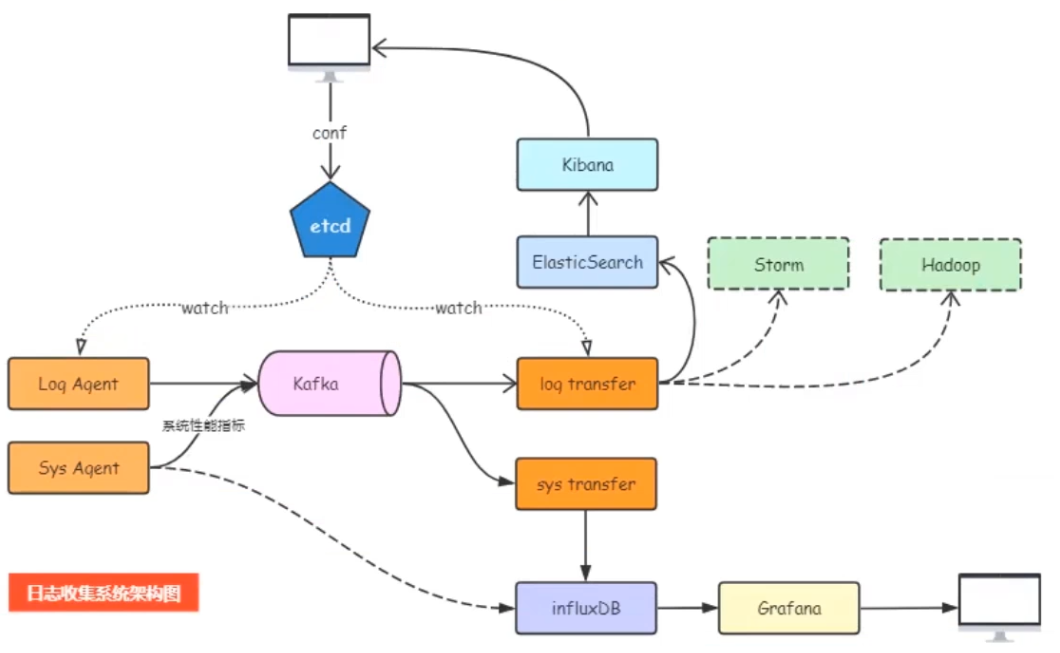

- 通过将topic以及日志文件放到到etcd中,

- logagent从etcd 中获取到topic和日志文件

- 利用taillog模块,从日志文件中取出日志,放到kafka中

- 通过logtransfers,并将消息写道elasticsearch中

- 前端使用kibana就可以查看到放到elasticsearch的数据

- 配置jdk

- 安装zookeeper

- 安装kafka

- 安装etcd

zookeeper-server-start.bat ..\..\config\zookeeper.properties kafka-server-start.bat ..\..\config\server.properties .\bin\windows\kafka-topics.bat --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test .\bin\windows\kafka-topics.bat --list --zookeeper localhost:2181 .\bin\windows\kafka-console-producer.bat --broker-list localhost:9092 --topic test .\bin\windows\kafka-console-consumer.bat --bootstrap-server localhost:9092 --topic test --from-beginning至此上述启动成功,说明我们搭建的环境没有问题

执行etcd.exe即可

etcdctl.exe --endpoints=http://127.0.0.1:2379 put xxxx "xxxx"

etcdctl.exe --endpoints=http://127.0.0.1:2379 get xxxx